프레임 워크는 사용자가 예제 스타일 이미지를 제공하여 변환 출력의 스타일을 제어할 수 있도록 하며, 코드 및 사전 훈련된 모델에서 사용할 수 있다

지금까지는 주로 인간의 개입에 의한 인공지능이 대부분을 차지하고 있었지만 인간의 개입 및 학습 데이터가 없어도 스스로 학습하는 신경망, 서로 대립하는 두 시스템이 서로 경쟁하는 방식으로 학습을 진행하는 비지도 학습방식의 신경망을 '적대적 생성 신경망 또는 생성적 적대 신경망(GAN, Generative Adversarial Network)'이라 한다.

또 두개의 시스템(모델)으로 하나는 생성기/생성자(G, Generator) 이며, 또 하나는 분류기/판별자(D, Discriminator)로 두 모델은 학습하면서 서로에게 영향을 미치며 고도화된다.

적대적 생성 신경망(GAN)은 지난 2014년 신경정보처리시스템 학회(NIPS, Neural Information Processing System)에서 처음 발표됐다. 이후 2016년 NIPS에서 GAN 튜토리얼이 진행되면서 GAN의 가능성과 잠재력에 대한 학계와 산업계의 큰 주목을 받으면서 지난해 7월 구글 딥 마인드는 사람과 물체의 동작이나 보행 능력을 흉내 내는 인공지능을 개발했으며, 인실리코 메디슨은 신약에 활용될 새로운 화합물을 개발하기 시작했다.

특히 지난해 10월 독일 뮌헨에서 열린 엔비디아 ‘GTC 유럽’ 행사에서 캠브리지 컨설턴트(Cambridge Consultants)의 딥러닝 기반 애플리케이션인 ‘빈센트(Vincent) AI’의 공개 시연을 진행했었다. 빈센트 애플리케이션은 사용자가 스타일러스를 사용해 간단히 스케치한 그림을 실시간으로 19세기 영국 풍경화가인 J.M.W. 터너의 유화나 네온 색상의 팝아트 등 7가지 스타일의 예술작품으로 완성시켰으며, 젠슨 황 CEO가 기조연설 도중 무대에서 내려와 스타일러스를 직접 들고 엔비디아 로고와 사람의 얼굴을 그렸으며, 실시간으로 해당 스케치가 피카소풍의 그림으로 바뀌자 3천 명 이상의 참석자들의 탄성을 자아내기도 했다.

이처럼 빈센트 AI의 놀라운 성능 뒤에는 정밀한 튜닝작업을 거친 GAN(Generative Adversarial Network), 즉 적대적 생성 신경망이 있었다. 캠브리지 컨설턴트의 AI 연구실인 디지털 그린하우스(Digital Greenhouse)가 수천 시간을 들여 연구한 성과를 토대로, 5명으로 구성된 팀은 8천 개의 예술 작품을 샘플링해 엔비디아 DGX 시스템에서 14시간의 트레이닝을 거쳐 단 두 달 만에 빈센트 데모를 구축해낼 수 있었다.

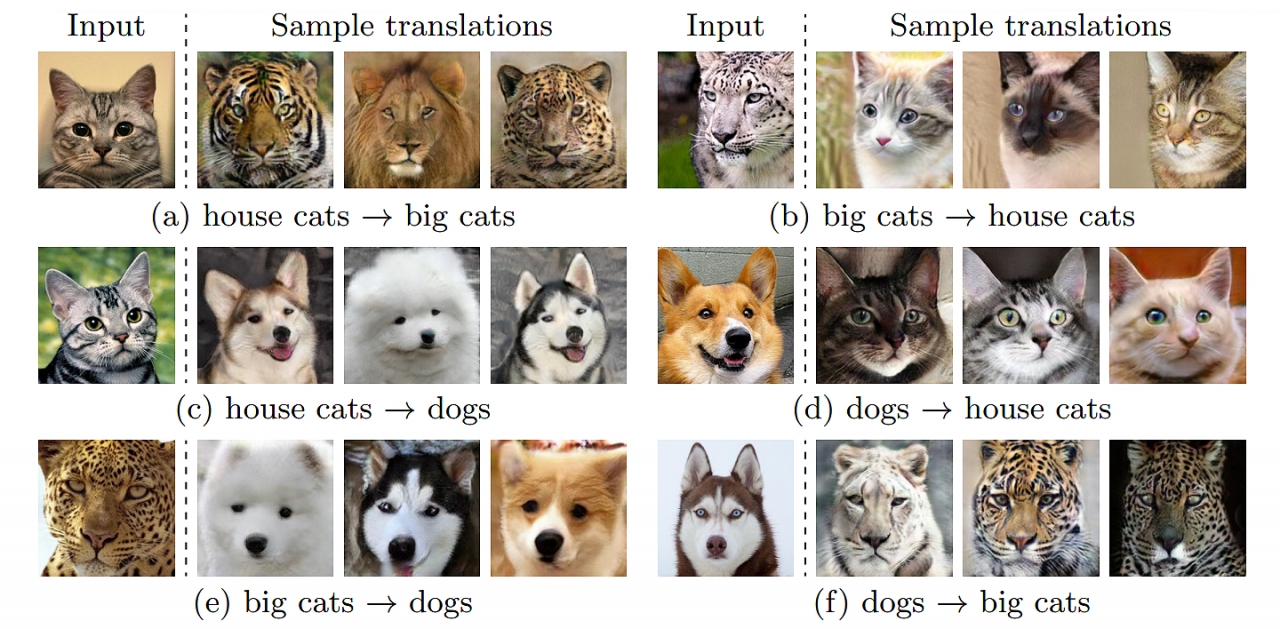

무엇보다도 GAN의 대표적인 응용 분야는 이미지 자동 생성이다. 대략적인 스케치가 입력 값으로 투입되었을 때 이 스케치에 해당하는 이미지를 스스로 생성하는 기능이다. 이미지 변환은 컴퓨터 비전과 인공지능에서 중요하고 도전적인 문제이자 한 부분을 차지한다. 원본 이미지가 주어지면 목표는 해당 이미지의 쌍을 보지 않고 대상 도메인에서 해당 이미지의 조건부 배포를 배우는 것입니다. 이 조건부 분포는 본질적으로 멀티 모달이지만 기존의 접근 방식은 지나치게 단순화된 가정을 만들어 결정적 1 대 1 매핑으로 모델링한다.

하지만 결과적으로 특정 원본 이미지에서 다양한 출력을 생성하지 못한다. 이 제한을 해결하기 위해 코넬대학과 엔비디아(NVIDIA)의 연구진은 1 장의 사진을 다양한 이미지로 변환하는 적대 생성 학습을 이용한 프레임 워크 '무니트(MUNIT, Multimodal Unsupervised Image-to-image Translation)'를 12일 논문을 통해 발표됐다.

이미지를 변환하려면, 컴퓨터 프로세스와 그에 대하여 허용된 조작, 다시 말해서 접근할 수 있는 권리를 조합한 개념으로 대상 도메인의 스타일 공간에서 샘플링된 임의의 스타일 코드로 콘텐츠 코드를 재결합시킨다. 제안된 프레임 워크를 분석하고 몇 가지 이론적 결과를 수립하고 최첨단 접근 방식과의 비교를 통한 폭 넓은 실험을 통해 제안된 프레임 워크의 장점을 더욱 입증 할 수 있다. 또한, 프레임 워크는 사용자가 예제 스타일 이미지를 제공하여 변환 출력의 스타일을 제어할 수 있도록 하며, 코드 및 사전 훈련된 모델에서 사용할 수 있다.

한편 아래 영상은 15일 이번 발표된 논문의 저자 중의 한명인 엔비디아의 리밍 유(Ming-Yu Liu)가 공개한 영상이며, 발표된 적대적 생성 신경망(GAN)을 이용한 프레임 워크, 무니트(MUNIT)의 논문 원제는 "Multimodal Unsupervised Image-to-Image Translation" 이다.(논문 다운받기)

.