로봇에게 인간과 비슷한 감각 체계를 갖게 하기 위한 노력이 활발하다. 이를 통해 보다 똑똑한 서비스를 구축할 수 있도록 돕고 주변 환경 이해, 손과 팔의 움직임, 물체 감지 및 인식 등에서 인간 수준의 이해를 구현하기 위한 것이다.

또 우수한 로봇을 보유하고 있음에도 불구하고 사람처럼 지능적이고 유연한 기능을 로봇에게 요구하는 것은 여전히 어렵다. 이는 로봇은 미리 정의된 모양과 위치가 있는 구조화된 환경에서만 작동하는 경향이 있고 일반적으로 다양한 형태의 불확실성에 대처할 수는 능력을 요구하기에는 매우 어렵다.

그러나 최근 몇 년 동안 로봇에게 인공지능(AI)이 접목되면서 이 문제를 다소 해결되기도 했다. 하지만 여전히 우리가 로봇에게 더 다양한 서비스와 작업을 맡기길 원한다면 우리는 로봇에게 좀 더 다재다능한 학습과 기능을 제공해야 한다. 이에 본지는 로봇을 인간과 더 가깝게 다가갈 수 있는 로봇을 학습시키는데 사용하고 도움이 될 수 있는 대표적인 8개의 '오픈 소스 데이터 세트(Open-Source Datasets)'를 소개한다.[편집자]

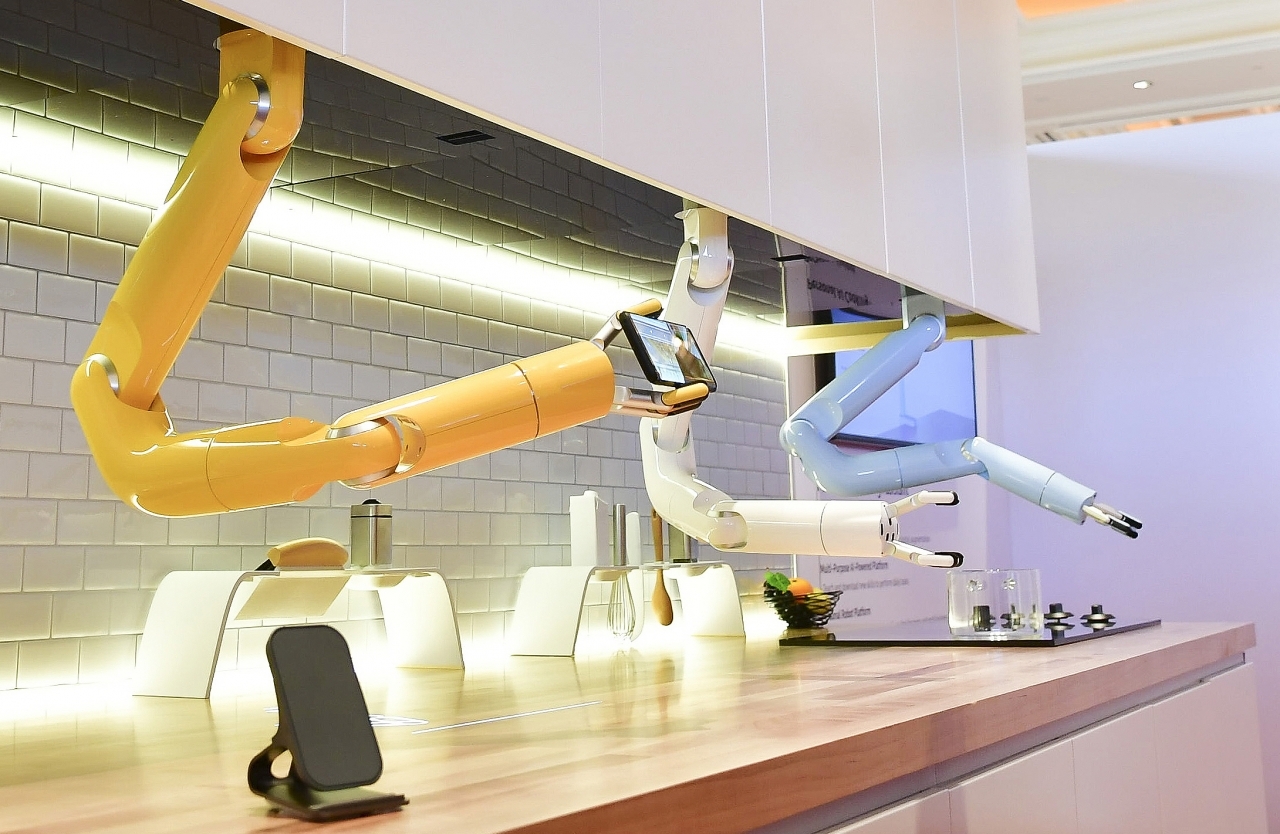

1> 로봇 암 푸싱 데이터 세트(Robot Arm Pushing Dataset)

이 데이터 세트의 주요 애플리케이션 중 하나는 시각적 기반 로봇 제어 작업에 대한 의사 결정을 위해 학습된 모델에 이를 구현하는 것이다. 로봇 암 푸시 데이터 세트에는 교육 세트(트레인) 1개 및 테스트 세트 2개를 포함하여 약 5만9,000개의 로봇 푸시 동작(모션) 예제가 포함되어 있다. 첫 번째 테스트 세트는 훈련 중에 밀린 물체의 서로 다른 두 하위 세트를 사용했으며, 두 번째 테스트 세트에는 두 개의 하위 집합이 포함되었다.(데이터셋 다운받기, 관련 연구논문 다운받기)

2> 로봇 팔 붙잡기 데이터 세트(Robot Arm Grasping Dataset)

로봇은 다양한 형태(비정형)의 개별 항목을 골라 집어내는 작업에는 여전히 어려움이 따르고 있다. 이 데이터 세트는 주로 그리퍼(Gripper)의 작업 공간 동작이 성공적으로 이루어질 가능성을 예측하기 위한 AI 컨볼루션 신경망(CNN, Convolutional Neural Network)을 훈련시키기 위해 만들어졌다.

또한 로봇이 물건을 집을 때 적절한 압력을 사용해 섬세하게 쥐고 잡는 인간의 손의 능력을 모방할 수 있는 학습용으로 약 65만 개의 그리퍼(Gripper)의 동작 사례가 포함되어 있으며, 기능 설명 및 개수 시트는 파악 데이터 세트에서 각 기능의 의미를 설명하고 어떤 배치에 어떤 기능이 포함되어 있는지 보여준다.(데이터 세트 다운받기, 관련 연구논문 다운받기)

3> 일일 상호작용 조작 데이터 세트(Dataset Of Daily Interactive Manipulation)

로봇은 인간이 당연하게 여기는 가장 간단한 일일 업무를 완수하기 위해서도 상당한 어려움을 겪는다. 환경의 변화로 인해 작업이 극도로 어려워지기 때문이다. 데이터 세트는 로봇이 변화하는 환경에서 사람의 시연을 이용하여 매일 상호작용 조작을 학습시키기 위해 상호작용 조작에 대한 데이터를 수집했다.

이 데이터 세트는 요리를 하거나, 드라이버로 나사를 조이는 것, 망치로 못을 박는 등 매일 작업에서 조작되는 물체의 위치, 방향, 힘 및 토크에 초점을 맞췄다.

데이터 세트는 두 부분으로 구성된다. 첫 번째 부분에는 32가지 모션 유형을 다루는 1,483개의 평가판이 포함되어 있다. 사람들이 일상생활에서 다양한 대상과의 상호 작용을 포함하여 일반적으로 수행하는 이상적인 동작을 선택한다. 또 모션의 다른 서브 세트는 여러 개의 모션 관련 데이터 세트에서 찾을 수 있다. 수집된 동작에는 방향 변경이 거의 없기 때문에 픽앤 플레이스가 포함되지 않는다는 점을 제외하고 요리 시나리오에서 가장 자주 실행되는 동작이 포함됐다.

두 번째 부분에는 요리에서 붓기 동작만 포함했으며, 다양한 환경에 대한 모션 일반화를 돕기 위해 수집됐다. 1) 쏟아짐이 조리 후 두 번째로 자주 실행되는 동작인 것으로 밝혀졌고 픽 앤 플레이스 직후에 2) 다른 재료, 컵 및 용기를 전환하여 쏟아지는 동작의 환경 설정을 쉽게 변경할 수 있기 때문에 쏟아짐을 선택했다. 쏟아지는 데이터는 6개의 컵에서 3개의 재료를 10개의 용기에 쏟아 붓는 1,596건의 데이터가 포함됐다. 첨부된 논문에서는 작업 중심의 인터랙티브 조작에 대한 연구를 용이하게 하기 위해 제시했다. (데이터 세트 다운받기, 관련 연구논문 다운받기)

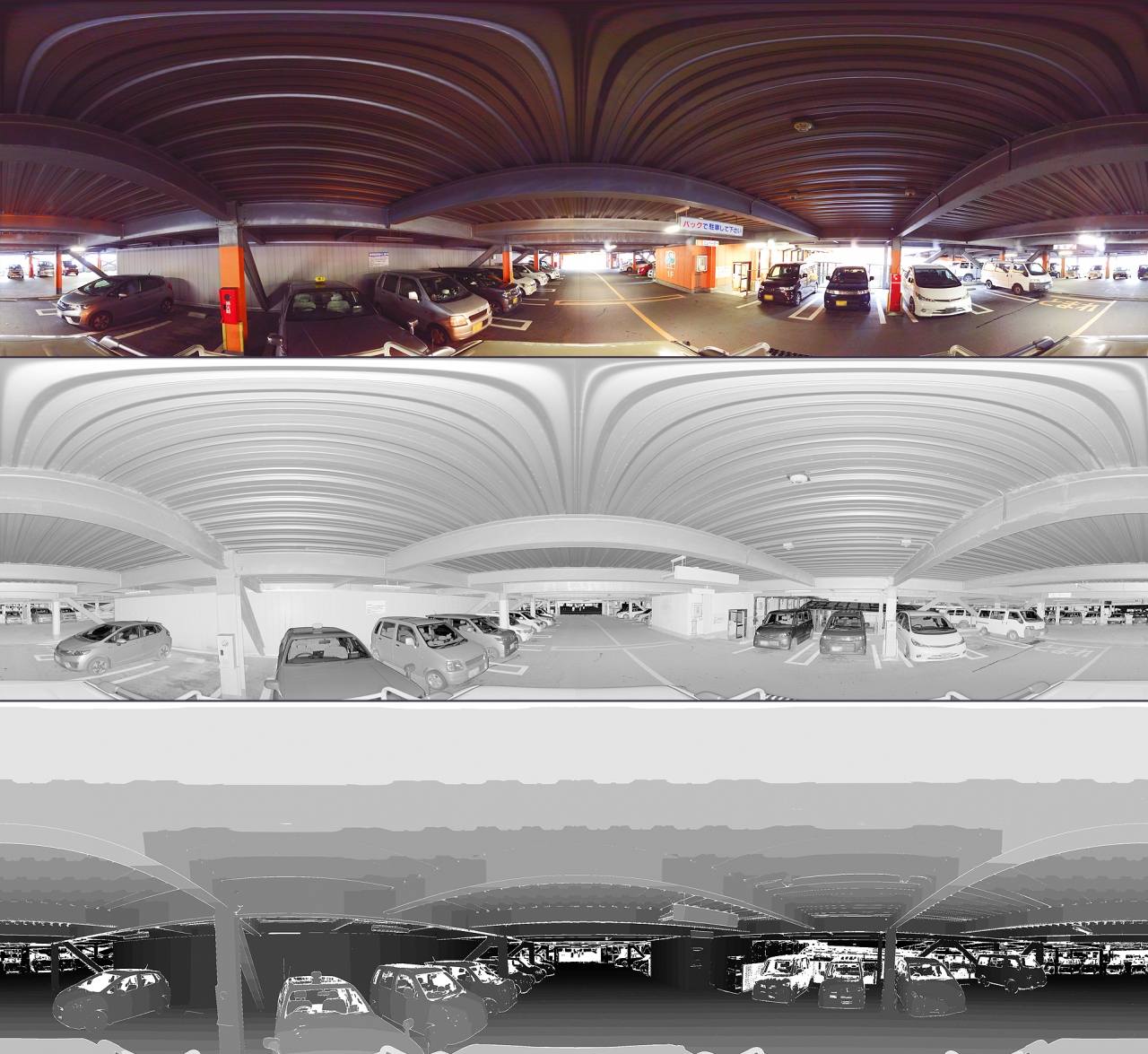

4> 장소 분류를 위한 후쿠오카 데이터 세트(Fukuoka datasets for place categorization)

지능형 모바일 로봇의 중요한 기능 중 하나는 주변 환경을 이해하고 위치 또는 환경의 유형을 식별하는 것으로 로봇 에이전트는 센서가 수집한 정보를 사용하여 장소 또는 주거 지역, 산림 등 환경 유형을 결정해야 한다. 이 데이터 세트는 장소의 분류를 위한 여러 가지 멀티 모달 3D 데이터 세트를 포함한다. 또한 3D 깊이 정보 외에도 RGB 또는 반사 이미지와 같은 다른 형식도 포함되며, 일본 후쿠오카시에서 얻은 실내 및 실외 시나리오가 포함됐다.

실내외 환경에서 수집한 결과로 야외 장소 범주에는 숲, 도시 지역, 실내 주차장, 야외 주차장, 해안 지역 및 주거 지역의 데이터와 실내 장소 범주에는 복도, 사무실, 스터디 룸, 부엌, 실험실 및 화장실이 포함됐으며, 깊이 센서 세트에는 모바일 플랫폼의 시크(SICK) 레이저 거리 측정기와 RGB-D 카메라, 차량의 벨로다인(Velodyne) 및 파로(FARO) 라이다(LIDARS) 데이터 세트가 포함돼 인간과의 의사소통, 검색 및 탐색과 같은 다른 고급 로봇 작업을 크게 향상시킬 수 있다. (데이터 세트 다운받기, 관련 연구논문 다운받기)

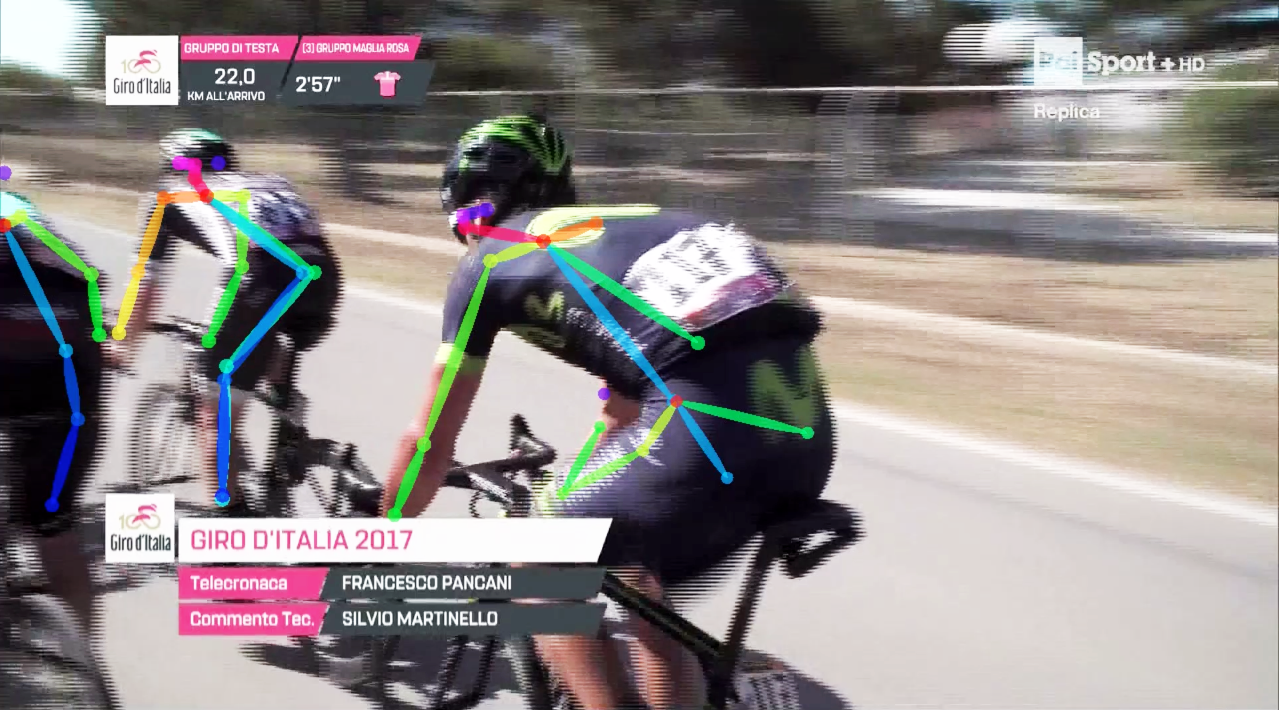

5> 멀티드론 공개 데이터 세트(MultiDrone Public DataSet)

공중 로봇은 감시, 모니터링, 촬영 등 많은 로봇 작업에 사용될 수 있다. 이 데이터 세트는 기존의 시청각 자료와 촬영된 UAV 샷을 모두 사용하여 제작했다. 여기에는 축구, 조정 및 사이클링(DW)을 묘사한 10 시간 이상의 UAV 영상이 포함됐다. 그리고 안면 식별, 사람 감지, 잠재적 착륙 지점 감지(AUTH)를 위한 추가 UAV 데이터 세트와 자전거, 축구 선수, 사람 군중 등의 시각적 감지 및 추적과 같은 작업에서 과학 연구를 용이하게 하기 위해 세트의 많은 부분이 주석 처리되었다.

자세한 목록은 축구, 조정 및 사이클링을 묘사한 10 시간 이상의 UAV 영상, 자전거 경주를 묘사한 115GB 이상의 전문 항공 UAV 샷(RAI, DW, AUTH), 다양한 환경(AUTH)에서 2.5GB 이상의 일반, 전문 및 준 전문 UAV 샷, UAV 비행(AUTH)을 묘사한 6GB 이상의 지면 샷 등과 최첨단 실시간 3D 그래픽 엔진을 사용하는 25분 이상의 시뮬레이션 비디오, 2 시간 이상의 영상(IST)에 해당하는 모든 감지된 사람의 골격 관절 데이터 등이 포함됐다.(데이터 세트 다운받기)

6> 휴먼 로봇 협업 조작을 위한 자연어 교육 데이터 세트(Natural language instructions for human–robot collaborative manipulation)

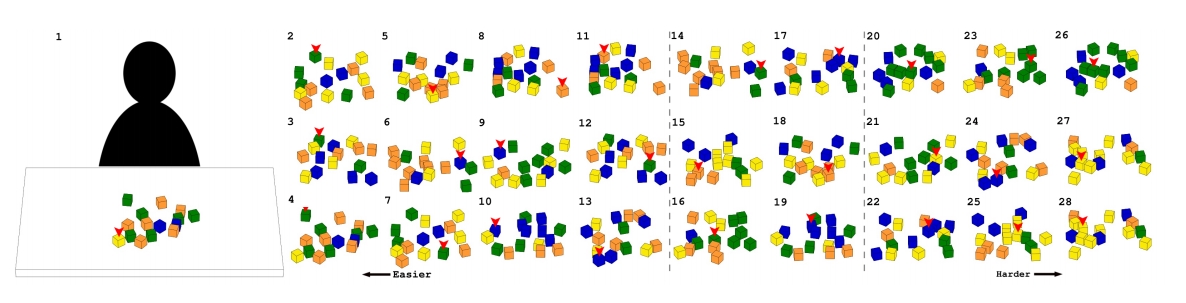

인간과 로봇의 원활한 협업을 위해서는 자연어를 이해하고 생성하는 것이 필수적이다. 이 데이터 세트는 Python을 통해 쉽게 액세스 할 수 있도록 예제 코드가 제공되며 자연어 처리, 인간 로봇 상호 작용 및 로봇 조작에 종사하는 연구원에게 특히 유용하다. 도메인 특정 언어를 풍부하게 제공할 뿐만 아니라 시스템 평가에 사용할 이미지와 명령 쌍의 벤치 마크를 제공하고 객체 사양의 고유한 문제를 찾아준다.

또한 조작 시나리오에서 객체 지정을위한 자연어 명령의 데이터 세트와 온라인 크라우드 소싱을 통해 수집 된 1582개의 개별 서면 설명서로 구성되어 있다. 이러한 각 지침은 포함된 28개의 시나리오 이미지 중 하나에서 도출되었다.

데이터 및 액세스 코드 구성은 먼저, 기본 데이터 세트(자연어 명령 코퍼스)는 CSV의 데이터, CSV로 다운 샘플링 된 데이터(1582에서 1400으로 데이터를 다운 샘플링하고 평가 연구에서 1400 지침을 사용), 파이썬에서 코드에 액세스 등과 보충 데이터 세트(명령 평가)로 JSON의 전체 데이터, CSV로 전체 데이터, JSON의 평균 데이터, CSV의 평균 데이터, JSON 데이터에 액세스하는 Python 코드, CSV 데이터에 액세스하는 Python 코드 등으로 구성돼 있다. (데이터 세트 다운받기, 관련 연구논문 다운받기)

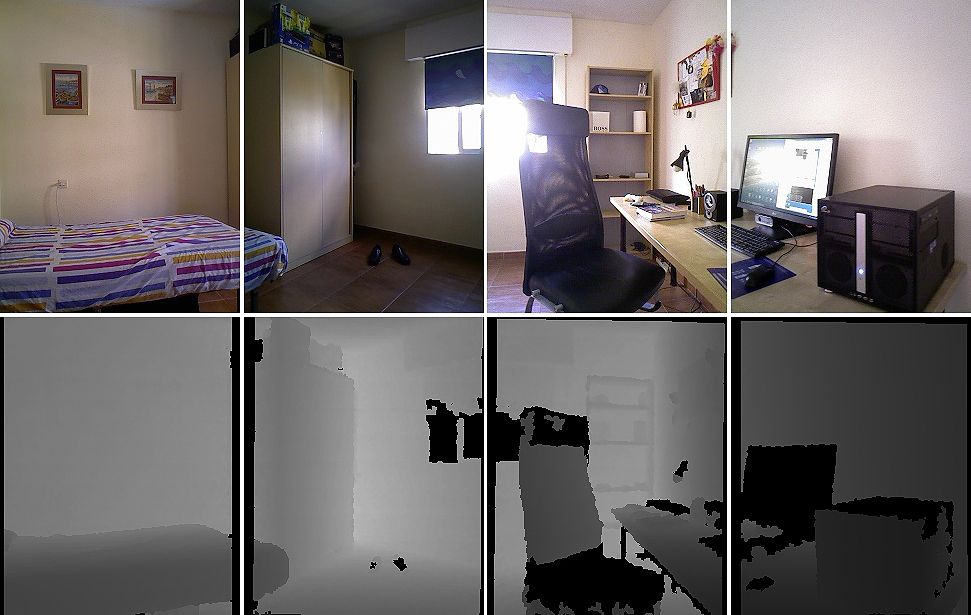

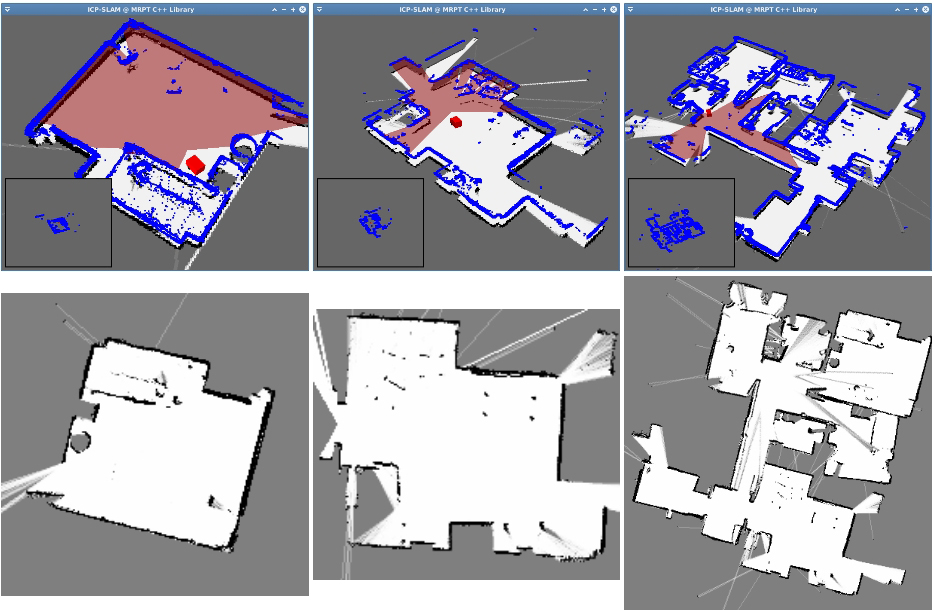

7> 가정환경의 시맨틱 맵핑을 위한 로봇 데이터 세트(Robot@Home, a robotic dataset for semantic mapping of home environments)

Robot-at-Home 데이터 세트(Robot@Home)는 객체 또는 매핑 알고리즘의 벤치마크 역할을 하는 것을 목표로 하는 미처리 및 처리된 감각 데이터의 모음이다. 이 데이터 세트에는 4개의 RGB-D 카메라와 2D 레이저 스캐너가 장착된 모바일 로봇이 수집한 87,000개 이상의 타임스탬프 관측치가 포함되어 있다.

원시 관측은 3D 재구성 및 조사된 집에서 방(Room)의 2D 기하학적 맵을 포함하여 데이터 세트와 함께 분포된 다양한 결과를 생성하기 위해 처리되었으며, 둘 다 측량된 방과 물체의 기본 범주로 주석이 달렸다. 제안된 데이터 세트는 특히 객체 또는 실내 분류 시스템을 위한 테스트 베드로 적합하지만 로봇 현지화, 3D 맵 구축, SLAM 및 객체 분할을 포함한 다양한 작업에도 활용할 수 있다.(데이터 세트 다운받기, 관련 연구논문 다운받기)

8> 로봇 조작 위한 예일-CMU-버클리 데이터 세트(Yale-CMU-Berkeley dataset for robotic manipulation research)

이 데이터 세트는 로봇 조작 연구에서의 벤치마킹을 위해 실제 객체에 대한 이미지 및 모델 데이터 세트를 제시한다. 각 개체에 대해 데이터 집합은 600개의 고해상도 RGB 이미지, 600개의 RGB-D 이미지 및 5 가지의 질감 3차원 기하 모델을 제공하며, 각 이미지에 대한 분할 마스크 및 교정 정보도 제공된다.

데이터는 BigBIRD Object Scanning Rig 및 구글 스캐너를 사용해 수집했으며, 데이터 세트와 함께 Python 스크립트 및 로봇 운영 체제 노드가 제공되어 데이터를 다운로드 하고 포인트 클라우드를 생성하며 통합 로봇 설명 파일을 생성한다.(데이터 세트 다운받기, 관련 연구논문 다운받기)