소니, 세계 최초로 AI 처리 기능을 탑재한 AI 비전 센서 출시로 엣지 AI 처리를 가능하게 하고 클라우드와 연동으로 최적의 AI 시스템 구현에 기여한다.

5G와 IoT의 보급으로 거의 모든 디바이스가 클라우드에 연결 장비에서 얻은 정보를 클라우드에서 AI 처리하여 다양한 정보 처리를 실현하는 시스템의 활용이 일반화되고 있다.

그러나 그 용량과 시스템이 한계로 실시간 데이터 전송 지연과 개인 식별 데이터를 클라우드에 저장함에 따르는 보안 문제와 클라우드 서비스 이용시의 소비 전력이나 통신비용의 증가 등의 과제가 발생하고 있다.

이에 소니(Sony Corporation)가 이미지 센서 세계 1위의 명성과 AI 엣지 시대 대응을 위한 세계 최초로 이미지 센서에 AI칩을 탑재하는 혁신을 가속하고 있다.

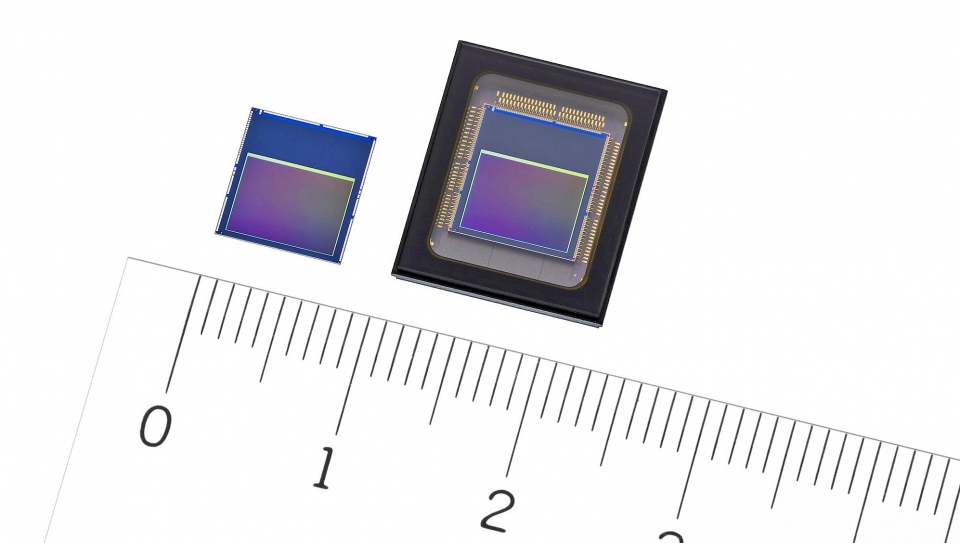

소니는 인공지능(AI) 처리 기능을 탑재한 인텔리전트 비전 센서 'IMX500((베어 칩)'과 'IMX501(패키지 제품)' 두가지를 발표하고 오는 6월부터 시판한다고 밝혔다. 가격은 각각 1만엔(약 11만5천원), 2만엔(약 23만원)으로 책정됐다.

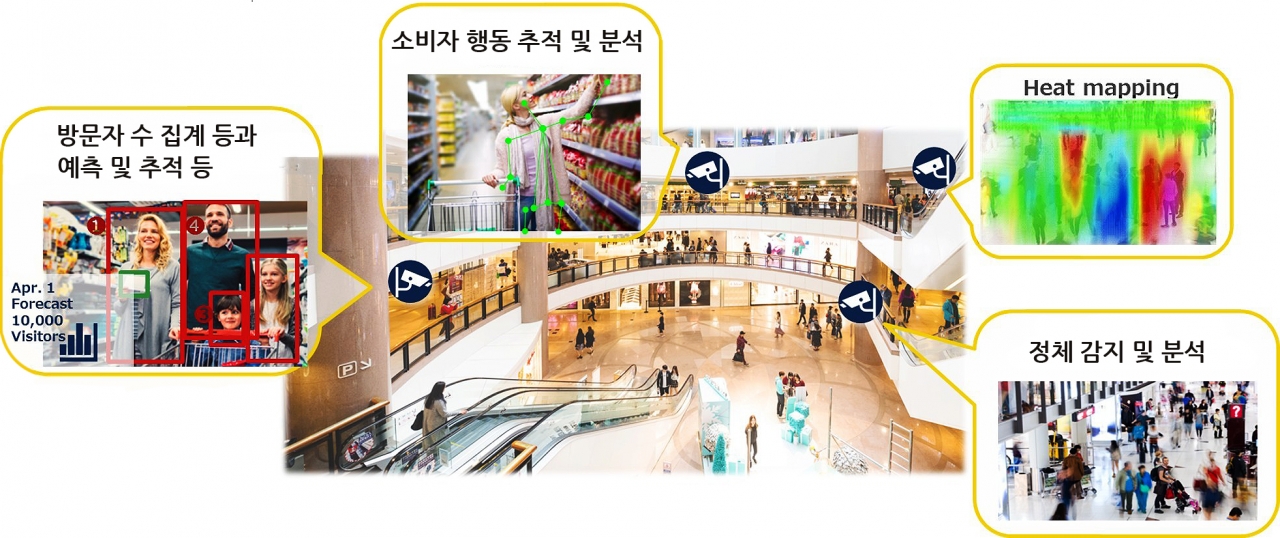

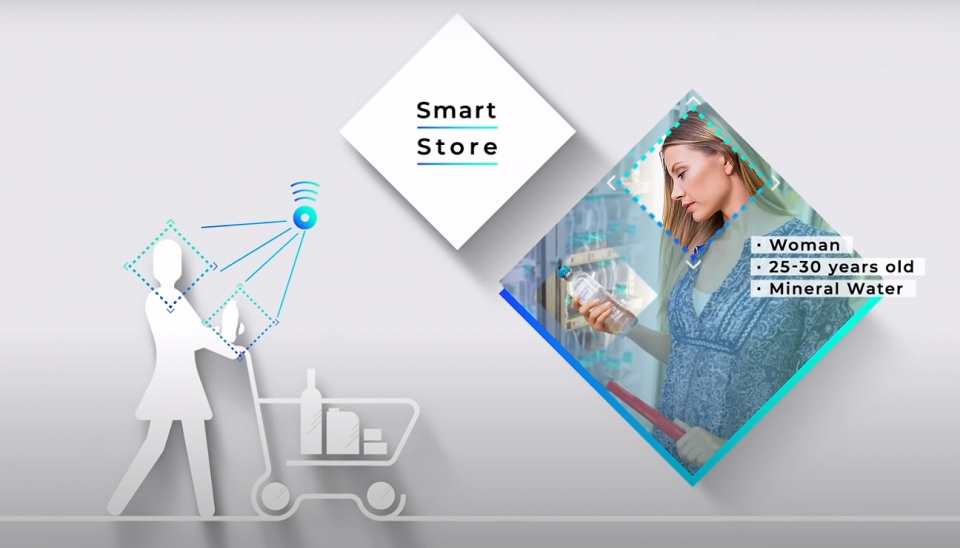

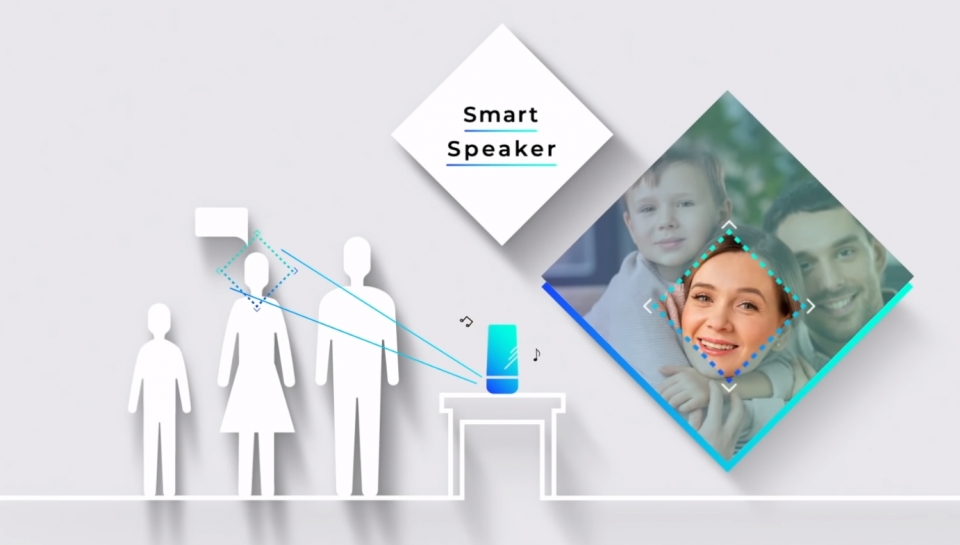

제품은 이미지 센서에 AI처리 기능을 탑재해 엣지에서 이미지를 처리하는 AI 카메라, 스마트 스토어, 자동차 모빌리티, 스마트 스피커 등 다양한 산업에서 엣지 AI 이미지 애플리케이션을 실현하고 또한 클라우드와 연계한 최적의 시스템 구축에 기여할 것으로 예상된다.

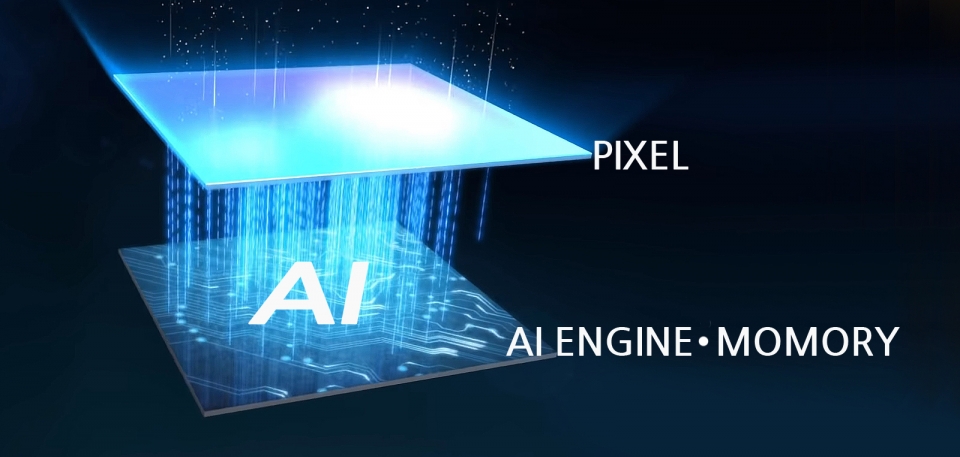

이 인텔리전트 비전 센서는 이미지 센서 ‘픽셀(화소) 칩’과 ‘로직 칩’이 내장된 적층 구조로 픽셀 칩이 획득한 신호를 로직 칩에서 AI 이미지 분석과 데이터를 처리한다. 이는 고성능 프로세서나 외부 메모리를 필요로 하지 않고 엣지에서 AI 시스템을 실현하는 것이 가능해진 것이다.

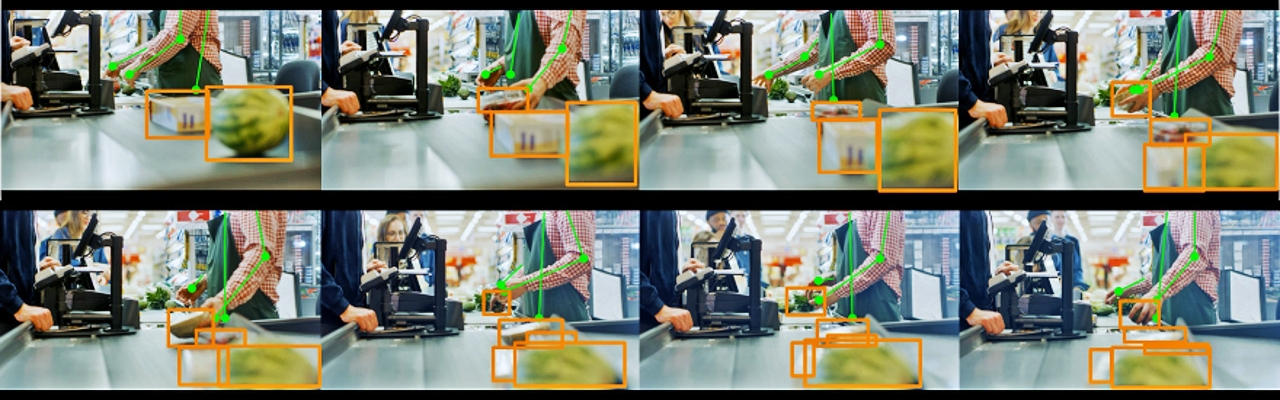

메타 데이터(영상 데이터에 속하는 의미 정보)의 출력에 의한 데이터의 양을 줄이고 사생활에 대한 배려뿐만 아니라 빠른 AI 처리에 의한 대상물의 실시간 추적과 사용 환경이나 조건에 맞는 AI 모델의 선택 등 다양한 기능을 통해 요구하는 응용 프로그램과 기능을 제공한다.

픽셀 칩에는 유효 약 1230 만개의 이면 조사 형 화소를 배치하고 더 넓은 시야각으로 정보를 파악할 수 있다. 또 로직 칩은 일반 이미지 센서의 신호처리 회로뿐만 아니라 AI에 특화된 신호 처리를 담당하는 소니 고유의 DSP(Digital Signal Processor)와 AI 모델에 사용할 수 있는 메모리를 탑재하고 있다. 이는 별도로 고성능 프로세서와 외부 메모리를 필요로 하지 않고 엣지 AI 시스템을 실현하는 것이다.

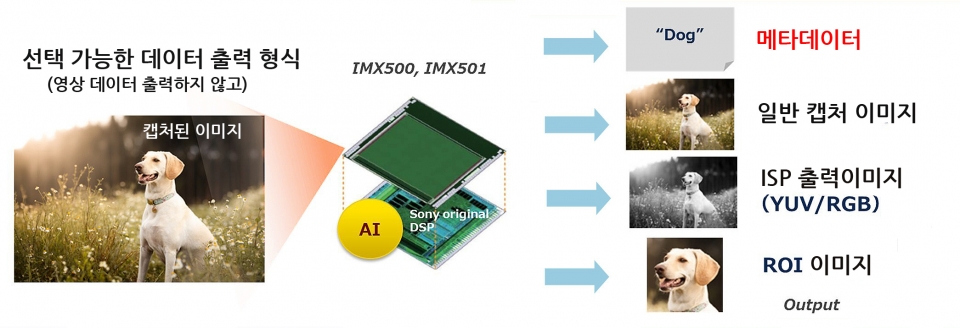

아울러 화소 칩에서 얻은 신호를 로직 칩에서 처리하는 과정에서 ISP (Image Signal Processor) 처리 및 AI 를 수행함으로써 대상물을 메타 데이터로 출력하고 적용하므로 데이터 량을 줄일 수 있다.

또한 이미지 정보를 출력하지 않아 보안 위험을 줄이고 사생활 보호에 대한 대응이 가능해진다. 일반 이미지 센서의 촬영 이미지뿐만 아니라 ISP 출력 형식의 이미지 (YUV·RGB)이나 특정 영역만 잘라낸 ROI (Region of Interest) 이미지 등 사용자의 필요와 용도에 따라 출력 데이터 형식을 선택할 수 있다.

그동안 일반 이미지 센서로 동영상을 촬영하는 경우, 출력된 하나의 프레임 이미지 마다 AI 처리에 데이터의 전송이 많아지면서 실시간성을 확보하는 것이 어려웠으나 모바일 기기용의 물체 식별을 목적으로 한 딥러닝 영상 분석용 AI 플랫폼 모바일네트(MobileNet)에서 3.1 밀리초(1000분의 1초) 처리 시간으로 동영상의 한 프레임 내에서 모든 처리가 가능해 동영상을 촬영하면서 대상물의 정확한 실시간 추적이 가능해진 것이다.

사용자는 모든 AI 모델을 메모리에 기록하고 사용 환경과 조건에 맞게 다시 업데이트 할 수 있다. 예를 들어, 여러 대의 카메라를 매장에 설치 한 경우 1 종류의 카메라 설치 위치, 상황, 시간 등 목적이나 용도에 따라 구분하여 사용할 수 있다. 출입구, 선반 경우 상품의 결품(재고) 감지, 사람이 많이 모이는 장소의 감지 등의 여러 용도로 활용할 수 있다.

소니는 IMX500((베어 칩)은 이미 주요 고객사에 샘플을 배포한 상태이며, IMX501(패키지 제품)은 다음달 부터 시판할 예정이다. 즉, 올해 연말부터는 이 지능형 비전 센서를 탑재한 디바이스들이 엣지에서 인공지능을 구현하는 새로운 AI 디바이스와 솔루션들이 출시 될 것으로 예상된다.

결론적으로 AI는 수년간 개선되어 왔지만 대부분 클라우드 기반으로 구현됐으나 최근 NPU(Neural Network Processing Unit) 칩의 발전과 더불어 이번 소니의 이미지 센서에 AI를 탑재시키면서 보다 저렴한 가격으로 엣지에서 하나의 칩으로 딥러닝 구현과 콘볼루션 신경망(Convolutional Neural Network, CNN) 등을 통한 엣지에서 AI 모델을 실행할 수 있기 때문에 AI가 더 빨라질 뿐만 아니라 물체인식, 감정인식, 동작인식, 자동 번역 등 다양하게 응용될 것이며, 개인화 등 다양한 분야의 엣지에서도 최적화된 인공지능 구현이 가능하게 될 것으로 전망된다.

참고로 아래는 이번 출시된 소니의 AI 비전 센서 소개 영상이다.