"머신러닝 모델은 데이터에 존재하는 편견을 영구화하고 증폭시키는 것으로 알려져 있다"며, "그러나 이러한 데이터 편향은 모델을 배치한 후에야 명백해지는 경우가 많다" 이 문제를 해결하고 대규모 데이터 세트를 사전 식별할 수 있도록 하기 위해 이 도구를 제시

프린스턴대학교(Princeton University)의 비주얼 AI 연구소(Princeton Visual AI Lab) 연구팀이 인공지능(AI) 시스템을 훈련시키는 데 사용되는 이미지 세트의 잠재적 편향을 식별하기 위해 새로운 도구를 개발하고 이를 오픈 소스로 지난 1일 공개했다.

레벨링(REVELING, REVEAL BiaSE)라 불리는 이 도구는 사람, 사물, 행동을 포함하는 잠재적 편향성을 가시화할 수 있으며, 바이어스(bias)를 사용자와 데이터 세트 작성자에게 알리고, 편향을 수정하기 위한 실행 가능한 단계를 제시할 수 있다. 이 도구는 프린스턴대학 연구원인 올가 루사코프스키(Olga Russakovsky)와 프린스턴 비주얼 AI 연구소(Princeton Visual AI Lab)의 아르빈드 나라야난(Arvind Narayanan) 컴퓨터 과학 교수 겸 수석 연구원, 대학원생 안젤리나 왕(Angelina Wang) 등 3명이 개발했다.

이 도구는 사용자로부터 더 많은 방향을 요구하는 방식으로 데이터 세트의 이미지를 필터링하고 균형을 유지하는 것을 포함하는 스탠포드대학교의 초기 연구를 기반으로 했다. 연구 결과는 지난 8월 23일부터 28일까지 온라인으로 개최된 세계 최고 수준의 컴퓨터 비전 학술 대회인 '유럽 컴퓨터 비전 학회 2020(16Th European Conference on Computer Vision, ECCV)'를 통해 발표됐다.

연구팀은 이 과정을 담은 연구 논문 'REVISE: 시각 데이터셋의 바이어스 측정 및 완화를 위한 도구(REVISE: A Tool for Measuring and Mitigating Bias in Visual Datasets- 다운)'에 도구와 이를 통해 해결하고자 하는 문제에 대해 설명했다. 그들은 "머신러닝 모델은 데이터에 존재하는 편견을 영구화하고 증폭시키는 것으로 알려져 있다"며, "그러나 이러한 데이터 편향은 모델을 배치한 후에야 명백해지는 경우가 많다" 이 문제를 해결하고 대규모 데이터 세트를 사전 식별할 수 있도록 하기 위해 이 툴을 제시했다고 밝혔다.

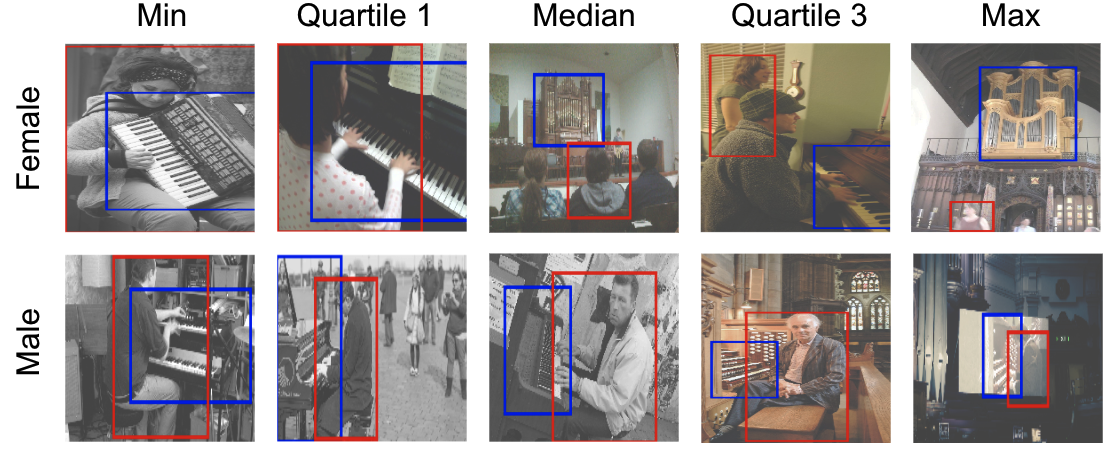

특히, REVISE는 시각 데이터 세트 내에 숨어 있는 미숙하고 다양한 표현을 가시화하는 광범위한 도구로 설계됐다. 객체 기반, 성별 기반, 지리 기반 등 3가지 특정 차원에 따른 시각적 데이터 집합의 편향성을 지원한다. 객체 기반 편향은 객체 표현의 크기, 맥락 또는 다양성과 관련이 있다. 성별에 기반한 측정기준은 다른 성별의 사람들에 대한 정형화된 묘사를 밝히는 것을 목표로 한다. 지리 기반 분석은 서로 다른 지리적 위치의 표현을 고려한다.

논문에서 인용된 예를 들자면 성별 편향에 대한 실행 가능한 통찰력을 제공하는 것은 덜 구체적이고 더 미묘한 과정이라고 연구원들은 발견했다. 이들은 "현대 사회에서는 다양한 직업, 활동 등에서의 성 표현이 불평등하다"면서 "모든 대상 범주에 걸친 성 평등을 지향하는 것이 올바른 접근법이라는 것은 분명하지 않다"며, "체계적이고 역사적인 성 편향은 다른 것들보다 문제가 많고, 이러한 분석은 자동화할 수 없다. 또한 불평등 표현에 의한 다운스트림 영향은 특정 모델과 과제에 따라 달라진다"고 강조했다.

한편, REVISE는 메트릭의 탐색 및 사용자 정의를 허용하는 주피터 노트북(Jupyter Notebook) 인터페이스를 사용했다. 연구팀은 "이것은 데이터 세트를 조명하기 위해 고안된 분석 도구지만, 사용자와 데이터 세트 디자이너가 그 분석에 따라 행동하는 것은 전적으로 중요하다. 문화적, 역사적 맥락을 고려하고, 드러난 편견 중 어느 것이 문제가 될 수 있는지를 결정하기 위해 사용자에게 달려 있다"며, "이 도구는 드러난 편견을 완화하기 위해 실행 가능한 단계(취할 수 있는 조치)를 제안함으로써 사용자를 더욱 돕는다"라고 밝혔다.

이 도구는 현재 깃허브(GitHub- 다운)를 통해 누구나 사용할 수 있다.