후지쯔연구소, 사이버 공격 탐지 AI에서 세계 최초로 효과 실증... 모의 위장 공격 데이터 자동 생성 기술과 여러 AI 모델의 결과를 결합하여 정밀도를 향상시키는 앙상블 적대적 학습(Ensemble Adversarial Training) 기술로 위장 공격을 모의 한 데이터를 대량으로 자동 생성, 원래 학습 데이터 세트와 결합시키는 것으로 판정 정밀도를 유지하면서 위장 공격에 대한 대응력을 향상시킬 수

최근 의료기관, 사회 인프라, 농업 등 다양한 분야에서 방대하고 다양한 데이터 해석으로 인공지능(AI)의 활용이 진행되고 있다.

반면에 도로 표지판에 작은 스티커를 붙여 AI가 다른 표식으로 잘못 인식하는 등 약간의 변화시킨 공격 데이터를 사용하여 AI 모델을 의도적으로 속여 AI의 올바른 판단을 방해하려고 하는 등의 요인들은 AI 활용에 불안 요소로 작용되고 있다. 또 그것을 방지하기 위해 학습 데이터에 미리 작성된 모의 위장 공격 데이터를 추가하여 만일 공격당할 경우에도 AI 모델이 속지 않도록 학습시키는 적대적 학습 기술을 제안하기도 한다.

그러나 지금까지의 적대적 학습 기술의 연구에서는 주로 화상이나 음성 등 미디어 데이터를 위한 지원이 대부분을 차지하고 있어 통신 로그 및 서비스 이용 이력 등 복수의 요소로 이루어진 계열을 단위로서 취급하는 순차적 데이터(Sequential Data)에의 대응은 불충분했다. 여기에는 사이버 공격 탐지 및 신용 카드 부정사용 탐지 등을 비롯하여 계열 데이터에 대한 AI의 응용 분야가 넓어 계열 데이터에 적용 가능한 위장 공격에 대한 내성 강화 기술의 개발이 요구되고 있는 상황이다.

이에 후지쯔 연구소는 여러 부분으로 구성된 순차적 데이터에 대한 AI 활용에서 위조 공격 데이터를 이용하여 AI 모델을 속이고 의도적으로 판정을 그르치는 공격에 대한 내성을 강화하는 AI 기술을 개발하고 지난달 26일부터 29일까지 온라인으로 열린 일본 '컴퓨터 보안 심포지엄 2020(CSS2020)에서 발표했다.

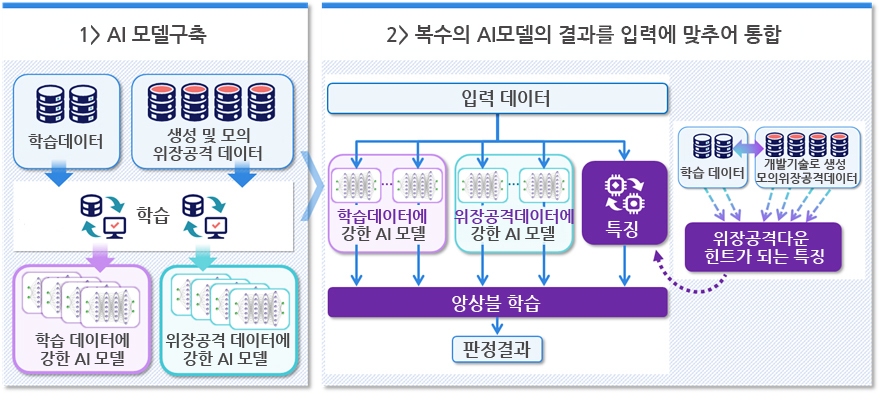

이 AI 기술은 모의 위장 공격 데이터 자동 생성 기술과 여러 AI 모델의 결과를 결합하여 정밀도를 향상시키는 앙상블 적대적 학습(Ensemble Adversarial Training) 기술로 위장 공격을 모의 한 데이터를 대량으로 자동 생성, 원래 학습 데이터 세트와 결합시키는 것으로 판정 정밀도를 유지하면서 위장 공격에 대한 대응력을 향상시킬 수 있다. 즉, AI가 여러 요소로 구성된 순차적 데이터에 사용될 때 모델을 속여서 고의적인 오판을 내리도록 위조 된 공격 데이터를 사용하려는 시도로부터 보호한다는 것이다.

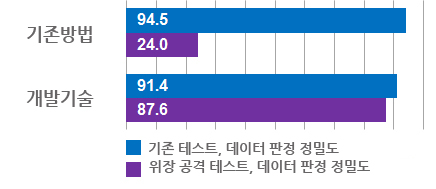

후지쯔 연구소는 기존 자체 개발한 사이버 공격에 대한 대처 필요 여부를 판단하는 AI 모델에 적용한 결과, 원래의 테스트 데이터에 대한 판정 정확성을 거의 저하시키지 않고 위장 공격 테스트 데이터에 대한 판정 정밀도를 약 88 %까지 향상시킬 수 있는 것을 확인했다고 밝혔다.

또한 이 AI 기술이 대상으로 하고 있는 순차적 데이터 분석 AI는 다양한 분야에서 이용되고 있으며, 기술을 활용하여 단순 미디어 데이터용으로 머물지 않고 광범위한 AI 활용 시스템의 안전성 향상에 기여할 것이라고 밝혔다.

관련기사

- 日 해상보안청, AI를 활용한 해상 교통 관제... 선박 충돌 위험 예측 기술 검증

- 시계열 데이터 이상을 식별하는 'AI 모델' 자동으로 생성해주는 인공지능 모델 공개

- [초점] 인공지능이 인식할 수 있는 화질로 영상 데이터를 고 압축하는 기술

- 새로운 AI 학습 방법 '활층 분할 학습(Stratification Learning)' 개발

- 언어 종류에 관계없이 대화 상황을 AI가 추정한다

- [이슈] AI 추론 정밀도 시간 지나면 저하된다? "이제는 아니다"

- [해외] “AI가 엔진부품연삭 전수 검사”…日서 실증실험

- [해외] 日 후지쯔, 금년 중 AI에 특화된 ‘딥러닝 유닛' 투입한다

- [이슈] 인공지능 처리를 최대 10배 고속화하는 컴퓨팅 기술...?

- [이슈] 세계 최초, AI가 수시로 변화하는 환경에 적응... '고내구성 학습' 개발

- [이슈] 밴스 테크놀로지, AI로 배경 이미지 단 5초만에 자동으로 제거하는 '밴스 AI 배경 제거기' 출시