옥스포드대, 딥마인드와 '인공지능 입술 판독 기술' 개발

옥스포드(Oxford)대학은 사람의 입술이 움직이는 모양을 보고 상대방이 무슨 말을 하는지 알아내는 독화술(讀話術)을 인공지능을 적용해 'WAS(Watch, Attend and Spell)'는 라는 '인공지능 입술 판독 기술'을 구글의 자회사 딥마인드(DeepMind)와 공동으로 개발했다고 지난 달 27일(현지시각) 밝혔다. 특히 이 기술 개발에는 한국인 대학원생 정준손(JoonSon Chung)씨도 참여해 화제다.

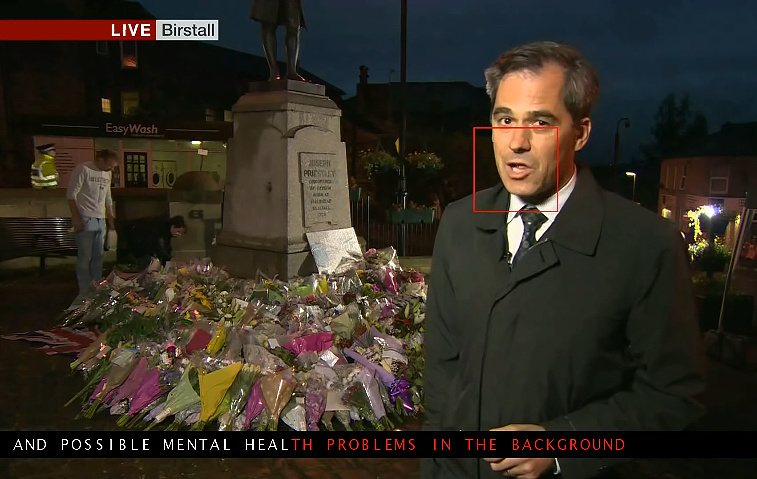

이번 개발된 'WAS(워치, 어텐드 앤드 스펠)'는 컴퓨터 비전과 머신러닝(Machine Learnig)을 통해 지난해 5월부터 BBC의 뉴스나이트(Newsnight) 등 6개 프로그램에서 수집한 5,000 시간 분량의 TV 영상으로 구성된 데이터 세트에서 입술을 읽는 방법을 학습했으며, 이 비디오에는 118,000 문장 이상의 어휘와 17,500 단어가 포함되어 있다.

또한, 연구팀은 개발된 WAS와 인간 독화 전문가의 능력을 비교 평가했다. 인간 입술 판독기는 단어의 12 퍼센트를 올바르게 읽었고 WAS는 오류없이 데이터 세트의 단어 중 50 퍼센트를 인식했으며, WAS의 실수는 단지, 단어 끝에 "s"가 누락되거나 단일 문자 철자가 틀린 것에 불과했다.

특히, 같은 입모양으로 발음하는 다른 음소를 해석할 때 연구팀은 인접한 단어나 전체 문맥을 보면 이런 모호성을 해소할 수 있다고 설명했다. 예를 들어 ‘p’와 ‘b’는 다른 문자임에도 발음하는 입모양이 같다. 화면 속 인물이 ‘pad’라는 단어를 말했다면, AI는 이를 ‘bad’로 혼동하기가 쉽다. 이 때 WAS는 해당 단어의 앞뒤 문맥을 살펴 추론하는 것이다.

연구팀은 이 연구의 수석 저자이자 옥스포드 공학부의 한국인 대학원생인 정준손(JoonSon Chung)씨와 앤드류 지서만(AndrewZisserman) 교수와 딥마인드의 앤드류 시니어(Andrew Senior) 박사와 오리올 빈얄스(Oriol Vinyals)박사로 구성되었으며, 이 기술을 통해 사람들보다 더 정확하게 입술을 읽고 청력을 상실한 사람과 난청 환자의 삶의 질을 향상시키며, 실시간 자막 등 인공지능 영상인식기술과 자동음성인식 기술을 진일보시켰다.

한편 영국 RNID(Royal National Institute for Rafed People) 청력손실(Action On Hearing Loss)연구 매니저인 제사르 비슈누람(Jesal Vishnuram)은 이 기술의 핵심 가치에 대해 "청각 장애인이나 난청 환자가 TV에 더 잘 접근 할 수 있도록 돕는 이 신기술 개발을 환영합니다. 진행중인 연구를 보니 청력을 잃은 사람들의 접근 가능성을 개선하여 청력 상실에 대한 새로운 대처가 가능하게 되었습니다. 인공 지능 입술 판독 기술은 특히 시끄러운 환경에서 음성 - 텍스트의 정확성과 속도를 향상시킬 수 있을 것이며, 우리는 이 분야에 대한 더 많은 연구를 장려하고 새로운 발전이 이루어지길 기대합니다."라고 말했다.