AutoML 솔루션에 대한 접근을 보다 광범위한 연구 커뮤니티로 확장하기 위해 개발 및 연구자들이 효율적이고 자동으로 최고의 머신러닝 모델을 개발할 수 있도록 지원하는 플랫폼

신경망(NN)의 성공은 종종 그것이 다양한 작업에 얼마나 잘 일반화될 수 있느냐에 달려 있다. 그러나 신경망이 어떻게 일반화되는지에 대한 연구 커뮤니티의 이해는 현재, 다소 제한적이기 때문에 여전히 신경망을 설계하는 것은 도전적이다.

최근 몇년동안 AutoML 알고리즘은 수동 실험을 필요로 하지 않고 자동으로 올바른 신경망을 찾을 수 있도록 돕기 위해 등장했다. 머신러닝 분야에서 널리 사용되는 모델 인 인공 신경망 (ANN) 의 설계를 자동화하는 신경 아키텍처 검색(Neural Architecture Search. 이하, NSA), 강화 학습(RL), 진화 알고리즘(Evolutionary algorithm), 조합 검색 등과 같은 알고리즘을 사용하여 신경 네트워크를 구축한다.

이러한 기술은 적절한 설정을 통해 수동으로 설계된 다른 기술보다 우수한 결과를 제공할 수 있음을 입증했다. 그러나 이러한 알고리즘은 컴퓨팅 성능이 뛰어나야 하며 통합하기 전에 수천 가지 모델을 교육해야 하는 경우가 많다.

더욱이, 그들은 도메인별 검색 공간을 탐색하고 도메인 간에 잘 전달되지 않는 상당한 인간 지식을 통합해야 한다. 예를 들어, 이미지 분류에서, 전통적인 NAS는 완전한 네트워크를 만들기 위해 전통적인 관례에 따라 배열하는 두 개의 좋은 빌딩 블록(컨볼루션 및 다운샘플링 블록)을 검색한다.

구글 AI는 이러한 단점을 극복하고 AutoML 솔루션에 대한 접근을 보다 광범위한 연구 커뮤니티로 확장하기 위해 개발 및 연구자들이 효율적이고 자동으로 최고의 머신러닝 모델을 개발할 수 있도록 지원하는 플랫폼인 '모델 검색(Model Search)'을 오픈 소스로 19일(현지시간) 공개했다.

이 플랫폼 모델 검색은 특정 도메인에 초점을 맞추는 대신 도메인에 구애받지 않고 유연하며 코딩 시간, 노력 및 계산 리소스를 최소화하면서 주어진 데이터 세트와 문제에 가장 적합한 아키텍처를 찾을 수 있으며, 텐서플로우(Tensorflow)를 기반으로 하며 단일 머신 또는 분산 설정에서 실행할 수 있다.

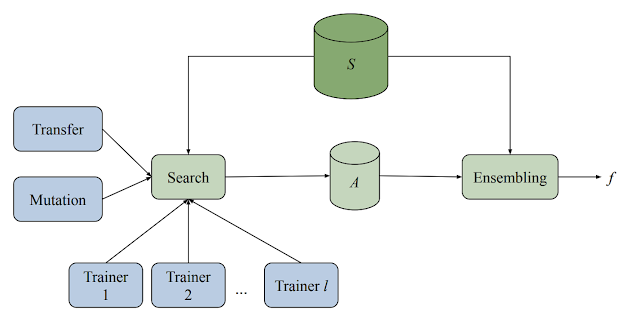

모델 검색 플랫폼은 여러 트레이너, 검색 알고리즘, 전이 학습(Transfer Learning) 알고리즘 및 다양한 평가 모델을 저장하는 데이터베이스로 구성된다. 또 이 시스템은 적응형이면서도 비동기적인 방식으로 다양한 머신러닝 모델 (다양한 아키텍처 및 학습 기술)에 대한 학습 및 평가 실험을 모두 실행한다.

또한 각 트레이너가 독립적으로 실험을 수행하는 동안 모든 트레이너는 실험에서 얻은 지식을 공유한다. 모든 주기가 시작될 때 검색 알고리즘은 완료된 모든 시도를 조회하고 빔 검색(Beam Search)을 사용하여 다음에 시도할 작업을 결정한다. 그런 다음 지금까지 발견된 최고의 아키텍처 중 하나에 대한 변이를 유발하고 그 결과 모델을 다시 트레이너에게 할당한다.

모델 검색 프레임 워크는 텐서플로우를 기반으로 하므로 블록은 텐서를 입력으로 사용하는 모든 함수를 구현할 수 있다. 예를 들어, 마이크로 아키텍처를 선택하여 구축된 새로운 검색 공간을 도입하려고 한다고 가정하면 프레임워크는 새로 정의된 블록을 가져와서 알고리즘이 제공된 구성 요소로부터 가능한 최상의 신경망을 구축할 수 있도록 검색 프로세스에 통합한다.

제공된 블록은 이미 관심있는 문제에 대해 작동하는 것으로 알려진 완전히 정의된 신경망 일 수도 있다. 이 경우 모델 검색은 단순히 강력한 앙상블 머신 역할을 하도록 구성할 수 있다.

아울러 모델 검색에 구현된 검색 알고리즘은 적응형, 탐욕 알고리즘(Greedy algorithm)이어서 강화 학습 알고리즘보다 더 빠르게 수렴된다. 그러나 그들은 좋은 후보(탐색 단계)에 대한 검색을 분리하여 강화 학습 알고리즘의 탐색 및 착취(explore & exploit) 특성을 모방하고, 발견된 좋은 후보(탐색 단계)를 결합하여 정확도를 높인다.

기본 검색 알고리즘은 아키텍처 또는 학습 기술에 임의의 변경 사항을 적용한 후 (아키텍처를 더 깊게 만드는) 상위 K 개의 수행중인 실험(여기서 K는 사용자가 지정할 수 있음) 중 하나를 적응형으로 수정한다.

또한 효율성과 정확성을 더욱 향상시키기 위해 다양한 내부 실험 간에 전이 학습을 사용할 수 있다. 모델 검색은 지식 증류(Knowledge Distillation) 또는 가중치 공유를 통해 두 가지 방법으로 수행된다. 지식 증류는 실측과 더불어 고성능 모델의 예측과 일치하는 손실 항을 추가하여 정확도를 향상시킬 수 있다.

반면에, 중량 공유(Weight Sharing) 이전에 훈련된 모델에서 적절한 가중치를 복사하고 나머지 모델들을 무작위로 초기화함으로써 이전에 훈련된 후보들로부터 네트워크에서 일부 매개 변수(변이를 적용한 후)를 캡처한다. 이것은 더 빠른 훈련을 가능하게 하여 더 많은(그리고 더 나은) 아키텍처를 발견할 수 있는 기회를 준다.

실험 결과, 모델 검색은 최소한의 반복으로 생산 모델을 개선한다. 최근 연구 논문(키워드 검색 및 언어 식별 향상, 규모의 신경 구조 탐색을 통해-다운)에서 구글 AI는 키워드 검색 및 언어 식별을 위한 모델을 발견함으로써 음성 도메인에서 모델 검색의 기능을 입증했다. 200회 미만의 반복으로 모델은 최대 130K 적은 학습 가능한 매개 변수(315K 매개 변수 대비 184K)를 사용하여 정확도에서 전문가가 설계한 내부 최첨단 생산 모델에서 약간 개선되었다.

또한 구글 AI는 많이 탐색된 CIFAR-10 이미지 데이터 세트(다운)에서 이미지 분류에 적합한 아키텍처를 찾기 위해 모델 검색을 적용했다. 컨볼루션, 레스넷 블록(즉, 두 개의 컨볼루션 및 스킵 연결), NAS-A 셀, 완전히 연결된 레이어 등을 포함한 알려진 일련의 컨볼루션 블록을 사용하여, 209번의 실험에서(즉, 209개의 모델만 탐색) 벤치마크 정확도에 빠르게 도달할 수 있다는 것을 실증했다.

이에 비해, 이전의 상위 성과자들은 NasNet 알고리즘(확장 이미지 인식을 위한 전송 가능 아키텍처 학습- 논문 다운)의 경우 5807 시험과 PNAS(RL + Progressive)의 경우 1160 시험에서도 동일한 임계값 정확도에 도달했다.

마지막으로 구글 AI는 이 모델 검색(다운) 오픈 소스 플랫폼이 개발자 및 연구원들에게 머신러닝 모델 발견을 위한 유연하고 도메인-불가지론적인 프레임워크를 제공하기를 바란다며, 주어진 영역에 대한 이전의 지식을 바탕으로 구축함으로써, 이 프레임워크가 표준 빌딩 블록으로 구성된 검색 공간을 제공할 때 잘 연구된 문제에 대해 최첨단 성능을 가진 모델을 구축할 수 있을 만큼 강력하다고 믿는다고 밝혔다.