계획하는 능력은 인간지능의 중요한 부분으로, 우리가 문제를 해결하고 미래에 대한 결정을 내릴 수 있게 해준다. 그동안 계획 기능을 갖춘 에이전트를 구성하는 것은 오랫동안 인공지능을 추구하는 데 있어 주요한 과제 중 하나였다. 딥마인드는 AI 범용 알고리즘의 추구에 있어 중요한 진보에 강화학습 끝판왕을 제시했다.

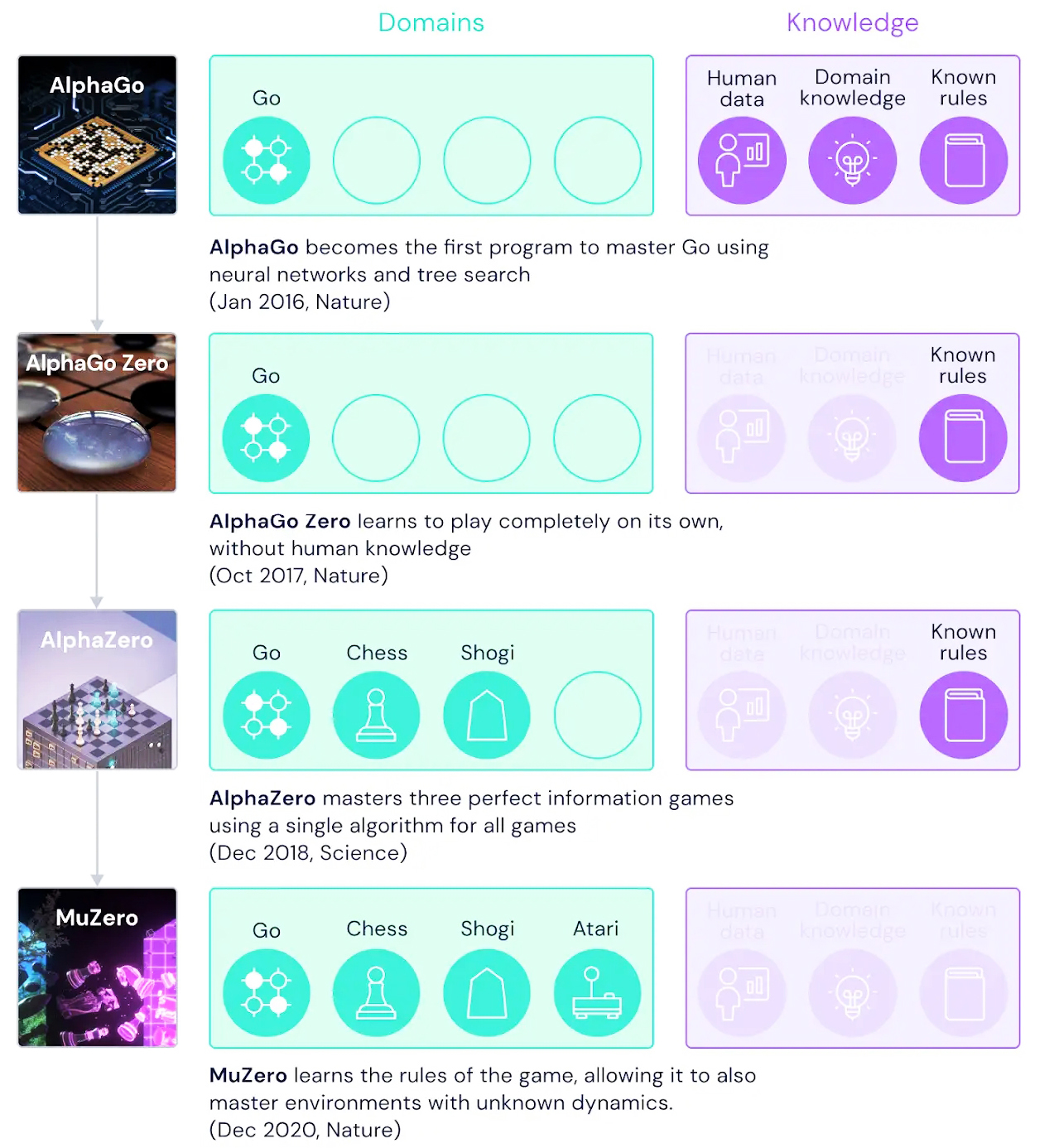

구글 딥마인드(DeepMind)는 2016년, 바둑에서 인간을 물리친 최초의 인공지능(AI) 프로그램인 알파고(AlphaGo)를 통해 세계 챔피언 8회 우승 기록을 보유하고 있던 이세돌 9단에게 4승 1패로 승리를 거두었고, 당시 세계랭킹 1위인 커제 9단에게도 3전 전승을 거두었다.

이후 2017년 10월, 딥마인드는 알파고의 이후 버전 '알파고 제로(AlphaGo Zero)'를 발표했다. 알파고 제로는 알파고와의 시뮬레이션에서 100대 0의 압승을 거두었다. 그리고 알파고 제로를 발표한지 한달 반 만에 딥마인드는 알파고 제로를 한층 더 개량한 '알파제로(AlphaZero)'를 발표했다. 알파제로는 바둑뿐만 아니라, 체스나 장기까지 학습할 수 있었으며, 당시 바둑, 체스, 장기 등 게임 AI 세계 챔피언이었던 알파고 제로, 스톡피쉬, 엘모 등에 모두 승리를 거두었다.

여기에서 주목해야 할 점은 알파고, 알파고 제로, 알파제로는 모두 처음부터 바둑, 체스, 그리고 쇼기(Shogi) 등을 마스터하기 위해서는 반듯이 학습 또는 게임 규칙을 사전 학습했다.

이제, 딥마인드는 혁신적으로 진화시킨 알려지지 않은 환경에서 승리 전략을 계획할 수 있는 능력 덕분에 학습은 물론 규칙도 알 필요 없이 바둑, 체스, 쇼기, 아타리(Atari)를 마스터하는 새로운 인공지능 '뮤제로(Muzero)'를 지난 23일(현지시간) 네이처를 통해 '학습된 모델로 계획을 세워 아타리, 고, 체스, 쇼기 마스터하기(Mastering Atari, Go, chess and shogi by planning with a learned model)'이란 제목으로 발표했다.

특히, 그동안 계획 기능을 갖춘 에이전트를 구성하는 것은 인공지능을 추구하는 데 있어 주요한 과제 중 하나였다. 딥마인드는 이 뮤제로 논문을 통해 AI 범용 알고리즘의 추구에 있어 새로운 진보에 대해 제시했다.

계획하는 능력은 인간지능의 중요한 부분으로, 우리가 문제를 해결하고 미래에 대한 결정을 내릴 수 있게 해준다. 예를 들어, 우리는 먹구름이 형성되는 것을 보면 비가 올 것이라고 예측하고, 우산을 준비하고 가기로 결정할 수 있은 것처럼 이는 딥마인드가 AI 알고리즘이 갖기를 희망하는 특징이기도 하다.

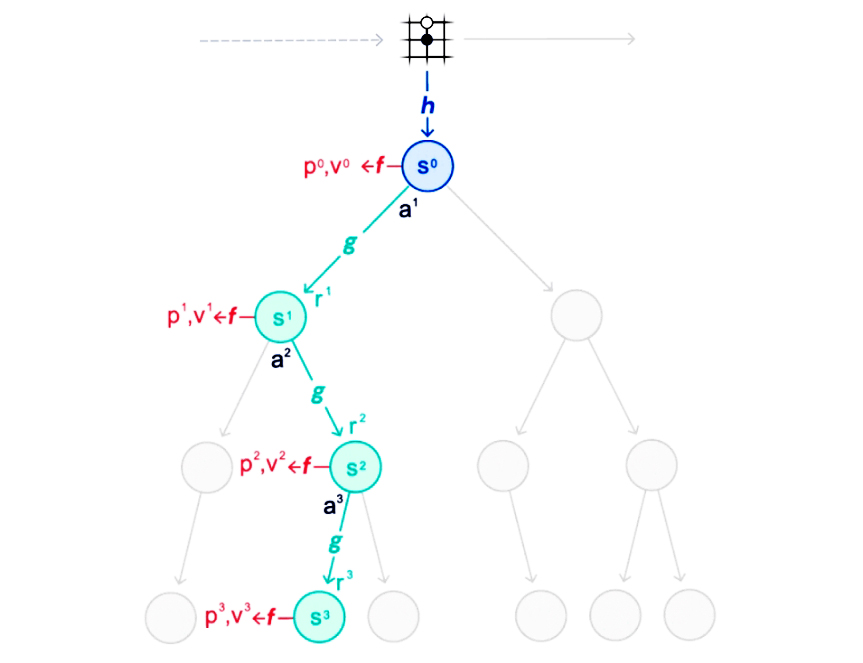

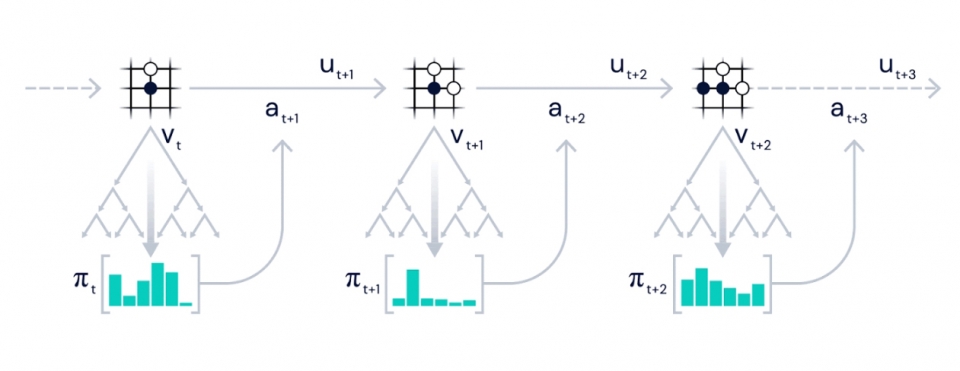

뮤제로 연구팀은 '미리보기 검색(lookahead search, 전망검색)'와 '모델 기반 계획(model-based planning)'의 두 가지 주요 접근 방식을 사용하여 AI의 이러한 주요 과제를 해결하려고 노력했다.

알파제로와 같은 전망검색을 사용하는 시스템은 체커(Checkers), 체스, 포커와 같은 고전적인 게임에서 괄목할 만한 성공을 거두었지만, 게임의 규칙이나 정확한 시뮬레이터와 같은 환경의 역학에 대한 지식이 주어지는 것에 의존한다.

모델 기반 시스템은 정확한 모델을 학습한 다음 이를 사용하여 계획을 수립함으로써 이 문제를 해결하는 것을 목표로 한다. 그러나 환경의 모든 측면을 모델링하는 복잡성은 이러한 알고리즘이 아타리와 같이 시각적으로 풍부한 도메인에서는 어려운 문제이다.

지금까지 아타리에 대한 최고의 결과는 DQN(논문명: 심층 강화 학습을 통한 인간 수준의 제어- 보기), R2D2(논문명: 분산 강화 학습에서 반복 경험 재생- 다운) 및 Agent57(논문명: Agent57, Atari 휴먼 벤치 마크를 능가- 다운)과 같은 모델이 없는 시스템에서 나온 것이다. 모델 없는 알고리즘은 학습된 모델을 사용하지 않고 대신 다음을 취할 수 있는 가장 좋은 방법이 무엇인지 추정한다.

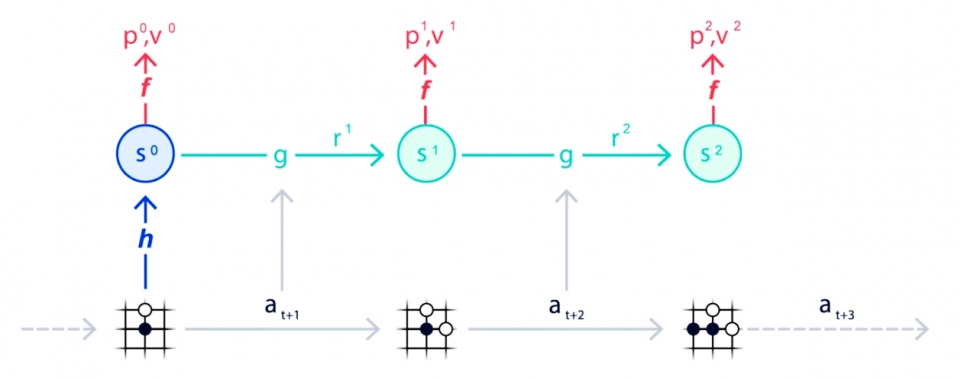

이 새로운 인공지능 '뮤제로(Muzero)'는 이전 접근법의 한계를 극복하기 위해 전혀 다른 접근방식으로 접근한다. 뮤제로는 전체 환경을 모델링하는 대신 에이전트의 의사 결정 프로세스에 중요한 측면만 모델링한다. 즉, 우산을 쓰면 우리가 비를 안 맞게 할 것이라는 것을 아는 것은 공기 중의 빗방울 패턴을 모형화하는 것보다 더 유용한 것이다.

구체적으로 뮤제로는 ▷가치(The value): 현재 위치는 얼마나 좋은가? ▷정책(The policy): 어떤 조치를 취하는 것이 가장 좋을까? ▷보상(The reward): 마지막 행동이 얼마나 좋았는가? 등 세 가지 환경 요소를 모델링한다. 이것들은 모두 심층 신경망을 사용하여 학습되며, 뮤제로가 어떤 행동을 취할 때 어떤 일이 일어나는지 이해하고 그에 따라 계획을 세운다는 것이다.

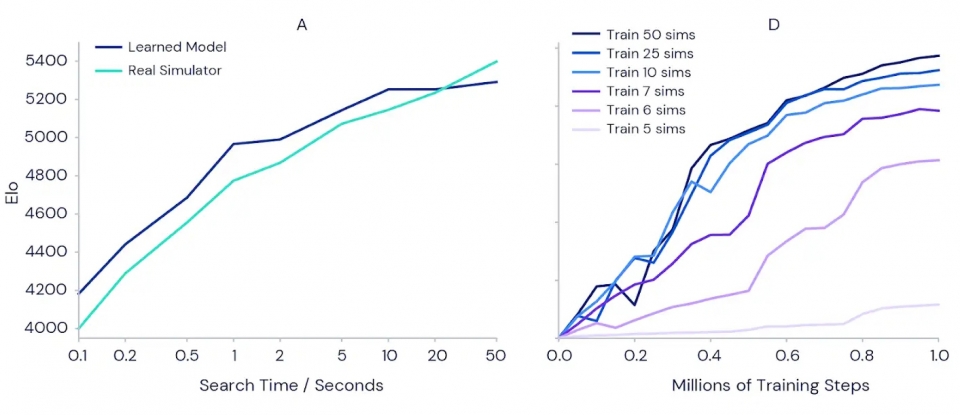

이러한 접근 방식에는 또 다른 주요 이점이 있다. 뮤제로는 환경에서 새로운 데이터를 수집하는 대신 학습된 모델을 반복적으로 사용하여 계획을 개선할 수 있다. 예를 들어, 아타리 제품군에 대한 테스트에서 뮤제로 재분석(MuZero Reanalyze)로 알려진 이 변형은 90%의 시간 동안 학습된 모델을 사용하여 과거 에피소드에서 수행해야 할 작업을 다시 계획했다.

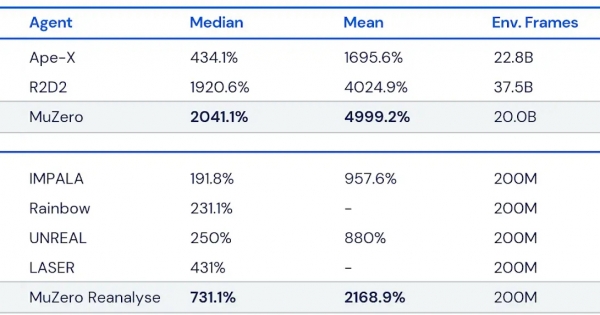

딥마인드는 뮤제로 성능을 테스트하기 위해 4개의 도메인을 선택했다. 고(Go), 체스, 쇼기(Shogi)는 어려운 계획 문제에 대한 성능을 평가하는 데 사용되었고, 시각적으로 더 복잡한 문제에 대한 벤치마크로 아타리 제품군을 사용했다. 모든 경우에, 뮤제로는 아타리 제품군의 모든 이전 알고리즘을 능가하고 고, 체스, 쇼기의 성능에 맞추어 강화학습 알고리즘을 위한 새로운 기술 상태를 설정했다.

연구팀은 계획이 학습 전반에 걸쳐 이점을 가져 오는지 여부를 테스트하기 위해 별도의 훈련된 뮤제로 인스턴스를 사용하여 아타리 게임 Ms Pac-Man (위의 오른쪽 그래프)에 대한 일련의 실험을 실행했다. 각각은 5개에서 50개까지 이동 당 다른 수의 계획 시뮬레이션을 고려할 수 있었다. 결과는 각 이동에 대한 계획량을 늘리면 뮤제로가 더 빠르게 학습하고 더 나은 최종 성능을 달성할 수 있음을 확인했다.

흥미롭게도, 뮤제로가 Ms Pac-Man에서 사용 가능한 모든 작업을 감당하기에는 너무 작은 숫자인 이동당 6, 7개의 시뮬레이션만 고려해도 좋은 성과를 거두었다. 이것은 뮤제로가 행동과 상황 사이를 일반화할 수 있고 효과적으로 학습을 위해 모든 가능성을 철저히 검색할 필요가 없다는 것을 암시한다.

이처럼 뮤제로는 환경 모델을 학습하고 성공적으로 계획하는 데 이를 사용하는 능력은 강화학습과 범용 알고리즘의 추구에 있어 혁신적인 발전을 보여준 것이다. 그것의 전신인 알파제로는 이미 화학, 양자 물리학, 그리고 그 이상의 다양한 복잡한 문제에 적용되고 있다. 이처럼 뮤제로의 강력한 학습 및 계획 알고리즘에는 '게임의 규칙(Rules of the Game)'이 알려지지 않은 로봇 공학, 산업 시스템 및 기타 복잡하고 어려운 실제 환경에서 새로운 도전을 다루는 길을 닦을 수 있을 것으로 기대된다.

이번 연구와 관련된 연구팀은 '학습된 모델로 계획을 세워 아타리, 고, 체스, 쇼기 마스터하기(Mastering Atari, Go, chess and shogi by planning with a learned model- 보기)'이란 제목으로 23일 네이처를 통해 발표와 금년 2월 21일 아카이브(다운)를 통해 발표했다. 또한 관련 연구는 지난 10월 프랑스 파리에서 26일부터 30일까지 온라인으로 개최된 ICAPS 2020(International Conference on Automated Planning and Scheduling)에서 발표(아래 영상 참조)하기도 했다.

이번 뮤제로 관련 소스는 오픈 소스로 공개됐다. 아케이드 학습 환경(Arcade Learning Environment- 다운), Go 및 chess 환경(다운), MuZero 알고리즘의 의사 코드는 논문 부가정보(Supplementary Information- 보기)의 pseudocode.py 파일에서 찾을 수 있다. 모든 신경 아키텍처 세부 정보와 하이퍼 파라미터는 방법에 설명되어 있다.

이와 연계된 알파고(2017.1.27. AlphaGo: 논문 '심층신경망 및 트리 검색으로 바둑 게임 마스터하기'- 보기), 알파고 제로(2017.10.19. AlphaGo Zero 논문 '인간의 지식없이 바둑 게임 마스터하기'- 보기), 알파제로(2018.12.7. AlphaZero 논문 '체스, 장기, 바둑을 마스터하고 셀프 플레이를하는 일반 강화학습 알고리즘'-다운) 을 참고하면 된다.

한편, 딥마인드의 선임 연구 과학자 데이비드 실버(David Silve) 박사는 24일(현지시간) 영국 BBC 방송 인터뷰를 통해 이 새로운 인공지능 뮤제로는 새로운 동영상 압축 기술의 개발과 YouTube의 비용을 절감할 수 있는 새로운 동영상 인코딩 방법을 찾는 데 이미 실용화되고 있다며, "인터넷에서 데이터 트래픽을 많이 차지하는 동영상을 효과적으로 압축할 수 있으면, 상당한 비용 절감이 가능하다"고 밝혔다. 이어 그는 이 AI 기술은 2021년 구글을 통해 구체적인 발표를 할 것이다"라고 예고했다.