한국생산기술연구원(원장 이낙규, 이하 생기원) 디지털전환연구부문 강경태 박사 와 건국대학교 메카트로닉스공학과 안건식 교수가 이끄는 공동연구팀이 차세대 디스플레이 제조방식인 ‘잉크젯 인쇄공정’의 상태 분류를 자동화 할 수 있는 인공지능(AI) 기술을 개발했다.

잉크젯 공정이란 종이에 잉크를 뿌려 인쇄하듯, 전자 재료를 기판 위에 분사해 인쇄하는 제조혁신 기술이다. 고가의 재료를 필요한 부분에만 선택적으로 인쇄 가능해 경제적이고 오염도 방지할 수 있어, 다양한 전자 소자부터 인공장기에 이르기까지 여러 분야에 걸쳐 널리 연구되고 있다.

현재, 산업계에서 가장 활발히 적용되고 있는 분야는 세계 최고의 기술력을 인정받고 있는 유기발광다이오드(OLED) 및 퀀텀닷(QD-OLED) 디스플레이 제조업계다.

증착을 이용한 기존의 디스플레이 제조공정은 화소 형성 과정에서 값비싼 재료가 많이 소모되고 대면적화가 어렵다는 한계가 있었다. 반면 잉크젯 장비를 도입하면 비용절감과 공정 효율화에 유리하여, 공격적인 투자에 나선 중국과의 기술격차를 벌리기 위한 선제적 대안으로 디스플레이 업계의 주목을 받고 있다.

그러나 잉크젯 공정은 잉크젯 방울이 어떤 상태인지 판단하고 분류하는 과정이 어려워 현재 장비 운전자의 숙련도와 감에 크게 의존하고 있다. 학계·산업계에서는 다양한 잉크젯 모니터링 기술들을 연구하고 있으나, 잉크젯 방울이 토출되는 과정에서 노즐-잉크-대기(고체-액체-기체) 계면간의 물리적 특성이 복잡해 정밀한 전산해석에 어려움을 겪고 있는 것이다.

또한, 실제 산업에 잉크젯 공정을 적용하기 위해서는 다수의 노즐을 동시에 모니터링하고 제어해 생산성을 높이는 작업도 필수적인 상황이다.

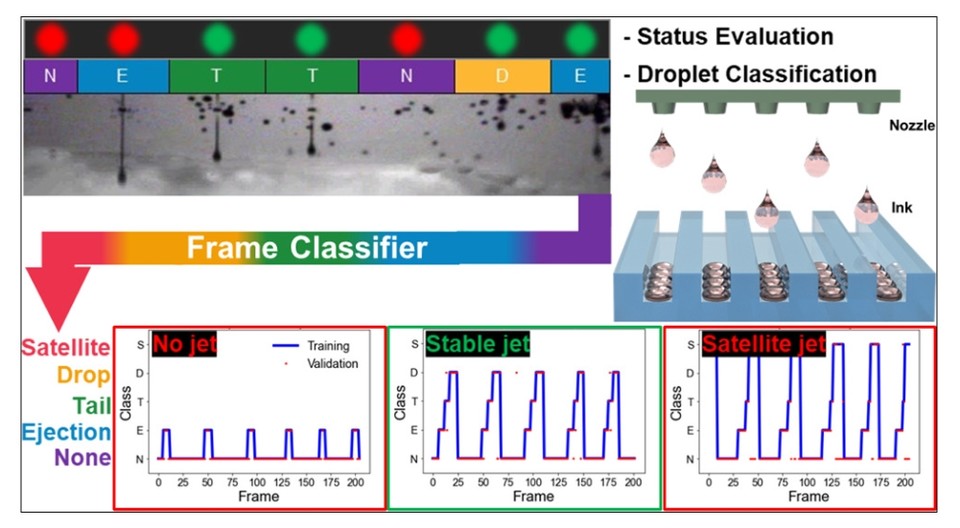

이에, 공동연구팀은 기존 인적자원 의존도를 줄이고자, 컨볼루션 신경망(Convolutional Neural Network, CNN)기반의 잉크젯 인공지능을 독자 개발함으로써 약 90%에 달하는 상태 분류 정확도를 달성하는 데 성공했다.

연구팀이 개발한 인공지능 플랫폼은 구글의 저메모리 연산에 효율화된 인공지능 모델 '모바일넷V2(MobileNetV2-다운)'을 기반으로 잉크젯 영상 프레임을 체계적으로 분류하고, 분류된 프레임을 시간 순으로 축적해 잉크젯 공정상태의 정확한 판별을 도와준다.

이를 통해 기존 기술 대비 다량의 정보를 가시화하고 시간의 흐름에 따른 잉크젯 방울의 상태 정보를 확인할 수 있으며, 궁극적으로 공정 모니터링의 자동화를 지원해준다.

공정 모니터링 자동화는 다수 노즐 인쇄 시 그 효과가 극대화되며, 특히 비숙련자의 장비 운용과 공정평가, 나아가 최적화까지 가능하게 해준다는 점에서 향후 산업적 파급효과가 매우 클 것으로 예상된다.

강경태 박사는 “이번 연구결과는 AI 적용으로 잉크젯 공정 실용화의 큰 장벽을 넘은 성취”라며, “향후 지속적인 연구를 통해 기술 상용화와 산업계 확산에 힘쓸 계획”이라고 밝혔다.

한편, 생기원 최은식 연구원이 제1저자로, 강경태 박사와 건국대 안건식 교수가 공동 교신저자로 참여한 이번 연구는 미국화학학회의 응용재료 및 계면(ACS Applied Materials & Interfaces)에 '멀티젯 모니터링 위한 딥러닝 기반 미세유체액적 분류(Deep-Learning-Based Microfluidic Droplet Classification for Multijet Monitoring-보기)'란 제목으로 지난달 22일 게재됐다.