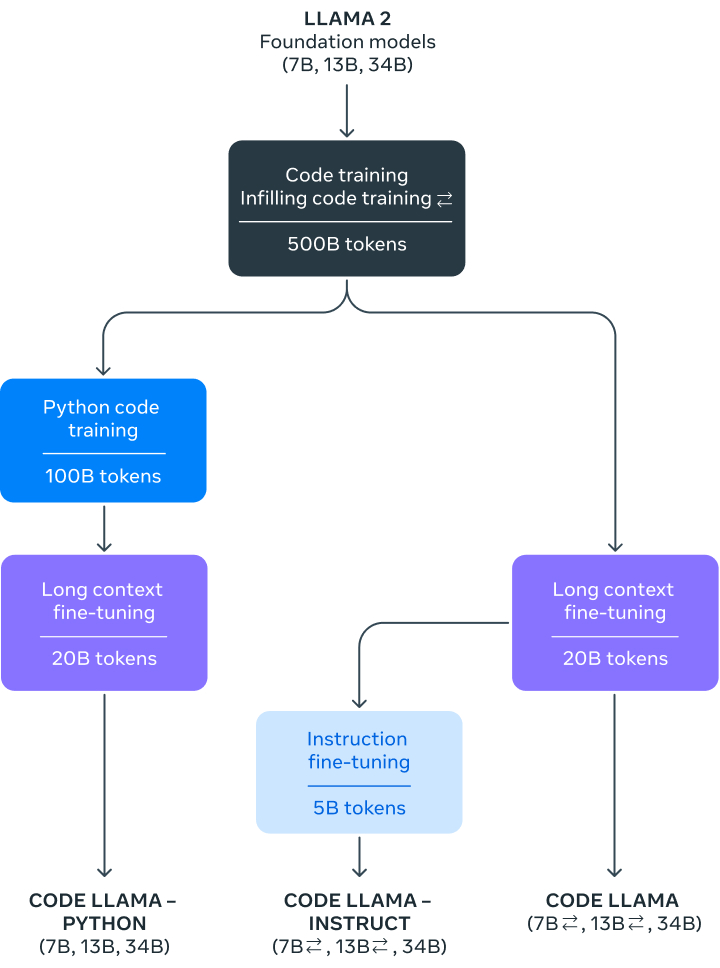

코드 라마는 '라마 2'기반으로 70억, 130억, 340억개의 매개변수를 가진 세 가지 모델로 공개됐다. 각 모델은 5000억 개의 코드 토큰과 코드 관련 데이터로 학습되었으며, 7B 및 13B 기본 지시 모델은 기존 코드에 코드를 삽입할 수 있는 FIM(Fill-in-the-middle) 기능으로 훈련되어 기존 코드에 코드를 삽입할 수 있다. 즉, 즉시 코드 완성과 같은 작업을 지원...

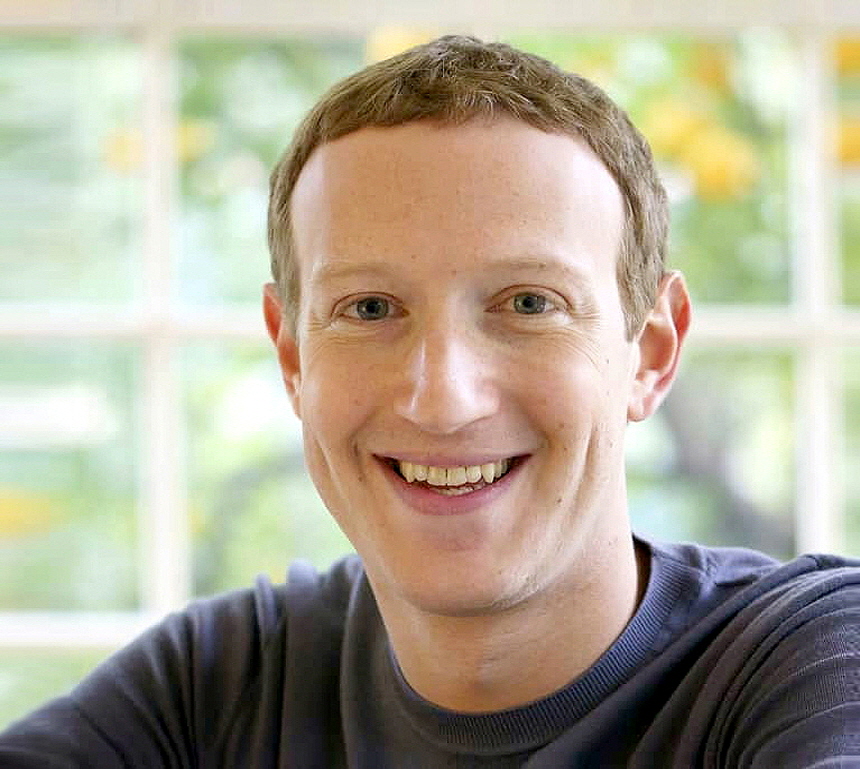

메타의 생성 인공지능(Gen AI), 대규모 언어 모델(LLM) 혁신이 놀랍다.

지난달 18일 차세대 인공지능(AI) 대규모 언어 모델(LLM) '라마 2(LLaMa2)'를 오픈 소스로 공개한지 40일 만에 최신 LLM보다 우수한 성능을 보인 새로운 코드 생성 AI 모델 '코드 라마(Code Llama)'를 24일(현지시간) 오픈소스로 공개했다.

'코드 라마'는 컴퓨터 언어와 인간 언어(자연어, 현재는 영어)를 동시에 이해하고 구사하는 가장 새로운 혁신적인 인공지능으로 자연어 프롬프트에서 코드를, 코드에 대한 자연어를 생성할 수 있는 최첨단 LLM으로 연구 및 상업적 용도로 무료로 사용할 수 있다.

메타는 이를 통해 기존 연구 및 개발자들의 워크플로우를 더욱 빠르고 효율적으로 높이고 코딩을 모르는 사람들의 진입 장벽을 혁신적으로 낮출 수 있다고 밝혔다.

코드 라마는 '라마 2'기반으로 70억, 130억, 340억개의 매개변수를 가진 세 가지 모델로 공개됐다. 각 모델은 5000억 개의 코드 토큰과 코드 관련 데이터로 학습되었으며, 7B 및 13B 기본 지시 모델은 기존 코드에 코드를 삽입할 수 있는 FIM(Fill-in-the-middle) 기능으로 훈련되어 기존 코드에 코드를 삽입할 수 있다. 즉, 즉시 코드 완성과 같은 작업을 지원할 수 있다.

세 가지 모델은 서로 다른 서비스 및 지연 시간 요구 사항을 해결했다. 예를 들어, 7B 모델은 단일 GPU에서 제공될 수 있으며 34B 모델은 최상의 결과를 반환하고 더 나은 코딩 지원을 허용하지만, 더 작은 7B 및 13B 모델은 실시간 코드 완성과 같이 낮은 대기 시간이 필요한 작업에 더 빠르고 적합하다.

또한 코드 라마 모든 모델은 16,000개의 토큰 시퀀스로 학습되었고 최대 100,000개의 토큰이 포함된 입력에서도 개선된 성능을 발휘한다.

더 긴 프로그램을 생성하기 위한 전제 조건일 뿐만 아니라, 입력 시퀀스가 길어지면 코드 LLM의 새로운 사용 사례를 열 수 있다. 예를 들어, 사용자는 코드베이스에서 더 많은 컨텍스트를 모델에 제공하여 생성의 연관성을 높일 수 있다. 또, 연구 및 개발자가 구체적인 문제와 관련된 모든 코드를 파악하는 것이 어려울 수 있는 대규모 코드베이스의 시나리오를 디버깅하는 데에도 도움이 된다. 이는 사용자가 대량의 코드를 디버깅해야 하는 경우 전체 코드 길이를 모델에 전달할 수 있는 것이다.

아울러, 코드 라마의 두 가지 추가 변형인 코드 라마 - 파이썬 및 코드 라마 - 인스트럭트를 추가로 미세 조정됐으며 Code Llama - Python은 코드 라마의 언어 특화 변형으로, 1,000억 개의 파이썬 코드에 대해 더욱 세밀하게 파인튜닝 되었다.

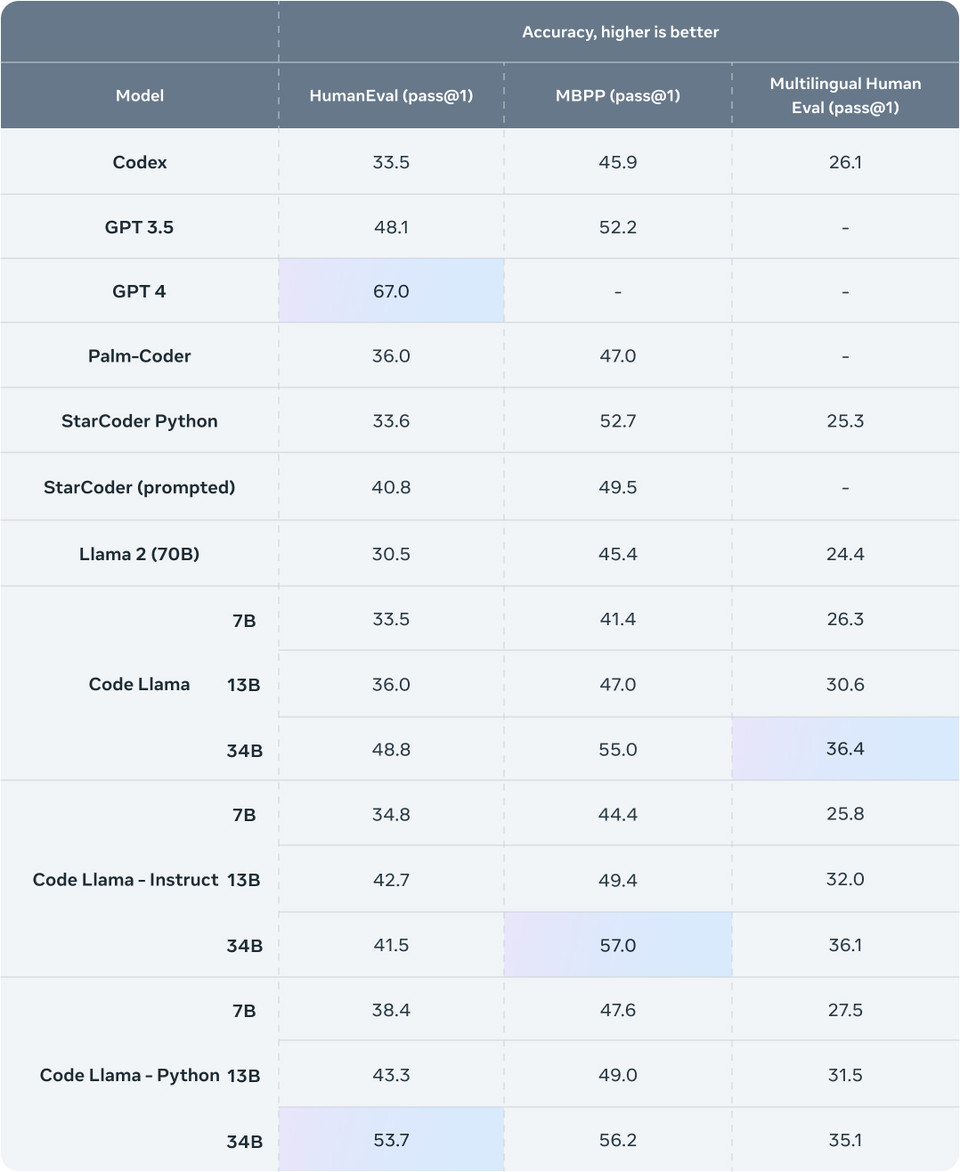

성능 평가에서는 기존 솔루션과 비교하여 Code Llama의 성능을 테스트하기 위해 두 가지 파이썬 코딩 벤치마크인 HumanEval과 MBPP(Mostly Basic Python Programming)을 사용했다. HumanEval은 문서 문자열을 기반으로 코드를 완성하는 모델의 능력을 테스트하고, MBPP는 설명을 기반으로 코드를 작성하는 모델의 능력을 테스트했다.

벤치마크 테스트 결과 코드 라마는 오픈 소스 코드 전용 LLM보다 성능이 우수했으며, 라마 2보다 성능이 뛰어났다. 예를 들어, Code Llama 34B는 HumanEval(다운)에서 53.7%, MBPP(다운)에서 56.2%를 기록했는데, 이는 다른 최신 오픈 솔루션과 비교했을 때 가장 높은 점수이며, ChatGPT와 동등한 수준이다.

하지만 모든 첨단 기술이 그러하듯, 코드 라마에도 위험이 따른다. 책임감 있게 AI 모델을 구축하는 것은 매우 중요하다. 메타는 코드 라마의 악성 코드 생성 위험에 대한 정량적 평가를 실시했다.

명확한 의도를 가지고 악성 코드를 유도하는 프롬프트를 생성하고 이러한 프롬프트에 대한 Code Llama의 응답을 챗GPT(GPT3.5 Turbo)와 비교하여 점수를 매겼다. 그 결과 Code Llama가 더 안전한 응답을 제공하는 것으로 나타났다.

책임감 있는 AI, 공격적 보안 엔지니어링, 멀웨어 개발, 소프트웨어 엔지니어링 분야의 도메인 전문가로 구성된 메타의 노력에 대한 자세한 내용은 연구 논문(Code Llama: 코드를 위한 개방형 기반 모델-다운)에서 확인할 수 있다.

메타는 코딩을 위한 생성 AI의 미래라는 비전아래 "Code Llama는 연구, 산업, 오픈 소스 프로젝트, NGO 및 비즈니스를 포함한 모든 부문의 소프트웨어 엔지니어를 지원하도록 설계되었다"며, "그러나 우리의 기본 모델과 지시 모델이 제공할 수 있는 것보다 지원해야 할 사용 사례가 여전히 더 많으며 Code Llama가 다른 사람들에게 영감을 주어 Llama 2를 활용하여 연구 및 상용 제품을 위한 새롭고 혁신적인 도구를 만들 수 있기를 희망합니다"라고 밝혔다.

현재, 코드 라마 코드는 깃허브(다운)를 공개돼 있으며, '코드 라마' 모델(다운)은 메타의 라이선스 하에 누구나 연구 및 상업적으로 사용할 수 있다.

한편, 이달 초 국내 AI 스타트업 업스테이지가 개발한 모델이 세계 최대 머신러닝 플랫폼 허깅페이스(HuggingFace)에서 운영하는 ‘오픈 LLM 리더보드’ 평가 점수에서 72.3점을 획득, 챗GPT의 기반인 GPT-3.5 성능을 뛰어넘고 1위를 차지하며, 세계 최고 오픈LLM 모델 구축으로 글로벌 AI 업계의 주목을 받고 있는 업스테이지의

김성훈 대표는 25일 SNS를 통해 코드 라마는 "성능이 GPT3.5는 한참 넘어서고 GPT4에 가깝습니다"라며, "회사 내부 코드를 파인튜닝해서 온프렘 등으로 사용한다면 보안도 유지되면서 개발자들의 효율 향상에 매우 큰 도움이 될 것이며, '라마 2+포스트 학습+파인튜닝'이 대세가 될 것 같습니다"라고 말했다.