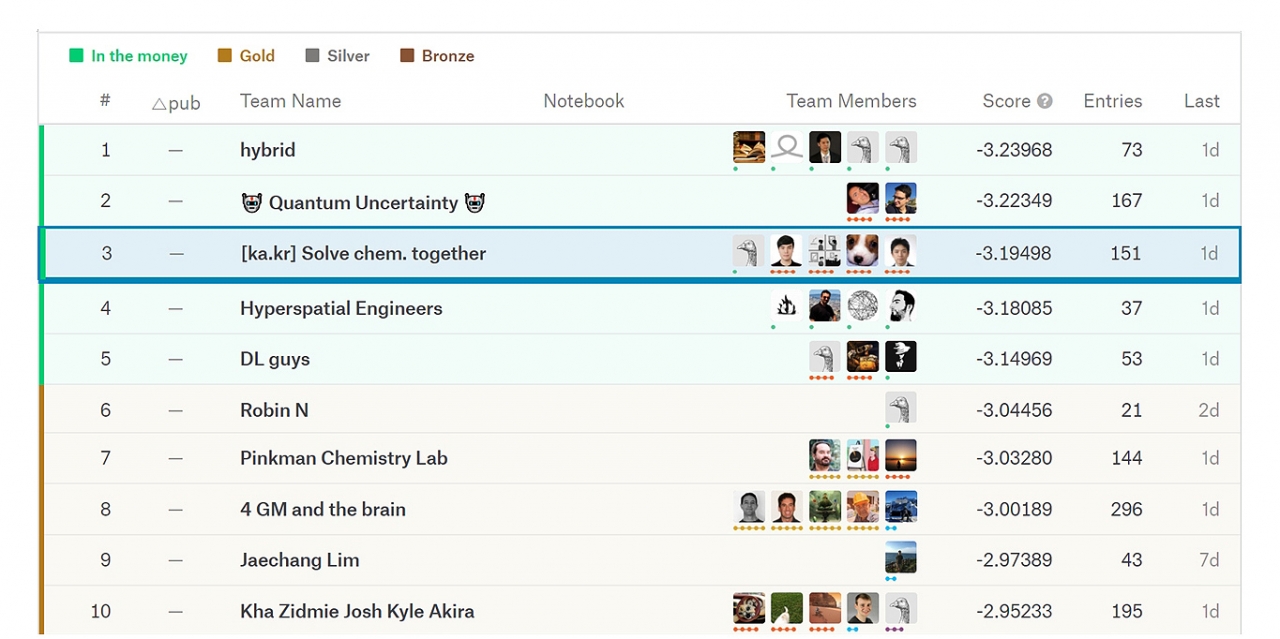

Ebay 김상훈, 중앙대 송원호, 마인즈앤컴퍼니 이영수, KAIST 이유한, KISTI 최성환 등 국내 5 명의 서로 다른 산·학·연 소속 연합팀 합작품.

딥러닝 모델인 트랜스포머를 화합물에 적용한 기술....다양한 분광분석기술에 활용 기대

구글 자회사인 캐클(Kaggle)이 주관하고 영국 챔스(CHAMPS, Chemistry and Mathematics in Phase Space)가 주최한 '분자 특성 예측(Predicting MolecularProperties)' 대회에서 국내 산·학·연 연합팀이 전 세계에서 참여한 2,749개 팀 중 3위에 오르는 쾌거를 거뒀다.

데이터 과학자 및 기계 학습자 온라인 커뮤니티이기도 한 캐글은 현재 회원이 194개국 100만명 이상으로 인공지능(AI) 경진대회 플랫폼으로 다양한 AI 대회를 주관하고 있다.

총 상금 3만 달러(약 3600만원)로 1위에서 5위까지 상금이 수여되는 이번 분자 특성 예측 대회는 유기화학을 포함한 화학 전반에서 널리 활용되는 핵자기공명(Nuclear Magnetic Resonance, NMR)을 이용한 유기물의 분석에 핵심적인 스핀-스핀 갈라짐을 더 정밀하게 예측하는 팀이 우승을 차지하는 대회다. 이번 대회에서는 AI기반 신약후보물질 연구를 위해 널리 사용되는 화합물 데이터베이스(QM9)에서 '스핀-스핀 갈라짐(spin-spin splitting)'의 양을 예측하는 기술력을 겨루었다.

스핀-스핀 갈라짐은 핵스핀(nulcear spin)을 가지는 원자들이 분자 내에서 느끼는 가리움 효과(shielding effect)에 따라 결정되는 값으로 분자의 구조를 결정하는 중요한 정보이다.

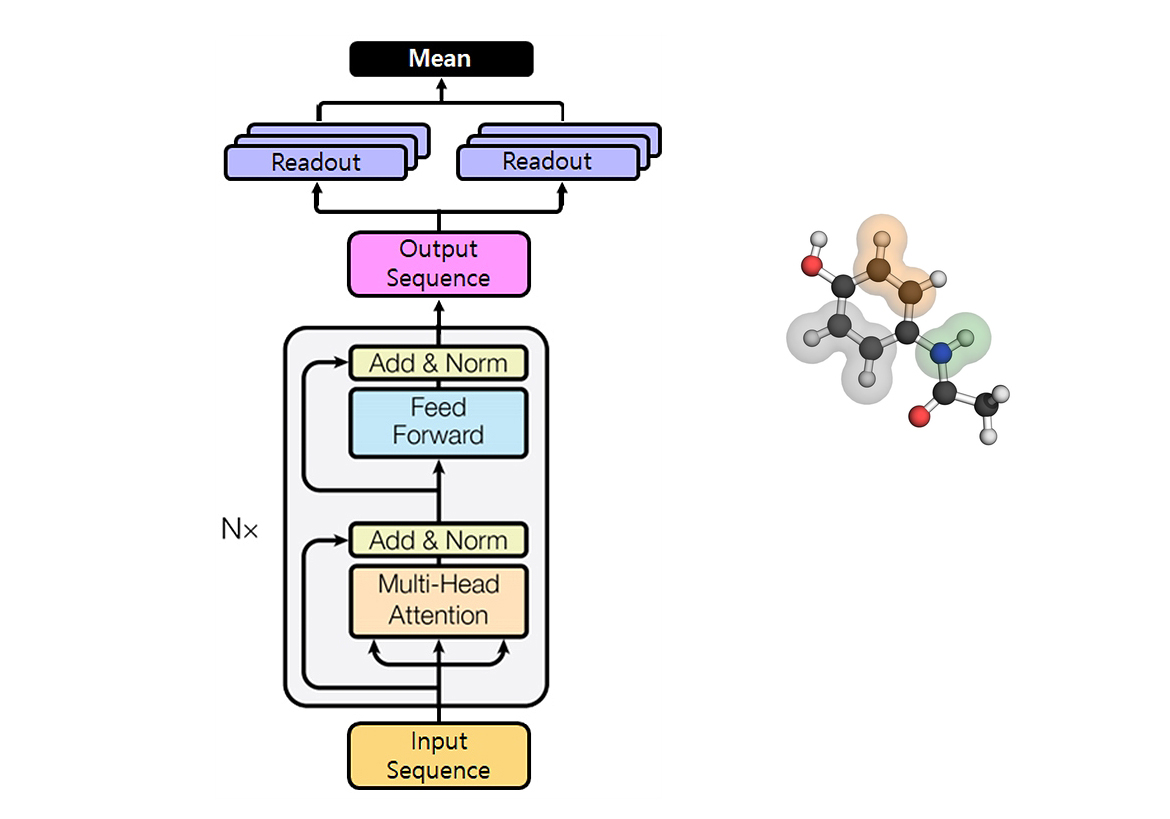

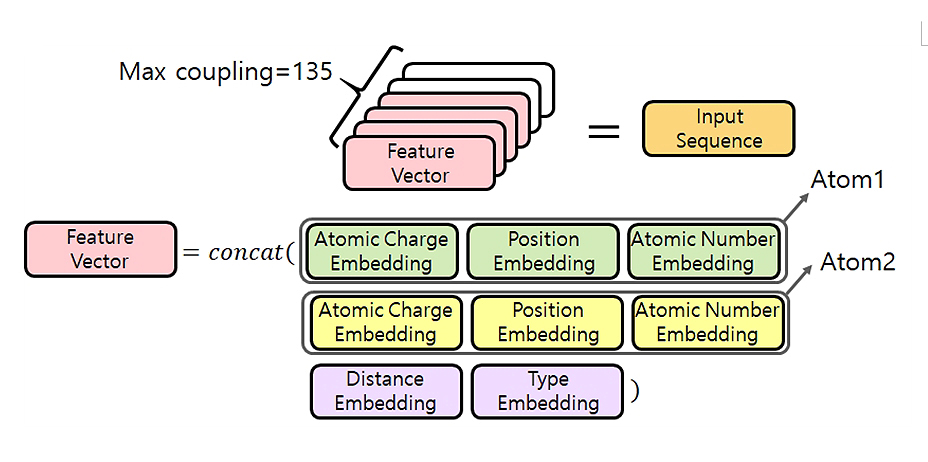

국내 산·학·연 소속 연합팀은 Ebay 김상훈, 중앙대학교 송원호, 마인즈앤컴퍼니 이영수, KAIST 이유한, KISTI 최성환 등 5 명으로 구성됐다. 이들 연합팀은 자연어처리 분야에 널리 사용되는 딥러닝 모델인 트랜스포머(Transformer)를 화합물에 적용해 값을 산출했다. 이 기법은 기존 슈퍼컴퓨터를 활용한 양자화학 시뮬레이션을 계산비용이 적은 AI기술로 대체 할 수 있을 뿐만 아니라 다양한 분광분석기술에 활용이 기대된다.

참고로 딥러닝 모델인 트랜스포머(Transformer)는 2017년 구글이 발표한 논문인 'Attention is all you need'에서 나온 모델이다. 이는 기존의 문장을 학습할 수 있는 seq2seq의 구조인 인코더-디코더를 따르면서도 어텐션(Attention)만으로 구현한 것이다. 이 모델은 순환신경망(RNN, 循環神經網)은 쓰지 않고 어텐션만을 사용해 인코더-디코더 구조를 만들어 학습 속도가 무척 빠르다는 장점을 갖고 있으며 성능도 RNN보다 우수한 것으로 알려져 있다.