구글 AI 연구팀은 손실 함수를 계산 그래프로 표현하고 이 표현을 통해 에이전트 집단을 진화시킴으로써 해석 가능한 새로운 RL 알고리즘을 학습하는 것에 대해 정의했다.

강화학습(Reinforcement learning. 이하, RL)에서 더 똑똑하고 다양한 문제를 해결할 수 있는 중요한 목표는 단일 범용 학습 알고리즘을 설계하는 것이다. 그러나 RL 알고리즘 분류법은 상당히 크고 새로운 RL 알고리즘을 설계하려면 광범위한 조정과 검증이 필요하기 때문에 여전히 어려운 과제이다.

여기에, 다양한 작업에 자동으로 일반화하는 새로운 RL 알고리즘을 설계할 수 있으며, 자신이 무엇을 알고 모르는지, 자신의 행동이 어떤 결과를 초래할지에 대해 인지하고 주어진 데이터와 환경만으로 기존에 학습했던 정보와 알고리즘을 새로운 문제에 적용해 마치, 인간처럼 해결하는 인공지능(AI) 메타러닝(Meta learning)이 이상적인 대안으로 떠오르고 있다.

최근 몇 년 동안 원시 데이터 세트에서 배포 가능한 머신러닝 모델까지의 전체 파이프 라인을 자동화하는 메타러닝이 적용된 오토ML(AutoML)은 신경망 아키텍처 및 모델 업데이트 규칙과 같은 머신러닝 구성 요소의 설계를 자동화하는 데 큰 성과를 내고 있다.

한 예로, 이미지 분류를 위한 더 나은 신경망 아키텍처와 휴대폰 및 하드웨어 가속기에서 실행하기 위한 효율적인 아키텍처를 개발하기 위해 사용되어 온 NAS(Neural Architecture Search)가 있다.

AutoML-Zero는 NAS 외에도 기본 수학 연산을 사용하여 전체 알고리즘을 처음부터 학습할 수 있다는 것을 보여준다. 이러한 접근 방식에서 한 가지 일반적인 주제는 신경망 아키텍처 또는 전체 알고리즘이 그래프로 표현되고 특정 목표에 대한 그래프를 최적화하기 위해 별도의 알고리즘을 사용한다는 것이다.

이러한 접근법은 감독된 학습을 위해 설계되었으며, 전체 알고리즘은 더 간단하다. 그러나 RL에서는 설계 자동화의 잠재적인 목표(예: 에이전트 네트워크의 신경망 아키텍처, 재생 버퍼에서 샘플링하는 전략, 손실 함수의 전체 공식 등)가 될 수 있는 알고리즘의 더 많은 구성 요소가 있으며, 이러한 구성 요소를 통합하는 것에 가장 좋은 모델 업데이트 절차가 무엇인지는 명확하지는 않다.

자동화 RL 알고리즘 검색을 위한 이전의 노력은 주로 모델 업데이트 규칙에 초점을 맞추었다. 이러한 접근 방식은 최적화 프로그램 또는 RL 업데이트 절차 자체를 학습하고 일반적으로 순환 신경망(Recurrent neural network. RNN) 또는 컨볼루션 신경망(Convolutional neural network, CNN)과 같은 신경망으로 업데이트 규칙을 나타내며, 이는 그레이디언트(Gradient) 기반 방법으로 효율적으로 최적화될 수 있다.

그러나 학습된 가중치는 불투명하고 영역별로 다르므로 이러한 학습된 규칙을 해석하거나 일반화할 수 없다.

여기에, 구글 AI 연구팀이 오는 5월 3일부터 7일까지 온라인으로 개최되는 국제적인 인공지능·학습 분야 글로벌 학회 ICLR 2021 (International Conference on Learning Representations 2021)에서 채택된 '진화하는 강화 학습 알고리즘 (Evolving Reinforcement Learning Algorithms- 다운)'에서 그래프 표현을 사용하고 AutoML 커뮤니티의 최적화 기술을 적용하여 분석적으로 해석 가능한 새로운 RL 알고리즘을 학습하는 것이 가능하다는 것을 보여준다.

특히, 연구팀은 경험에 대한 에이전트의 매개 변수를 계산 그래프로 최적화하는 데 사용되는 손실 함수를 나타내고, 일련의 간단한 훈련 환경에 걸쳐 계산 그래프의 모집단을 진화시키기 위해 규칙화된 진화(Regularized Evolution- 논문)를 사용한다.

이를 통해 RL 알고리즘이 점점 더 향상되고, 알고리즘은 더 복잡한 환경으로 심지어 아타리(Atari) 게임과 같은 시각적 관찰을 가진 복잡한 환경도 일반화된다.

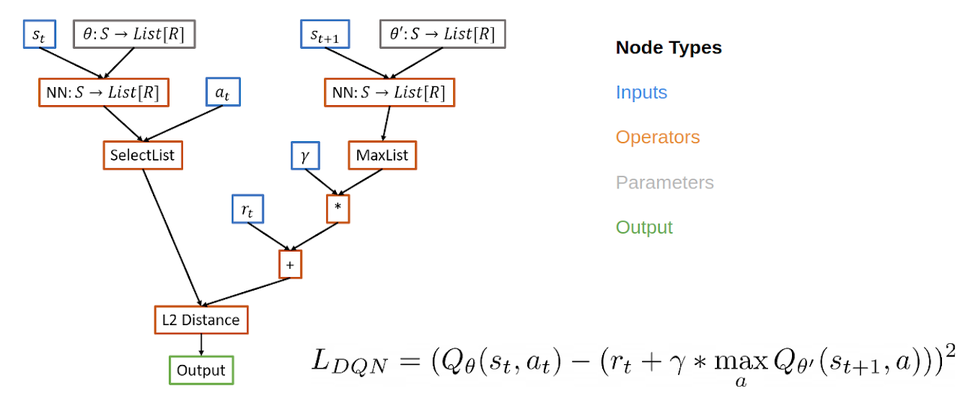

계산 그래프로서의 RL 알고리즘은 신경망 구조를 나타내는 그래프의 공간을 검색하는 NAS의 아이디어에 영감을 받아 RL 알고리즘의 손실 함수를 계산 그래프로 표현하여 RL 알고리즘을 메타 학습한다.

이 경우, 연구팀은 입력, 연산자, 파라미터 및 출력을 나타내는 노드를 사용하여 손실 함수에 대해 지시된 비순환 그래프를 사용한다. 예를 들어, 딥마인드의 DQN(Deep Q-Network- 참고)에 대한 계산 그래프에서 입력 노드는 재생 버퍼의 데이터를 포함하고, 연산자 노드는 신경망 연산자와 기본 수학 연산자를 포함하며, 출력 노드는 손실을 나타내며, 이는 경사 하강 법(Gradient Descent)으로 최소화된다.

이러한 표현에는 몇 가지 이점이 있다. 이 표현은 기존 알고리즘뿐만 아니라 발견되지 않은 새로운 알고리즘을 정의 할 만큼 충분히 표현적이며, 해석이 가능하다. 이 그래프 표현 방식은 인간이 설계한 RL 알고리즘과 동일한 방식으로 분석할 수 있으므로 전체 RL 업데이트 절차에 대해 블랙박스 함수 근사치를 사용하는 접근 방식보다 더 해석하기 쉽다.

만약 연구자들이 학습된 알고리즘이 왜 더 나은지 이해할 수 있다면, 그들은 알고리즘의 내부 구성 요소를 수정하여 그것을 개선하고 유익한 구성 요소를 다른 문제로 옮길 수 있다. 마지막으로 표현은 다양한 문제를 해결할 수 있는 일반적인 알고리즘을 지원한다.

연구팀은 이 표현을 PyGlove 라이브러리(Symbolic Programmingfor Automated Machine Learning- 다운)를 사용하여 구현했는데, 이 라이브러리는 그래프를 정규화된 진화로 최적화할 수 있는 검색 공간으로 간단하게 전환한다.

진화하는 RL 알고리즘

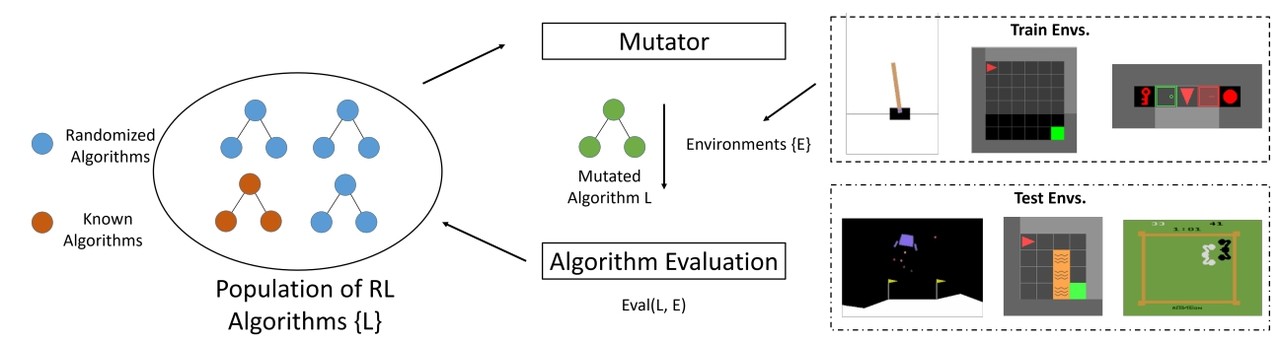

연구팀은 관심 있는 RL 알고리즘을 최적화하기 위해 진화 기반 접근법을 사용한다. 첫째, 무작위 그래프를 사용하여 훈련 에이전트 모집단을 초기화한다. 이러한 에이전트 모집단은 일련의 훈련 환경에서 병렬로 학습된다. 에이전트는 먼저 성능이 좋지 않은 프로그램을 신속하게 제거하기 위한 CartPole(참고)과 같은 쉬운 환경인 허들(hurdle) 환경에서 학습한다.

여기에, 에이전트가 허들 환경을 해결할 수 없을 경우, 0점으로 훈련이 조기에 중단된다. 그렇지 않으면 교육이 더 어려운 환경(예: Lunar Lander, 간단한 MiniGrid 환경 등)으로 진행된다.

알고리즘 성능이 평가되고 모집단을 업데이트하는 데 사용되며 더 유망한 알고리즘이 추가로 변경된다. 또 검색 공간을 줄이기 위해 새로 제안 된 알고리즘이 이전에 조사 된 알고리즘과 기능적으로 동일한 경우 건너 뛸 기능적 동등성 검사기를 사용한다. 이 루프는 새로운 돌연변이 후보 알고리즘이 훈련되고 평가됨에 따라 계속된다.

학습이 끝나면 연구팀은 최상의 알고리즘을 선택하고 보이지 않는 테스트 환경을 통해 그것의 성능을 평가한다.

연구팀은 실험에서 모집단 크기는 약 300개 에이전트였으며, 2~5만 번의 돌연변이 후 좋은 후보 손실 함수의 진화를 관찰하기 위해 약 3일간의 학습이 필요했다. 또 훈련 환경이 간단하고 훈련의 계산 및 에너지 비용을 제어하기 때문에 CPU에서 학습할 수 있었다. 학습 비용을 추가로 제어하기 위해 DQN과 같은 인간이 설계한 RL 알고리즘으로 초기 모집단에 시드했다.

학습된 알고리즘

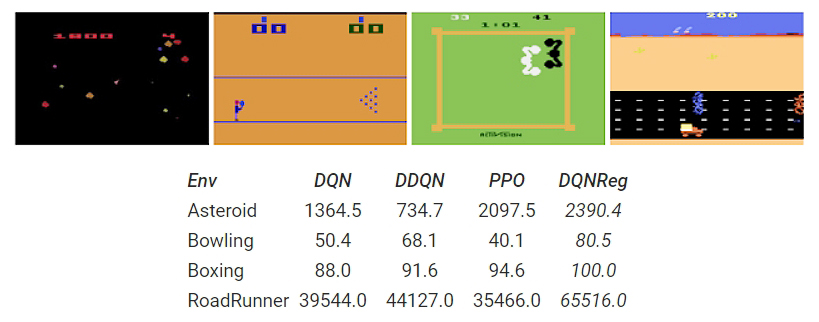

연구팀은 우수한 일반화 성능을 보여주는 두 가지 알고리즘을 강조한다. 첫 번째는 DQNReg로, 정규 제곱 벨만(Bellman) 오차에 Q-값에 가중 패널티를 추가하여 DQN을 기반으로 한다. 두 번째 학습된 손실 함수인 DQNClipped는 지배적인 용어가 Q-값의 최대값과 제곱된 벨만 오류(모듈로 상수)라는 간단한 형태를 가지고 있지만 더 복잡하다.

두 알고리즘 모두 Q-값을 정규화하는 방법으로 볼 수 있다. DQNReg가 소프트 제약 조건을 추가하지만, DQNClipped는 Q-값이 너무 커지면 이를 최소화하는 일종의 제약 최적화로 해석할 수 있다. 또 Q-값을 과대평가하는 것이 잠재적인 문제일 때 이 학습된 제약 조건이 훈련의 초기 단계에서 시작된다는 것을 보여준다. 이 제약 조건이 충족되면, 손실은 대신 원래의 제곱 벨만 오류를 최소화한다.

더 면밀한 분석에 따르면 DQN과 같은 기준선이 일반적으로 Q-값을 과대평가하는 반면, 연구팀의 학습된 알고리즘은 이 문제를 다른 방식으로 다루고 있다. DQNReg는 Q-값을 과소평가하는 반면, DQNClipped는 과대평가하지 않고 지상진리에 천천히 접근한다는 점에서 '이중 dqn(이중 Q- 학습을 통한 심층 강화학습. 참고)'과 유사한 행동을 한다.

이 두 알고리즘은 진화가 DQN으로 시드될 때 일관되게 출현한다는 점은 가치가 있다. 처음부터 학습하는 이 방법은 TD 알고리즘(Temporal difference learning)을 재발견한다. 연구팀은 현재, 완전성을 위해 진화 과정에서 발견 된 상위 1000개의 수행 알고리즘의 데이터 세트(다운)를 오픈 소스로 공개했다.

학습된 알고리즘 일반화 성능

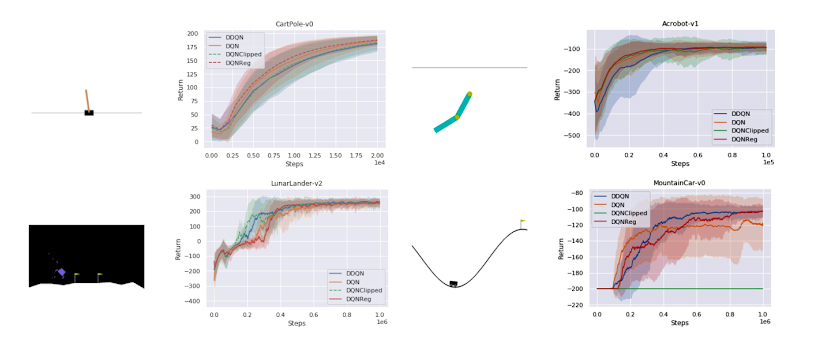

일반적으로 RL에서 일반화는 여러 작업에 걸쳐 일반화하는 훈련된 정책을 가리킨다. 그러나 이 연구에서는 알고리즘 일반화 성능에 관심이 있다. 즉, 이는 알고리즘이 일련의 환경에서 얼마나 잘 작동하는지 의미한다. 고전적인 제어 환경(참고)에서 학습된 알고리즘은 고밀도 보상 작업(CartPole, Acrobot, LunarLander)에서 기준을 일치시키고 희소 보상 작업인 MountainCar(참고)에서 DQN을 능가할 수 있다.

다양한 작업을 테스트하는 희소 보상 MiniGrid 환경 세트에서 DQNReg는 샘플 효율성과 최종 성능 측면에서 훈련 및 테스트 환경 모두에서 기준을 크게 능가한다는 것을 알 수 있다. 사실, 그 영향은 새로운 장애물의 크기, 구성 및 존재에 따라 달라지는 시험 환경에 훨씬 더 두드러진다.

또한 연구팀은 몇 가지 MiniGrid 환경에서 정상 DDQN 대 학습된 알고리듬 DQNReg의 성능을 시각화한다. 이러한 환경의 시작 위치, 벽 구성 및 개체 구성은 재설정할 때마다 랜덤화되므로 에이전트가 환경을 단순히 기억하는 대신 일반화할 필요가 있다. DDQN은 종종 의미 있는 행동을 학습하기 위해 고군분투하지만, DQNReg는 최적의 동작을 효율적으로 학습할 수 있다.

아울러 이미지 기반 Atari 환경에서도 학습이 이미지 기반이 아닌 환경에서 이루어 졌음에도 불구하고 성능이 향상되었다. 이는 일반화 가능한 알고리즘 표현을 사용하여 효율적으로 다양한 학습 환경에서 메타 러닝을 수행하면 근본적인 알고리즘 일반화를 가능하게 할 수 있음을 시사한다.

결론적으로 구글 AI 연구팀은 손실 함수를 계산 그래프로 표현하고 이 표현을 통해 에이전트 집단을 진화시킴으로써 해석 가능한 새로운 RL 알고리즘을 학습하는 것에 대해 정의했다. 계산 그래프 공식을 통해 연구자들은 인간이 설계한 알고리즘을 기반으로 하고 기존 알고리즘과 동일한 수학적 도구 세트를 사용하여 학습된 알고리즘을 구현할 수 있다.

또한 몇 가지 학습된 알고리듬을 분석했으며, 이를 엔트로피 정규화의 한 형태로 해석하여 가치 과대평가를 방지할 수 있었다. 이러한 학습된 알고리즘은 기준을 능가하고 보이지 않는 환경으로 일반화 할 수 있다. 상위 수행 알고리듬은 추가 분석 연구에 사용할 수 있을 것으로 보인다.