학습한 적 없는 사물을 segmentation하는 제로샷 의미체계 세분화(Zero-shot semantic segmentation)연구

인공지능(AI) 플랫폼 및 인공인간 전문 기업 마인즈랩 (대표 유태준)은 자사 연구팀 차성국 연구원과 국방과학연구소 왕유승 연구원이 공동으로 참여한 논문이 국제패턴인식협회(International Association for Pattern Recognition)의 글로벌 학술지인 '패턴인식저널(Pattern Recognition Letters, PRL)'에 채택됐다.

마인즈랩은 지난해 9월과 12월 세계 최고 권위의 인공지능 음성신호 처리학회인 INTERSPEECH 2021과 NeurIPS Workshop on ML for Creativity and Design 2021에 논문이 실린 데 이어 올해 또다시 SCIE급의 세계적인 학술지에 논문이 채택된 것이다.

특히, 지난 학술 성과들이 음성 분야의 인공지능 엔진과 관련된 것이었으나 이번 논문은 시각 엔진 분야로, 마인즈랩 연구진이 다양한 영역에서 연구성과를 올리고 있다. 최근 이슈가 되고 있는 시각 분야의 인공지능 관련 논문이 선정된 것은 의미가 크다는 평가다.

이번 논문은 학습한 적 없는 사물도 인식하는 zero-shot segmentation 연구로, 고가의 라벨링 비용 문제를 해결할 수 있는 획기적인 접근법을 제안한다. 차성국 연구원에 따르면 본 연구는 Multi-modal (vision+NLP) 개념이 유행하기 전인 2020년에 진행한 것으로, 현재는 Human-Object Interaction (HOI)까지 연구가 진행중이라는 설명이다.

머신러닝/딥러닝을 이용한 시각 인식은 빅데이터와 연산을 기반으로 최근 폭발적인 발전이 있는 연구 분야로 기존의 접근 방법들은 사물을 인식하기 위해 반드시 많은 데이터 학습이 필요했으나Zero-shot learning은 학습이 없이 새로운 사물을 인식한다.

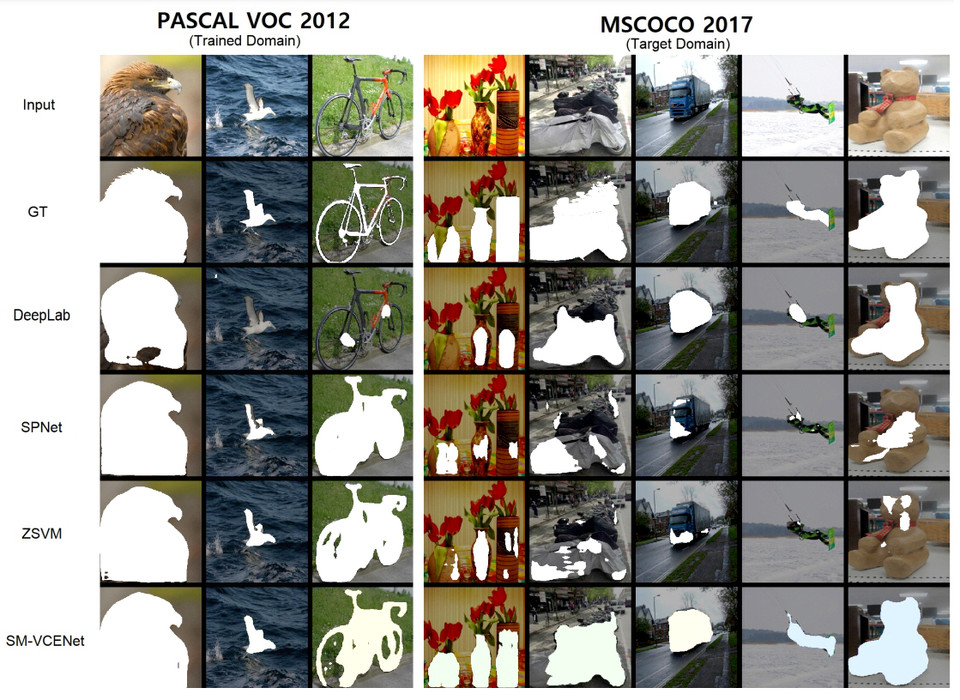

본 연구 논문 '공간 및 다중 스케일 인식 시각적 클래스 임베딩을 통한 제로샷 의미 분할(Zero-Shot Semantic Segmentation via Spatial and Multi-Scale Aware Visual Class Embedding-다운)'에서는 자연어 모델에서 사물에 대한 지식을 힌트로 사용하는 기존의 접근법의 보편화 한계를 비판하며, 그 대안으로 자연어 모델의 지식 대신 시각 모델의 지식을 사용하는 SM-VCENet을 제안한다.

또한 보편화성능을 측정할 수 있는 새로운 벤치마크 PASCAL2COCO를 제안한다. SM-VCENet은 zero-shot semantic segmentation 벤치마크인 PASCAL-5i에서 많은 차이로 최고 점수를 갱신했으며, PASCAL2COCO 벤치마크를 통해 보편화-견고함을 보였다.

한편, 세계적인 수준의 인공지능 기술력으로 평가 받고 있는 마인즈랩은 자체 개발한 글로벌 최고 SoTA(State of The Art) 수준의 AI 엔진 40여개와 외부 엔진까지 조합이 가능한 AI 응용프로그램 인터페이스 커넥터(API connector)인 '마음오케스트라' 플랫폼을 통해 고객 맞춤형 AI 고객 상담원, AI 돌보미, AI 경비원, AI 속기사 등의 인공인간을 제작, 공급하고 있다.