모델 LENA는 기존 기술 대비 절반 이하의 학습 시간으로도 모델 학습을 성공적으로 완료했으며, 나아가 기존 기술이 실패했던 대규모 학습 상황에서도 모델 학습을 성공적으로 완료

딥러닝은 수많은 계층(layer)으로 구성된 신경망 모델을 이용해 빅데이터를 학습하는 기술로, 4차 산업혁명을 위한 핵심기술로 평가받고 있다. 그러나 딥러닝은 빅데이터 학습을 위해 방대한 시간과 컴퓨팅 자원이 필요하며 이는 딥러닝 연구개발의 큰 장애물로 지적돼왔다.

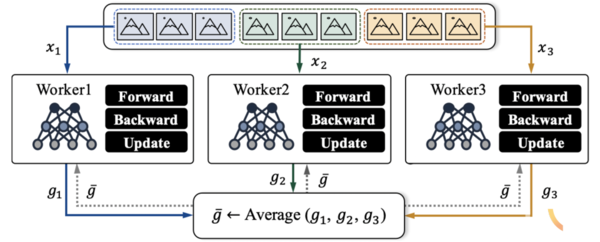

이런 단점을 해소하고자 최근 학계 및 산업계에서는 딥러닝 가속화를 위한 데이터 병렬(data parallelism)에 관한 연구를 활발히 진행하고 있다.

여기에, 한양대학교(총장 김우승) 컴퓨터소프트웨어학부 김상욱(인공지능 혁신인재 교육연구단장) 교수팀이 대규모 인공지능(AI) 딥러닝 모델학습을 위한 학습률(learning rate) 조정기술 ‘레나(LENA)’을 개발했다.

LENA는 기존 기술 대비 절반 이하의 학습 시간으로도 모델 학습을 성공적으로 완료했으며, 나아가 기존 기술이 실패했던 대규모 학습 상황에서도 모델 학습을 성공적으로 완료한 것으로 나타났다.

데이터 병렬 학습에서 워커들의 학습 결과를 모델에 얼마만큼 반영할 지를 나타내는 값을 학습률이라 하며, 학습률이 높을수록 학습결과를 모델에 많이 반영한다는 것을 의미한다.

일반적으로 학습이 진행될수록, 학습의 규모(동시에 학습하는 데이터의 양)가 증가할수록, 학습 결과의 질이 높아지는 경향이 있다. 따라서 이러한 경우 양질의 학습 결과를 모델에 많이 반영하기 위해 학습률을 높게 설정한다.

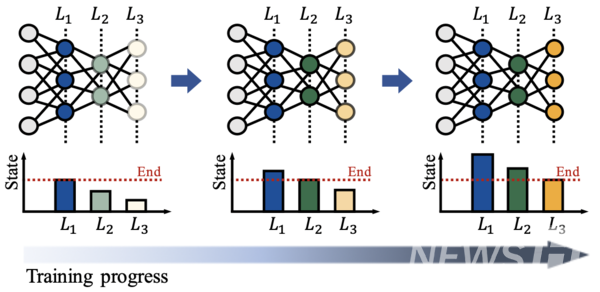

딥러닝 모델은 수많은 계층으로 구성되며, 각 계층은 자신만의 고유한 역할을 가지고 있다. 김 교수팀은 계층별 역할 차이에 대한 이해를 기반으로 ‘계층별 최적의 학습률이 다를 것’이라는 가정을 세우고 면밀한 분석을 거쳐 계층별로 학습 상태가 현저히 다르다는 것을 확인했다.

이러한 분석을 통해 김 교수팀은 기존 학습률 조정 기법들이 모델의 계층별 학습 상태의 차이를 고려하지 않고 모든 계층에 동일한 학습률을 적용하고 있음을 밝혔고, 이것이 대규모 데이터 병렬 학습 시 모델 정확도를 떨어뜨리는 원인임을 파악했다.

이를 기반으로 김 교수팀은 모델의 계층별 학습 진행 상태에 따라 학습률을 차별화해 조정하는 기술 ‘LENA’를 개발했다. LENA는 모델에 대한 학습 진행 상태를 계층별로 따로 파악하고, 이를 기반으로 각 계층에 대한 학습률을 차별화해 결정한다.

이와 더불어 대규모 데이터 병렬 학습의 초기에 발생할 수 있는 학습불안정 문제를 완화하기 위한 ‘계층별 학습률 워밍업(warm-up) 전략’도 함께 제안했다.

그 결과 LENA는 기존 학습률 조정 기법들과 비교해 약 45%의 학습 시간만으로 동일한 모델 정확도를 빠르게 달성했고, 기존 학습률 조정 기법들이 실패했던 대규모 학습 상황에서도 높은 모델 정확도를 달성했다.

LENA는 현존하는 딥러닝 기술뿐 아니라 향후 개발될 미래 기술에도 적용 가능해 AI 분야의 많은 영역에서 활용될 수 있는 잠재력이 큰 기술로 평가받는다.

한편, 이번 연구는 세계적으로 인정받는 데이터 사이언스 분야의 최우수 컨퍼런스 중 하나로 오는 25일부터 29일까지 닷새간 프랑스 리옹에서 온라인으로 개최되는 ‘국제월드와이드웹컨퍼런스(TheWebConf2022)’에서 '모든 계층이 동일하지 않음: 대규모 DNN 교육을 위한 계층별 적응 접근 방식(Not All Layer Are Equal: A Layer-Wise Adaptive Approach Toward Large-Scale DNN Training)'이란 제목으로 발표될 예정이다.