영상 속에서 보다 정확한 깊이 정보를 얻어낼 수 있어 3D 가상현실(VR)·증강현실(AR) 영상 품질 개선, 메타버스, 영상 기반 인지 탐지 등과 같은 컴퓨터 비전 응용 분야의 발전에 기여할 것으로 기대...

지스트(광주과학기술원·김기선 총장) 연구진이 영상 속 ‘깊이 정보’를 인공지능(AI) 알고리즘을 통해 정확하게 추정할 수 있는 기술을 개발했다.

이를 통해 통해 영상 속에서 보다 정확한 깊이 정보를 얻어낼 수 있어 3D 가상현실(VR)·증강현실(AR) 영상 품질 개선, 메타버스, 영상 기반 인지 탐지 등과 같은 컴퓨터 비전 응용 분야의 발전에 기여할 것으로 기대된다.

영상 속의 깊이 정보는 AR·VR의 3차원 공간, 자연스러운 이미지 합성 등 응용하는 여러 분야에서 핵심 요소로 이용되는데, 만약 깊이 정보가 없으면 3차원 공간에 대한 정보가 없어 응용 단계에서 부자연스러운 영상이 구현될 수밖에 없다.

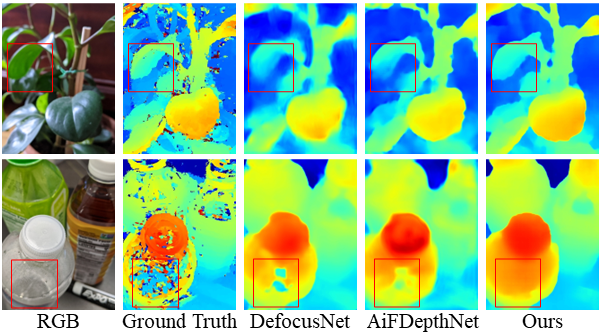

최근 DSLR 카메라나 스마트폰 카메라의 자동 초점 기능을 통해 얻어진 초점 영상들을 활용해 영상의 깊이 정보를 얻는 연구가 구글 등 글로벌 IT 기업이나 여러 대학에서 진행되고 있는데, 기존 방법론들은 좁은 피사계 심도를 갖는 단일 영상 기반의 깊이 정보를 추정하는 것이 대부분이며, 자동 초점 영상이 정렬이 되어 있다고 가정하거나

영상 데이터의 특징에 따라 사용자가 직접 추가 설정을 통해 자동 초점 영상을 정렬해야 하기 때문에 깊이 정보의 정확도가 떨어지는 한계가 있다.

지스트 AI대학원 전해곤 교수 연구팀은 AI 기법을 통해 자동 초점 기능에서 사용하는 영상 전체를 이용해 깊이 정보를 보다 정확히 추정하는 알고리즘을 고안했다.

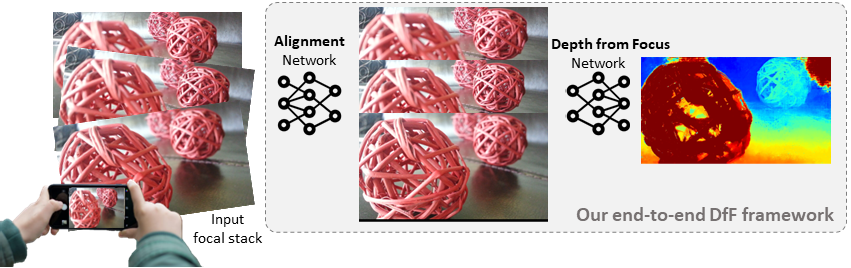

연구팀은 카메라에서 출력해주는 메타데이터에서 자동 초점 기능을 통해 얻어진 영상을 인공지능 네트워크로 정렬하고, 이를 이용해 깊이 정보까지 추정하는 엔드-투-엔드 기법을 세계 최초로 제안했다.

촬영한 초점 영상들은 ▷이미지 상이 보이는 정도, 즉 화각(field of view)을 메타데이터로 각 초점 별로 계산한 후 ▷초점 영상들을 특정 화각에 맞게 잘라내 촬영한 모든 영상들의 화각을 동일하게 맞춰준다. ▷연구팀이 설계한 인공지능 네트워크로 초점 영상들을 추가로 정렬시켜서 잘 정렬된 초점 영상들을 최종적으로 얻을 수 있다.

특히, 이번 성과를 통해 측정한 깊이 정보는 공인 벤치마크에서 오차와 정확도를 측정하는 총 20개의 척도 중 17개에서 1위를 기록하고 있으며, 다양한 카메라 및 환경 조건에서도 일관적으로 우수한 성능을 보였다.

전해곤 교수는 “이번 연구는 기존에 수동적으로 해결했던 초점거리 영상 정렬과 깊이 정보 추정 알고리즘의 한계를 극복하는 인공지능 모델을 제안한 것”이라며 “인공지능 네트워크를 통해 얻은 깊이 정보를 활용하면 메타버스, 증강현실, 영상 기반 인지 탐지와 같은 응용 분야 발전에 기여할 것으로 기대한다“고 말했다.

한편, AI대학원 전해곤 교수(교신저자)와 석박통합과정 원창연(제1저자) 학생이 주도한 이번 연구는 'Learning Depth from Focus in the Wild(다운)'란 제목으로 오는 10월 23일부터 27일까지 이스라엘 텔아비브에서 개최되는 인공지능·컴퓨터비전 분야 세계 최고 학회인 컴퓨터 비전 유럽 회의(European Conference on Computer Vision. ECCV 2022)에서 발표될 예정이다. 현재, 관련 데이터세트 및 코드는 깃허브(다운)를 통해 공개돼 있다,