이제부터 고객은 대규모 언어 모델 붐(Bloom) 및 GPT-2를 사용할 수 있는 세이지메이커 점프스타트, 허깅 페이스 AWS 딥러닝 컨테이너 또는 AWS 트레이니엄, AWS 인페렌티아 등 AWS에서 허깅 페이스 모델을 사용할 수 있다

자연어 처리(NLP) 애플리케이션용으로 구축된 트랜스포머(Transformers) 라이브러리와 사용자가 머신러닝 모델 및 데이터 세트를 공유할 수 있는 세계 최대 플랫폼이자 커뮤니티인 허깅페이스(Hugging Face)가 아마존웹서비스(이하, AWS)와 생성 AI를 위한 대규모 언어 및 비전 모델의 학습과 미세 조정 등으로 배포를 가속화하기 위해 상호 협업을 확대했다.

생성 인공지능(Generative AI) 애플리케이션은 텍스트 요약, 질문에 대한 답변, 코드 생성, 이미지 생성, 에세이 및 기사 작성 등 다양한 작업을 수행할 수 있다.

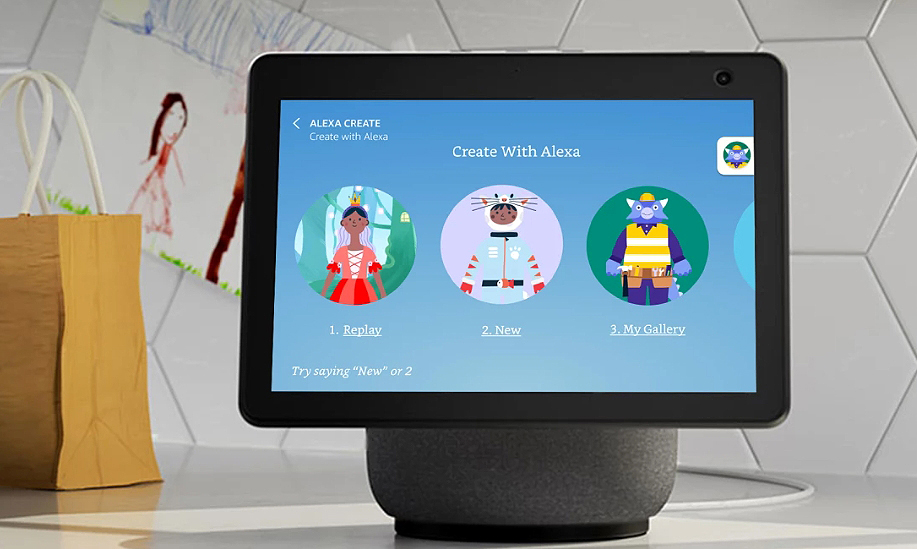

AWS는 생성 AI를 이미, 수년전부터 적용하고 있다. 예를 들어, 아마존(Amazon)은 AI를 사용하여 고객이 매주 수십억 번 상호 작용하는 알렉사(Alexa)와의 대화 환경을 제공하고 있으며, 아마존 에코 디바이스를 스토리텔링 동반자로 바꿔주는 '알렉사로 만들기(Create with Alexa-보기)'와 같은 새로운 경험의 일부로 생성 AI를 사용하고 있다.

또한 M5는 아마존의 여러 팀이 애플리케이션에 대규모 모델을 도입할 수 있도록 지원하는 그룹으로, 대규모 모델을 학습시켜 아마존닷컴(Amazon.com)의 검색 결과를 개선한다.

아울러, 인프라, 고객이 머신러닝 모델을 제작, 훈련, 배포할 수 있도록 지원하는 아마존 세이지메이커(Amazon SageMaker-참조), IDE의 코드와 주석을 기반으로 코드 추천을 생성하여 개발자의 생산성을 향상시키는 서비스인 '아마존 코드위스퍼러(Amazon CodeWhisperer-보기)'와 같은 AI 서비스 등 머신러닝의 모든 영역에서 지속적으로 혁신하고 있다. 또, 대규모 언어 및 비전 모델의 학습을 위한 AWS 트레이니엄(AWS Trainium-보기)과 추론을 위해 특별히 제작된 ML 가속기 AWS 인페렌티아(AWS Inferentia-보기)을 구축했다.

이번 허깅 페이스가 AWS를 선택한 이유는 모든 개발자 및 데이터 과학자가 머신러닝 모델을 빠르게 구축, 훈련 및 배포할 수 있도록 하는 완전 관리형 서비스로 머신러닝 프로세스의 각 단계에서 부담스러운 작업을 제거하여 고품질의 모델을 보다 쉽게 개발할 수 있도록 하는 것으로 아마존 세이지메이커, AWS 트레이니엄, AWS 인페렌티아 등에서 허깅 페이스 모델을 학습, 미세 조정, 배포할 수 있는 플랫폼 전반에서 유연성을 제공하기 때문이다.

이를 통해 허깅 페이스를 이용하는 개발자 및 연구자들은 성능을 쉽게 최적화하고 비용을 절감하여 생성 AI 애플리케이션을 더 빠르게 개발하고 배포할 수 있게 됐다.

특히, 대규모 언어 및 비전 모델의 학습을 위한 AWS 트레이니움은 학습 시간을 단축하는 동시에 동급의 GPU 기반 인스턴스 대비 최대 50%의 훈련 비용을 절감할 수 있으며, AWS 인페렌티아를 기반으로 하는 Amazon EC2의 새로운 Inf2 인스턴스(보기)는 최신 세대의 대규모 언어 및 비전 모델을 배포하고 최대 4배 높은 처리량과 최대 10배 낮은 지연 시간을 제공함으로써 Inf1의 성능을 향상시키기 위해 특별히 설계되었다.

개발자는 머신러닝용 도구와 워크플로우가 포함된 서비스인 아마존 세이지메이커와 같은 관리형 서비스를 통해 AWS 트레이니엄 및 AWS 인페렌티아를 사용할 수 있다. 또는 Amazon EC2에서 자체 관리할 수도 있다.

이제부터 고객은 대규모 언어 모델 붐(Bloom-보기) 및 GPT-2(다운)를 사용할 수 있는 세이지메이커 점프스타트(SageMaker JumpStart-보기), 허깅 페이스 AWS 딥 러닝 컨테이너(Hugging Face AWS Deep Learning Containers, DLC-보기) 또는 AWS 트레이니엄, AWS 인페렌티아에 모델을 배포하는 설명서(보기)를 통해 AWS에서 Hugging Face 모델을 사용할 수 있다

허깅 페이스 DLC에는 최적화된 변환기, 데이터 세트 및 토크나이저 라이브러리가 포함되어 있어 최소한의 코드 변경으로 몇 주가 아닌 몇 시간 내에 생성 AI 애플리케이션을 대규모로 미세 조정하고 배포할 수 있다. 세이지메이커 점프스타트 및 허깅 페이스 AWS 딥러닝 컨테이너는 Amazon SageMaker가 제공되는 모든 지역에서 추가 비용 없이 사용할 수 있다.