한동현 MIT 전기공학 및 컴퓨터과학 박사 후 연구원이 제 1저자로 최대 100 FPS 이상의 렌더링 속도로 기존 GPU보다 911배 빠른며, 1개 영상화면 처리 당 에너지효율 역시 GPU 대비 26,400배 높인 연구 결과로 VR/AR 헤드셋, 모바일 기기에서도 인공지능 기반 실시간 렌더링의 가능성 열어

KAIST(총장 이광형)는 전기및전자공학부 유회준 교수 연구팀이 실사에 가까운 이미지를 렌더링할 수 있는 인공지능 기반 3D 렌더링을 모바일 기기에서 구현, 고속, 저전력 인공지능(AI) 반도체인 '메타브레인(MetaVRain)'을 세계 최초로 개발했다.

연구팀이 개발한 인공지능 반도체는 GPU로 구동되는 기존 레이 트레이싱(ray-tracing) 기반 3D 렌더링을 새로 제작된 AI 반도체 상에서 인공지능 기반 3차원으로 만들어, 기존의 막대한 비용이 들어가는 3차원 영상 캡쳐 스튜디오가 필요없게 되므로 3D 모델 제작에 드는 비용을 크게 줄이고, 사용되는 메모리를 180배 이상 줄일 수 있다.

특히, 블렌더(Blender) 등의 복잡한 소프트웨어를 사용하던 기존 3D 그래픽 편집과 디자인을 간단한 인공지능 학습만으로 대체하여, 일반인도 손쉽게 원하는 스타일을 입히고 편집할 수 있다는 장점이 있다.

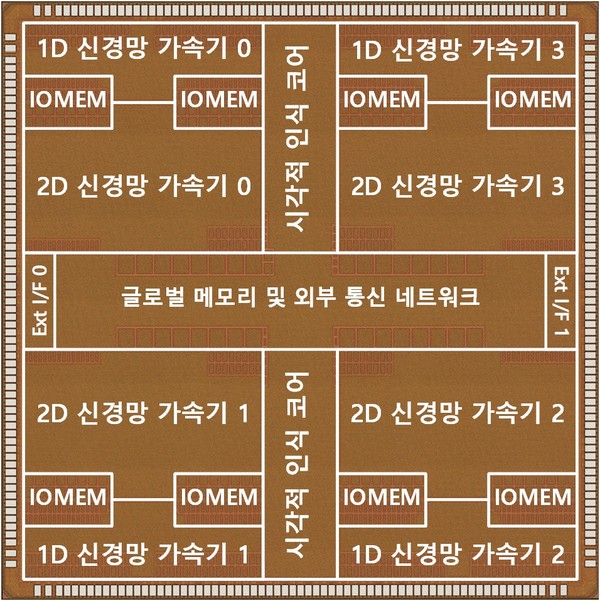

유 교수팀은 인공지능을 통해 3D 렌더링을 구현할 때 발생하는 비효율적인 연산들을 발견하고 이를 줄이기 위해 사람의 시각적 인식 방식을 결합한 새로운 컨셉의 반도체를 개발했다.

사람은 사물을 기억할 때, 대략적인 윤곽에서 시작하여, 점점 그 형태를 구체화하는 과정과 바로 직전에 보았던 물체라면 이를 토대로 현재의 물체가 어떻게 생겼는지 바로 추측하는 인지능을 가지고 있다.

이러한 사람의 인지 과정을 모방하여, 새롭게 개발한 반도체는 저해상도 복셀을 통해 미리 사물의 대략적인 형태를 파악하고, 과거 렌더링했던 결과를 토대로, 현재 렌더링할 때 필요한 연산량을 최소화하는 연산 방식을 채택하였다.

유 교수팀이 개발한 메타브레인은 사람의 시각적 인식 과정을 모방한 하드웨어 아키텍처뿐만 아니라 최첨단 CMOS 칩을 함께 개발하여, 세계 최고의 성능을 달성하였다.

메타브레인은 인공지능 기반 3D 렌더링 기술에 최적화되어, 최대 100 FPS 이상의 렌더링 속도를 달성하였으며, 이는 기존 GPU보다 911배 빠른 속도다. 뿐만아니라, 1개 영상화면 처리 당 소모에너지를 나타내는 에너지효율 역시 GPU 대비 26,400배 높인 연구 결과로 VR/AR 헤드셋, 모바일 기기에서도 인공지능 기반 실시간 렌더링의 가능성을 열었다.

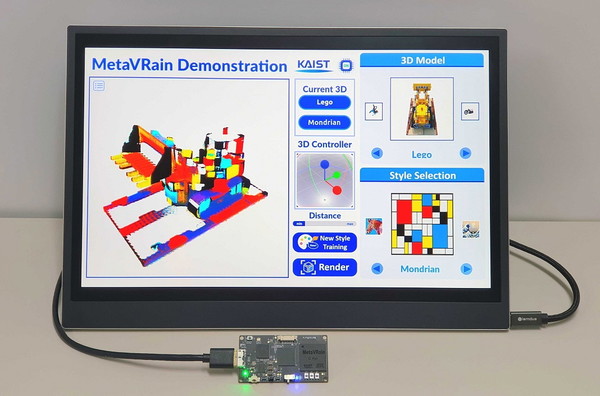

한동현 박사과정이 제1 저자로 나선 연구팀(류준하, 김상엽, 김상진)은 메타브레인의 활용 예시를 보여주고자, 스마트 3D 렌더링 응용시스템을 함께 개발하였으며, 사용자가 선호하는 스타일에 맞춰, 3D 모델의 스타일을 바꾸는 예제를 보여주었다.

인공지능에게 원하는 스타일의 이미지를 주고 재학습만 수행하면 되기 때문에, 복잡한 소프트웨어의 도움 없이도 손쉽게 3D 모델의 스타일을 손쉽게 바꿀 수 있다. 유 교수팀이 구현한 응용시스템의 예시 이외에도, 사용자의 얼굴을 본떠 만든 실제에 가까운 3D 아바타를 만들거나, 각종 구조물들의 3D 모델을 만들고 영화 제작 환경에 맞춰 날씨를 바꾸는 등 다양한 응용 예시가 가능할 것으로 기대된다.

연구팀은 메타브레인을 시작으로, 앞으로의 3D 그래픽스 분야 역시 인공지능으로 대체되기 시작할 것으로 기대한다며, 인공지능과 3D 그래픽스의 결합은 메타버스 실현을 위한 큰 기술적 혁신이라는 점을 밝혔다.

연구를 주도한 KAIST 전기및전자공학부 유회준 교수는 “현재 3D 그래픽스는 사람이 사물을 어떻게 보고 있는지가 아니라, 사물이 어떻게 생겼는지를 묘사하는데 집중하고 있다”라며 “이번 연구는 인공지능이 사람의 공간 인지 능력을 모방하여 사람이 사물을 인식하고 표현하는 방법을 차용함으로써 효율적인 3D 그래픽스를 가능케 한 연구”라고 본 연구의 의의를 밝혔다.

또한 “메타버스의 실현은 본 연구에서 보인 것처럼 인공지능 기술의 혁신과 인공지능 반도체의 혁신이 함께 이루어질 것”이라 미래를 전망하였다.

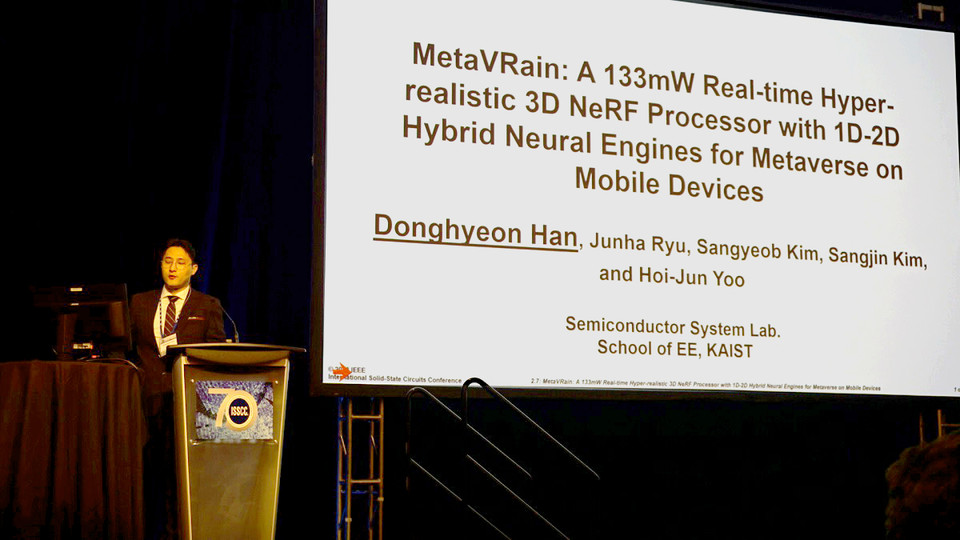

한편, KAIST 한동현 박사과정은 지난 2월 박사학위를 취득하고 현재, 매사추세츠 공과대학(MIT)에서 전기공학 및 컴퓨터 과학 박사 후 연구원으로 재직 중이다. 이번 연구는 지난 2월 18일부터 22일까지 샌프란시스코에서 개최된 국제고체회로설계학회(ISSCC 2023)에서 '메타브레인: 모바일 장치의 메타버스를 위한 1D-2D 하이브리드 뉴럴 엔진이 탑재된 133mW 실시간 초실감형 3D NeRF 프로세서(MetaVRain: A 133mW Real-time Hyper-realistic 3D NeRF Processor with 1D-2D Hybrid Neural Engines for Metaverse on Mobile Devices)' 이란 제목으로 발표됐다.

해당 논문은 곧 공개될 예정이며, 아래는 MetaVRain 데모 영상이다.