차세대 고성능 메모리 소자 기술로 주목받고 있는 강유전체 물질을 활용하여 정보의 저장, 처리 및 연산이 모두 가능...인공지능·자율주행·사물인터넷 등 저전력·고집적도를 만족하는

방대하고 복잡한 데이터를 머리카락보다 1만 배 이상 얇은 3차원 메모리 소자에 저장·처리할 수 있는 기술을 국내 연구진이 개발했다.

한국연구재단(이사장 이광복)은 POSTECH(포항공과대학교, 총장 김무환) 신소재공학과 이장식 교수 연구팀이 차세대 고성능 메모리 소자 기술로 주목받고 있는 강유전체(ferroelectric) 물질을 활용하여 정보의 저장, 처리 및 연산이 모두 가능한 차세대 3차원 구조의 고집적 메모리 어레이(memory array)를 개발했다고 밝혔다.

최근 인공지능·자율주행·사물인터넷 등의 활용이 활발해지면서 이에 필요한 메모리 용량이 지속 증가하고 있지만, 공정이 복잡하고 저전력·고집적도를 만족하는 기술 개발에 어려움을 겪고 있다.

더불어, 비정형의 방대한 정보를 메모리 내에서 실시간으로 분석하는 인-메모리 컴퓨팅 기술의 활용도 역시 높아지는 상황이다. 인-메모리 컴퓨팅 기술을 구현하기 위해서는 현재 상용화된 메모리 수준의 집적 기술과 동작 방식 관련 연구가 시급하다.

현재까지의 관련 연구는 단위 소자 및 이를 2차원 평면상에서 집적한 어레이 기술 개발에 집중되었는데, 이는 정보의 양이 늘어날수록 어레이의 면적이 계속 커져야 하는 한계가 있었다.

이장식 교수 연구팀은 인-메모리 컴퓨팅 어레이에서 활용 가능한 고성능 메모리 소자를 구현하기 위해 강유전체 물질을 이용한 메모리 소자에 주목했다.

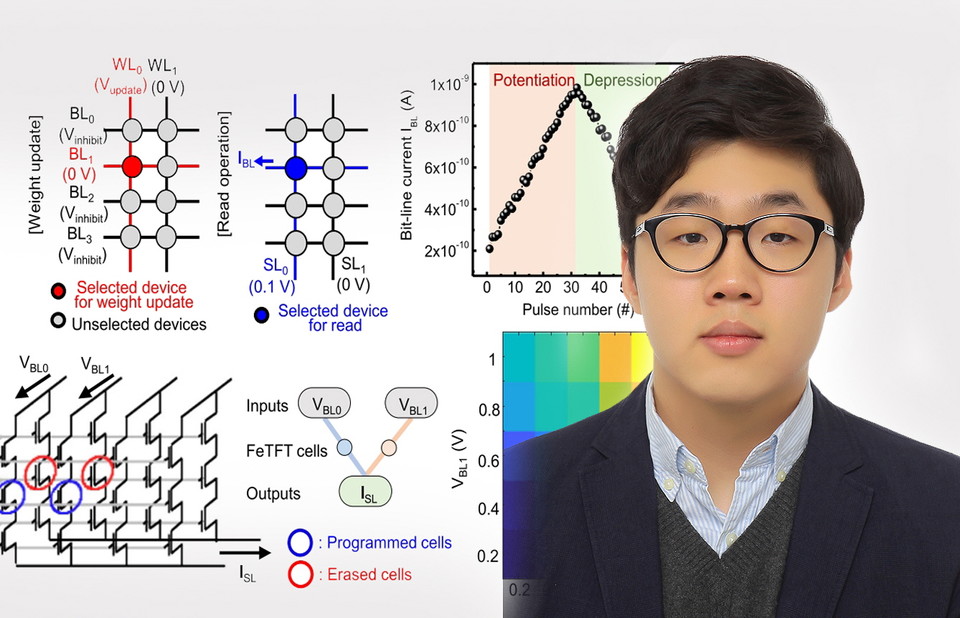

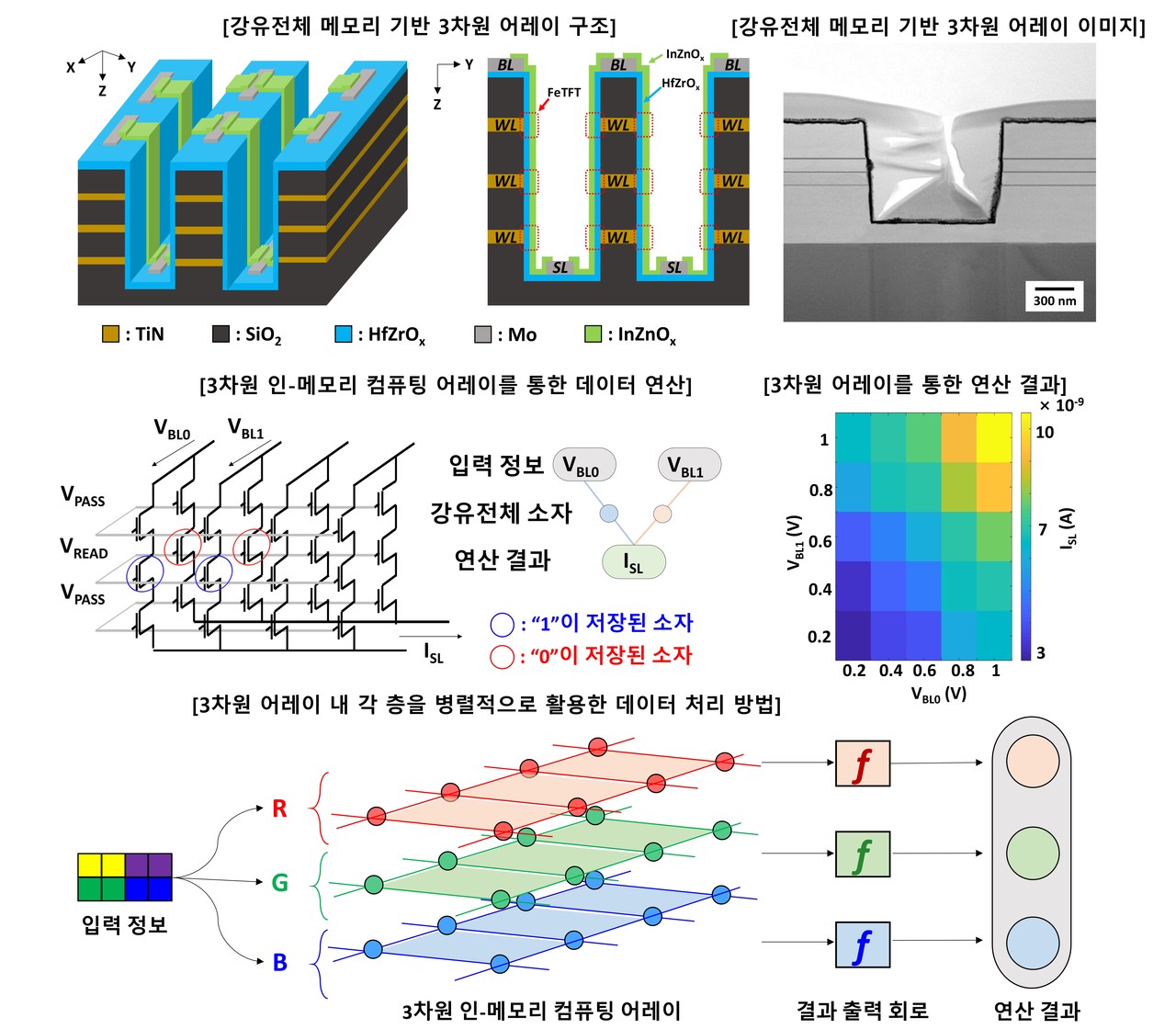

연구팀은 산화 하프늄 기반 강유전체 물질과 산화물 반도체 채널 층을 활용하여 고성능 강유전체 메모리 소자를 개발하고, 이를 어레이 구조로 집적한 인-메모리 컴퓨팅 어레이를 구현하였다.

특히, 이를 수직으로 적층해 복잡한 정보의 처리를 각 층에서 병렬적으로 진행 가능한 3차원 구조의 어레이를 제시하였으며, 여러 색이 포함된 그림과 같이 복잡한 형태의 정보 처리가 가능함을 확인하였다.

연구팀은 3차원 구조의 강유전체 메모리의 크기를 머리카락 굵기의 1만 2,000분의 1의 10나노 수준으로 소형화시켜 현재 상용화된 메모리에 비하여 높은 집적도의 인-메모리 컴퓨팅 어레이 구현 가능성도 확인했다.

이장식 교수는 “이번에 개발한 기술은 비정형의 복잡한 정보 처리가 필요한 인공지능, 무인자동차, 사물인터넷, 메타버스 등 다양한 분야에 활용될 수 있을 것으로 기대된다.”고 밝혔다.

한편, 신소재공학과 김익재, 김민규 박사가 각 제1저자와 제2저자로 참여한 이번 연구성과는 국제학술지 네이처 커뮤니케이션즈(Nature Communications)에 'Highly-scaled and fully-integrated 3-dimensional ferroelectric transistor array for hardware implementation of neural networks(아래 참조)' 란 제목으로 최근 게재되었다.