AMD CDNA 3 아키텍처 기반으로 최대 192GB의 HBM3 메모리를 지원해 LLM 훈련과 생성 AI 워크로드에 필요한 컴퓨팅 및 메모리 효율성을 제공...하나의 가속기에 매개변수가 400억 개인 팔콘-40(Falcon-40)과 같은 LLM을 장착할 수 있다.

AMD가 인공지능(AI), 컴퓨팅의 미래를 형성할 제품, 전략 및 생태계 파트너를 발표하며 데이터 센터 혁신의 비전을 밝혔다.

현지시간 13일 샌프란시스코에서 열린 자사의 'AMD 데이터 센터 및 AI 기술 프리미어(AMD Data Center and AI Technology Premiere)' 통해 대형언어모델(LLM) 및 생성 AI를 위한 최적의 가속기 'AMD 인스팅트 MI300X(AMD Instinct MI300X)'와 데이터 센터에 특화된 클라우드 네이티브 및 테크니컬 컴퓨팅을 위한 새로운 'AMD EPYC 프로세서'를 발표했다.

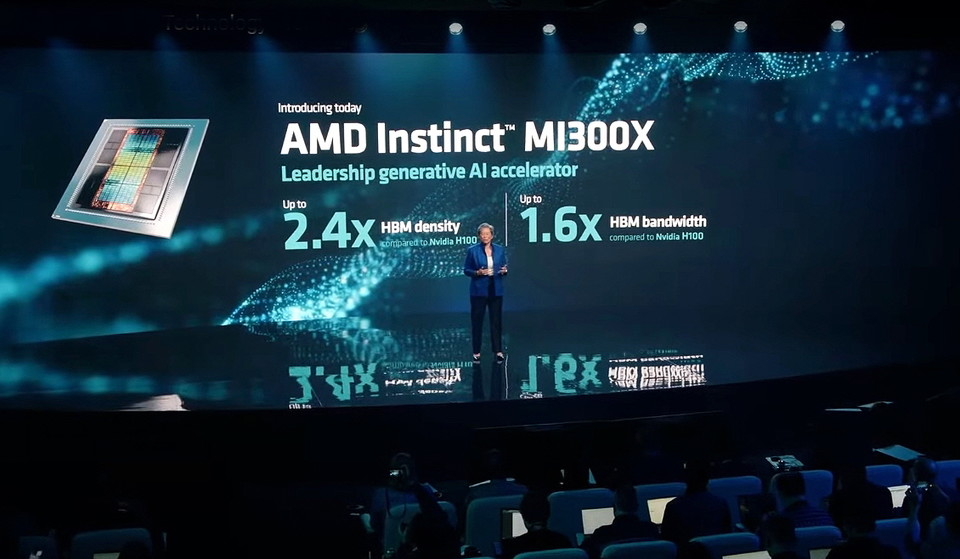

특히, 주요 외신들은 이날 발표된 '인스팅트 MI300X' 가속기는 엔비디아에 강력한 도전장을 내민 것이라고 보도했다. 사양으로만 보면 MI300X가 엔비디아의 최고사양 제품인 H100보다 우위를 점하는 부분이 있기 때문이다.

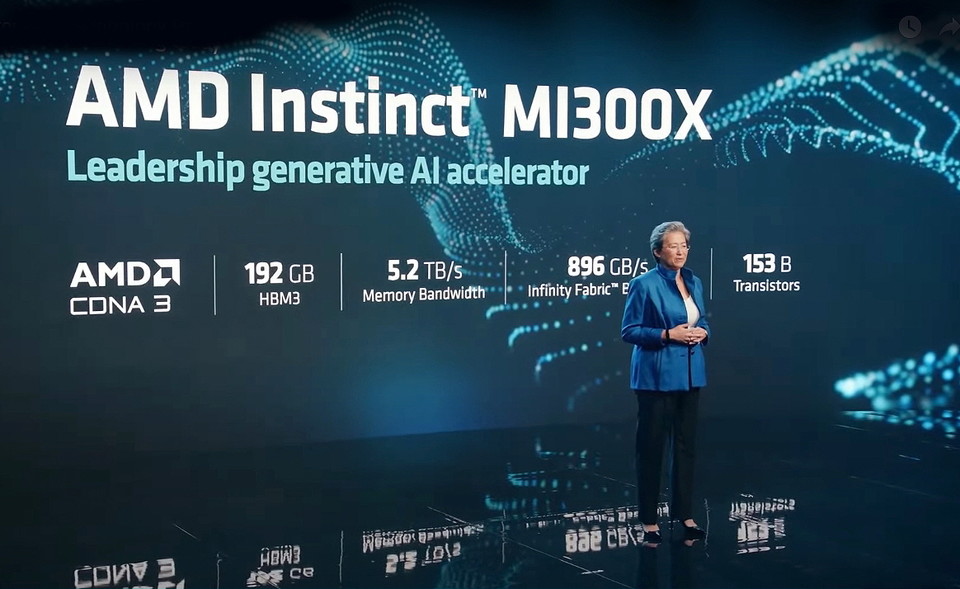

MI300X 가속기는 AMD CDNA 3 아키텍처 기반으로 최대 192GB의 HBM3 메모리를 지원해 LLM 훈련과 생성 AI 워크로드에 필요한 컴퓨팅 및 메모리 효율성을 제공한다. 반면, 엔비디아 H100은 120GB의 메모리만 지원한다. 생성 AI는 보다 많은 메모리를 사용하기 때문에 더 큰 메모리를 지원한다는 것은 그많큼 성능에서 우위를 점할 수 있다는 것이다.

HPC 및 AI 워크로드를 위한 세계 최초의 APU(Accelerated Processing Unit) 가속기 MI300X는 대용량 메모리를 지원해 하나의 가속기에 매개변수가 400억 개인 팔콘-40(Falcon-40)과 같은 LLM을 장착할 수 있다. 이어 소개된 AMD 인스팅트 플랫폼(AMD Instinct Platform)은 8개의 MI300X 가속기를 산업 표준 디자인으로 결합해 향상된 AI 추론 및 훈련을 위한 솔루션을 지원한다.

이날 AMD CEO 리사 수(Lisa Su) 박사는 기조연설을 통해 “AI는 차세대 컴퓨팅을 형성하는 핵심 기술이자 AMD에게 가장 큰 전략적 성장 기회로서, 세계 최고 수준의 인스팅트 MI300 가속기의 올해 말 출시와 하드웨어에 최적화된 엔터프라이즈용 AI 소프트웨어의 생태계 성장을 발판 삼아 데이터 센터에서 대규모 AMD AI플랫폼 구축을 가속화하는 데 주력할 계획이다”고 밝혔다.

AMD는 오는 3분기부터 주요 고객사에게 MI300X 가속기 시제품을 제공 예정이다. 현재, 주요 고객사에 시제품을 공급 중이다.

한편, 이날 AMD는 데이터 센터 가속기를 위한 ROCm 소프트웨어 생태계를 선보이며, 개방형 AI 소프트웨어 생태계 구축을 위한 주요 협력사와의 협업을 강조했다. 파이토치는 AMD 인스팅트 가속기에서 ROCm 5.4.2 버전 출시와 동시에 파이토치 2.0을 지원하는 등 ROCm 소프트웨어 스택을 활용한 양사의 협업 사례를 소개했다.

이를 통해 개발자들은 AMD 가속기에 파이토치 기반의 대규모 AI 모델을 즉시 활용할 수 있다. AI 구축 플랫폼 허깅페이스(Hugging Face)는 AMD 인스팅트 가속기, 라이젠 (Ryzen) 및 EPYC 프로세서, 라데온(Radeon) 그래픽, 버설(Versal), 알베오 (Alveo)를 비롯한 AMD 플랫폼에 수천 개의 허깅페이스 모델을 최적화할 예정이라고 밝혔다.