개발한 BPipe는 학습 시 저장해야 하는 중간 계산 결과물을 메모리 여유가 있는 GPU에 맡겨 두는 새로운 파이프라인 병렬화 방법으로 메모리 불균형을 해결

생성 AI 서빙 엔진 페리플로우(PeriFlow)를 제공하는 스타트업 ‘프렌들리에이아이(FriendliAI. 대표 전병곤)가 챗GPT와 같은 대형언어모델(LLM)의 학습 효율을 획기적으로 끌어올리는 ‘BPipe(비파이프)’ 시스템을 개발했다.

최근 챗GPT로 인하여 화두가 되고 있는 초거대 언어모델은 수백에서 수천억 개의 파라미터(매개변수)를 가지고 계산하여 여러가지 언어 생성 업무에서 뛰어난 결과들을 만들어 내는 기술로, 다양한 분야에 활용되고 있다.

초거대 언어모델 분야가 발전하면서 초거대 언어모델을 효율적으로 학습하는 기술도 중요해지고 있다. 초거대 언어 모델을 학습하기 위해서는 엄청난 수의 파라미터(매개변수) 때문에 분산학습이 필수적이다.

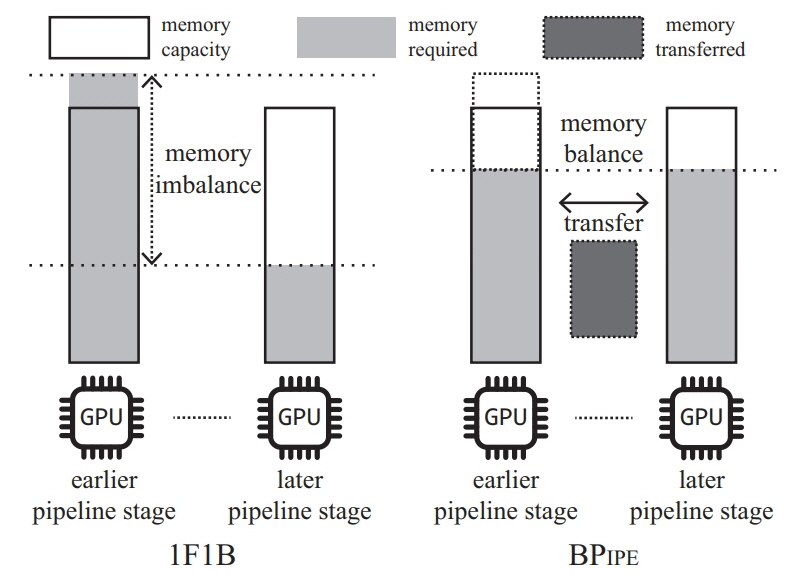

분산학습 기술 중 하나인 ‘파이프라인 병렬화’는 서로 다른 GPU가 초거대 언어모델 내의 서로 다른 레이어들을 파이프라인화 하여 처리하는 기술이다. 해당 기술은 각 GPU가 최대로 사용하는 메모리에서 각각 불균형이 생긴다는 단점이 있다.

프렌들리에이아이에서 개발한 BPipe는 학습 시 저장해야 하는 중간 계산 결과물을 메모리 여유가 있는 GPU에 맡겨 두는 새로운 파이프라인 병렬화 방법으로 메모리 불균형을 해결한다. 결과적으로 같은 언어 모델을 더 빠르고 효율적으로 학습이 가능하다.

가령, 기존의 파이프라인 병렬화가 여러 일꾼에게 각각 다른 무게의 짐을 들게 하는 방식이라면, BPipe는 가벼운 무게의 짐을 가진 일꾼이 무거운 무게의 짐을 가진 일꾼의 짐을 필요할 때 잠시 맡아주는 방식이다.

이번 개발 및 연구 결과는 23일부터 29일까지 미국 하와이컨벤션센터에서 개최되는 AI 머신러닝 분야 최고권위의 ‘국제머신러닝학회(International Conference on Machine Learning, ICML 2023)’에서 ‘비파이프: 대규모 언어 모델 교육을 위한 메모리 균형 파이프라인 병렬 처리(BPipe: Memory-Balanced Pipeline Parallelism for Training Large Language Models-다운)’이라는 제목으로 학회에 제출된 논문 중에서 상위 2.5% 논문에 주어지는 구두 발표 논문에 채택되어 26일 발표될 예정이다.

한편, 프렌들리에이아이는 생성AI 서빙에 관한 기업들의 페인 포인트를 해결해주는 딥테크 기업으로, 지난해 GPT-3와 같은 언어 모델의 효율을 높이기 위한 ‘동적 배치 처리’와 ‘선택적 배치 처리’라는 핵심 기술을 적용한 엔진을 발표한 바 있다.