Qwen-VL은 70억 개 매개변수로 구성된 대규모 언어 모델인 통이치엔원의 멀티모달 버전으로, 모델스코프(ModelScope)에서 오픈소스로 제공

알리바바 그룹의 디지털 기술 및 인텔리전스 중추인 알리바바 클라우드가 개방형 대규모 시각 언어 모델(Large Vision Language Model, 이하, LVLM) 'Qwen-VL'과 대화형 모델 'Qwen-VL-Chat'을 출시했다. 두 모델은 프롬프트의 이미지, 텍스트 및 경계상자를 이해할 수 있으며 영어와 중국어로 다중 라운드 질문에 대한 답변을 지원한다.

먼저, Qwen-VL은 알리바바 클라우드의 70억 개 매개변수로 구성된 대규모 언어 모델인 통이치엔원 (Tongyi Qianwen)의 멀티모달 버전으로, 모델스코프(ModelScope)에서 오픈소스로 제공된다. 영어와 중국어로 된 이미지 입력과 텍스트 프롬프트를 이해할 수 있는 Qwen-VL은 다양한 이미지와 관련된 개방형 쿼리에 응답하고 이미지 캡션을 생성하는 등의 다양한 작업을 수행한다.

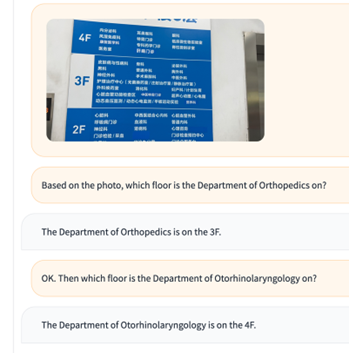

또한 Qwen-VL-Chat은 여러 이미지 입력을 비교하고 다중 라운드 질문에 답변하는 등 보다 복잡한 상호 작용에 적합하다. 해당 모델은 정렬 기술을 활용해 입력 이미지를 기반으로 시와 이야기를 창작하고, 여러 사진의 내용을 요약하고, 이미지에 표시된 수학 문제를 푸는 등 다양한 창의적인 역량을 발휘할 수 있다.

알리바바는 AI 기술의 대중화를 위해 모델의 코드와 가중치 문서를 전 세계 학계, 연구원, 상업 기관과 공유했다. 이러한 오픈 소스 커뮤니티에 대한 기여는 알리바바의 AI 모델 커뮤니티인 모델스코프와 협업 AI 플랫폼인 허깅페이스(Hugging Face)에서 확인 가능하다. 단, 상업적 용도의 경우, 월간 활성 사용자가 1억 명 이상인 기업은 알리바바 클라우드에 라이선스를 요청할 수 있다.

이미지에서 의미와 정보를 추출하는 기능을 갖춘 모델들의 도입은 시각 콘텐츠와의 상호 작용을 혁신할 수 있는 잠재력을 갖는다. 예를 들어, 이미지 이해와 질문답변 기능은 온라인 쇼핑 시 시각 장애인에게 정보를 지원하는 데에 향후 활용될 수 있다.

Qwen-VL모델(다운)은 이미지와 텍스트 데이터 세트에 대한 사전 학습을 거쳤다. 224x224 해상도의 이미지를 처리하고 이해할 수 있는 다른 대규모 언어 모델에 비해 Qwen-VL은 448x448 해상도의 이미지 입력을 처리할 수 있어 뛰어난 이미지 인식과 이해도를 갖는다.

다양한 벤치마크 테스트에서 Qwen-VL은 제로샷 캡셔닝, 일반적인 시각 질문 답변, 텍스트 지향 시각적 질문 답변, 물체 감지 등 여러 시각 언어 작업에서 뛰어난 성능을 기록했다.

알리바바 클라우드의 벤치마크 테스트에 따르면 Qwen-VL-Chat(다운)은 중국어와 영어 모두에서 텍스트-이미지 대화와 인간과의 일치 수준에서 최고의 결과를 달성했다. 테스트에는 300개 이상의 이미지, 800개 질문, 27개 카테고리가 포함됐다.

한편, 이달 초, 알리바바 클라우드는 오픈 소스 커뮤니티에 대한 지속적인 기여의 일환으로 70억 개의 파라미터를 가진 LLM인 Qwen-7B와 Qwen-7B-Chat을 오픈 소스로 공개(다운)했다. 이 두 모델은 출시 한 달 만에 40만 건 이상의 다운로드를 기록했다.