도시나 시골의 건물이나 다리, 벽 등의 지형 및 사물을 효율적으로 이용하여 민첩하게 이동하는 운동경기인 '파쿠르(Parkour)'와 같이 로봇이 스스로 선택하고 민첩하게 실행할 수 있는 운동 지능을 갖추고 있다.

美스탠포드대학교(Stanford University)과 중국 상하이 치지 연구소((Shanghai Qizhi Research Institute)의 인공지능(AI) 연구원들이 네 발 달린 로봇이 단순화된 머신러닝을 통해 AI 개발자 및 연구자들이 이전과는 전혀 다른 방식으로 뛰어넘고, 문턱 아래로 기어가고, 틈새를 비집고 빠져나가는 등 물리적 장벽을 통과할 수 있는 'AI 알고리즘'과 '로보독(Robodog)'을 개발하고 이 알고리즘을 오픈소스로 공개했다.

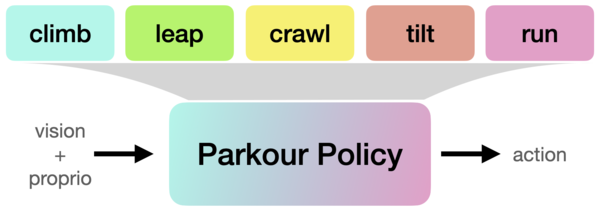

배터리로 구동되는 로봇의 이 새오운 방식의 인공지능 알고리즘은 로봇개의 두뇌에 해당한다. 연구팀의 주요 발전은 그들의 ‘로보독’이 매우 자율적이라는 것이다. 로봇은 단순히 앞에 보이는 장애물을 기반으로 물리적 과제를 규모화하고 추론한 다음 다양한 민첩성 기술을 실행할 수 있다.

즉, 로봇에 장착된 깊이 카메라의 이미지와 AI 머신러닝을 사용하여 모든 입력을 처리하고 다리를 움직여 장애물 위, 아래, 주변을 통과할 수 있도록 지각과 제어를 결합한 것이다(아래 영상은 건너뛰기).

특히, 로봇은 비전과 자율성을 모두 갖추고 있다. A지점에서 B지점까지 맨몸으로 자연(산 등), 도시나 시골의 건물이나 다리, 벽 등의 지형 및 사물 등 맞이하는 장애믈을 효율적으로 이용하여 민첩하게 이동하는 운동 경기인 '파쿠르(Parkour)'와 같이 로봇은 지형과 장애물에 스스로 추론하고 선택하여 실행할 수 있는 운동 지능을 갖추고 있다.

기존 학습 방법은 특정 물리적 장애물에 맞게 미세 조정되어야 하는 복잡한 보상 시스템을 기반으로 하는 경우가 많다. 따라서 새롭거나 낯설고 익숙하지 않은 환경에 맞게 확장하기가 어렵다. 이처럼 기존의 접근법은 실제 데이터를 사용하여 다른 동물의 민첩성 기술을 모방하는 방법을 학습하며, 이 로봇개들은 폭넓은 기술(데이터) 세트가 부족하고 새로운 비전(시력) 능력도 갖고 있지 않으며 두 방법 모두 추론이 어렵거나 매우 지연된다.

그러나 연구팀의 새로운 인공지능 방식 로봇 파쿠르 러닝(Robot Parkour Learning)은 실제, 참조(학습) 데이터를 사용하지 않는 간단한 보상 시스템으로 이러한 목표를 달성하는 서계 최초의 오픈 소스 애플리케이션이다. (아래 영상은 1단계: 소프트 역학 제약 조건을 사용한 RL 사전 학습)

연구팀은 먼저 컴퓨터 모델을 사용하여 알고리즘을 합성하고 학습한 다음 이를 실제 로봇개 두 마리에 전송했다. 다음으로, 강화학습(RL)으로 로봇은 자신이 적합하다고 생각하는 방식으로 앞으로 나아가려고 시도했으며, 얼마나 잘 수행했는지에 따라 보상을 받았다. 이 방식으로 AI가 새로운 과제에 접근하는 가장 좋은 방법을 학습하는 방법이라는 것을 확인했다.(아래 영상은 2단계: 하드 역학 제약 조건을 사용한 RL 미세 조정)

실제로 대부분의 기존 강화학습 보상 시스템에는 너무 많은 변수가 포함되어 효과적이지 않아 계산 성능이 느려진다. 이것은 로보독 파쿠르에 대한 간소화된 보상 프로세스를 예외적으로 만드는 이유이며, 놀라울 정도로 간단하다.

즉, 주로 로봇이 얼마나 앞으로 움직이는지, 그리고 이를 위해 쏟는 노력의 양을 기준으로 삼았다. 결국 로봇은 앞으로 나아갈 수 있는 더 복잡한 운동 기술을 학습하게 된다.

그런 다음, 연구팀은 실제 로봇개를 사용하여 광범위한 실험을 수행하여 로봇개의 기존 컴퓨팅 시스템, 시각 센서 및 전력 시스템만을 사용하여 까다로운 환경에서 새로운 장애물에 접근하는 방식을 입증했다.

이를 적용, 개선된 로봇개는 원래 키의 1.5배가 넘는 장애물을 오를 수 있었고, 길이의 1.5배가 넘는 간격을 도약할 수 있었다. 또 장벽 아래로 3/4까지 기어 다닐 수 있었으며, 너비보다 얇은 틈을 통과하기 위해 몸체를 기울여 통과 할 수 있었다.

스탠포드대학 컴퓨터 과학 및 전기 공학 교수이자 이번 논문의 수석 저자인 첼시 핀(Chelsea Finn)은 "네 발로 걷는 로봇이 학습한 자율성과 복잡한 기술 범위는 매우 인상적인 새로운 AI 접근 방식을 적용했습니다"라며, "또한 우리는 저가의 기성품 로봇(실제로는 두 개의 다른 기성품 로봇)을 사용하여 이 로봇을 만들었습니다"라고 밝혔다.

첼시 핀 교수는 스탠포드 'IRIS(Intelligence through Robotic Interaction at Scale)'의 책임자로 대규모 로봇 상호작용을 통한 지능과 로봇과 다른 에이전트가 학습과 상호작용을 통해 광범위하게 지능적인 행동을 개발 및 연구하고 있다. UC 버클리에서 컴퓨터 공학 박사 학위를, MIT에서 전기 공학 및 컴퓨터 공학 학사 학위를 취득했으며, 구글브레인(Google Brain) 팀의 일원으로 근무하고 있다.

한편, 연구팀은 향후 3D 비전 및 그래픽을 활용하여 시뮬레이션 환경에 실제 데이터를 추가하여 알고리즘에 새로운 수준의 실제 자율성을 부여할 수 있기를 희망한다.

이 연구 결과는 '로봇 파쿠르 학습(Robot Parkour Learning-다운)'란 제목으로 오는 11월 6일부터 9일까지 미국 애틀랜타에서 개최되는 '2023 로봇학습 컨퍼런스(Conference on Robot Learning, CoRL 2023)'에서 발표될 예정이며, 관련 코드는 깃허브(다운)를 통해 현재 공개돼 있다(아래는 시연 영상.) 보다 자세한 연구 내용은 '로봇 파쿠르 학습' 프로젝트 사이트(보기)를 참고하면 된다.