멀티 모달 이미지 생성 AI 모델 개발 및 배포 분야의 혁신적인 스타트업 스태빌리티 AI(Stability AI)는 새로운 경량화 대형언어모델(smaller Large Language Model. 이하, sLLM)로 Stable LM 2 시리즈의 첫 번째 언어 모델인 16억 개 매개변수의 기본 모델로 인스트럭션 튜닝(특정의 지시에 근거해 튜닝한) 버전인 'Stable LM 2 1.6B'모델을 지난 19일(현지시간) 공개했다.

스태빌리티 AI의 이 모델은 현재까지 가장 강력한 sLLM 중 하나로 지난 16일 출시한 'Stable Code 3B(다운)'에 이은 2024년에 출시한 두 번째 모델이다.

'Stable LM 2 1.6B' 모델은 영어, 스페인어, 독일어, 이탈리아어, 프랑스어, 포르투갈어, 네덜란드 등 다국어 데이터를 통합하여 약 2조 개의 토큰으로 학습되었다. 언어 모델링의 최근 알고리즘 발전을 활용하여 속도와 성능 간의 균형을 맞추고, 적당한 리소스로 빠른 실험과 배포를 가능하게 했다.

이번 릴리스에서는 오픈 커뮤니티에서 비슷한 성능의 모델을 재현할 수 있도록 데이터 세부 정보도 함께 제공된다. 이와 함께, 최근 일부 사전 학습된 모델의 경우 최적화 후반 단계로 인해 미세 조정이 어려울 수 있으므로 개발자가 원활하게 사전 학습과 데이터 미세 조정을 계속할 수 있도록 최적화 상태를 포함한 쿨다운 전 최종 사전 학습 체크포인트를 처음으로 공개했다.

앞으로 데이터 조합과 학습 절차에 대해 자세히 설명하는 포괄적인 기술 보고서를 공유할 예정이다.

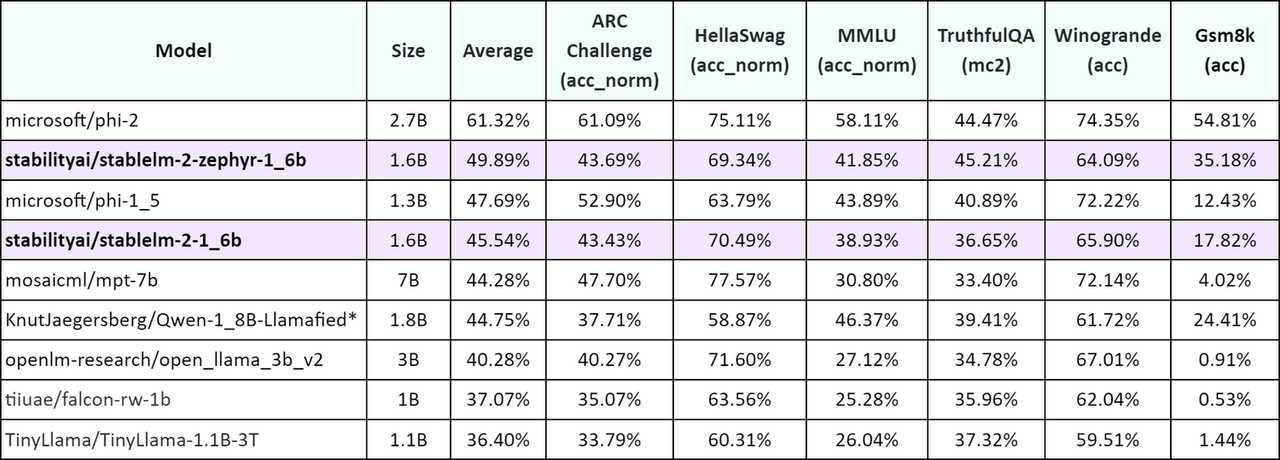

Stable LM 2 1.6B은 모델 성능에서 마이크로소프트의 Phi-1.5(1.3B) 및 Phi-2(2.7B), 티니라마(TinyLlama) 1.1B, 팰컨(Falcon) 1B와 같은 다른 인기 있는 소형 언어 모델과 비교한 허깅페이스(Hugging Face)의 ‘오픈 LLM 리더보드’에서 2B 미만의 모델보다 성능이 뛰어나고 더 큰 모델 보다도 성능이 우수했다(아래 표 참조).

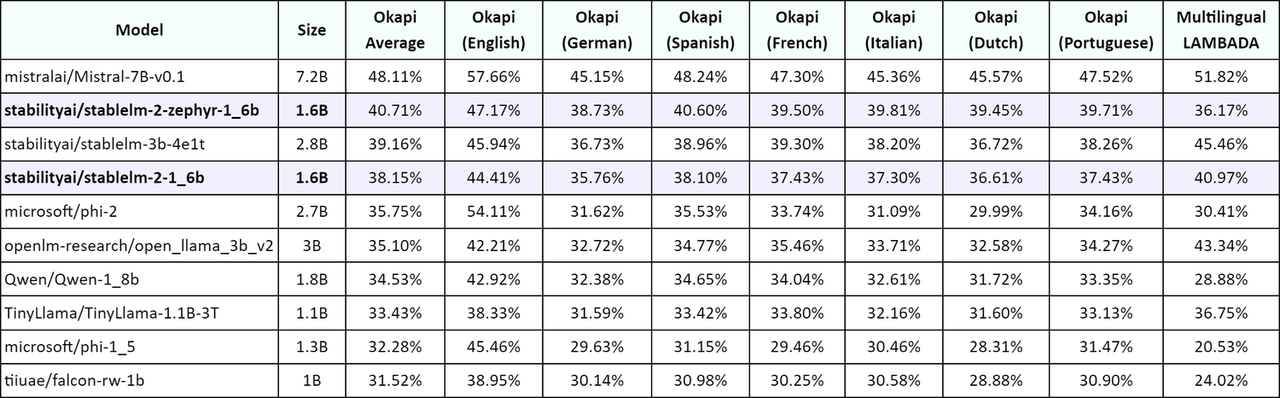

또한 다국어 텍스트에 대한 명시적인 학습 덕분에 ARC Challenge, HellaSwag, TruthfulQA, MMLU 및 LAMBADA의 번역 버전에서 Stable LM 2 1.6B의 성능은 다른 모델을 크게 능가하는 것으로 나타났다(아래 참조).

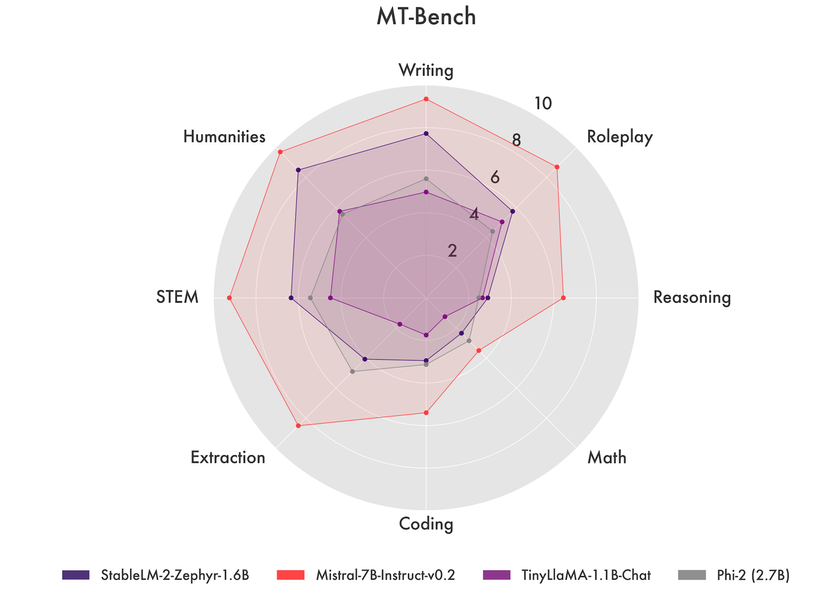

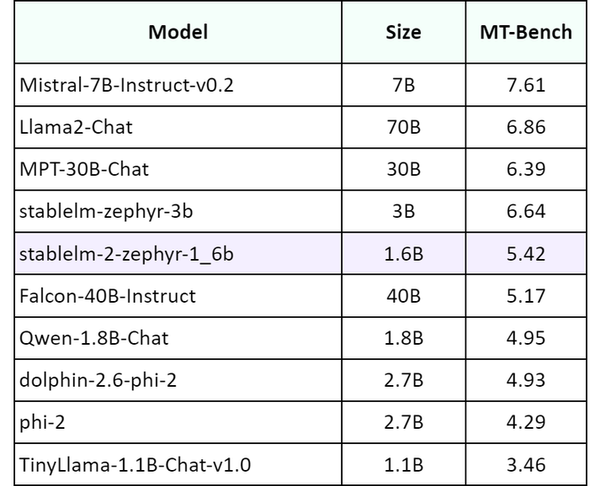

MT-벤치결과에 따르면 Stable LM 2 1.6B는 훨씬 더 큰 모델과 일치하거나 심지어 능가하는 경쟁력 있는 성능을 보였다(아래 참조).

한편, 스태빌리티 AI는 이날 출시와 더불어 현재까지 가장 강력한 sLLM 중 하나를 출시하고 학습 세부 사항에 대한 완전한 투명성을 제공함으로써 다국어 데이터를 통합하는 생성 AI 생태계의 진입 장벽을 낮추고 더 많은 개발자 및 연구자가 실험하고 배포할 수 있도록 지원하는 것을 목표로 한다고 밝혔다.

아울러 작고 저용량 언어 모델의 특성으로 인해 Stable LM 2 1.6B는 환각이나 잠재적인 독성 언어와 같은 일반적인 문제를 유사하게 나타낼 수 있다고 덧붙였다. 현재, Stable LM 2 1.6B 모델은 스태빌리티 AI 멤버십(보기)을 통해 상업적으로나 비상업적으로 사용할 수 있으며 더 자세한 내용은 허깅 페이스(Hugging Face-보기)를 통해 모델 시연 등 참고하면 된다.