모델은 5차원 병렬 기능을 결합해 모델에 적용했으며, CAN4가 구동하는 2048개의 어센드 AI 프로세서 클러스터로 훈련했다. 이 초거대 언어모델 '판구알파(PanGu Alpha)'는 현재, 오픈 소스로 공개된 상태이다.

GPT-3가 공개된 지 11개월이 지났다. 놀라운 성능만큼 유명세도 대단했다.

1,750억개 매개변수의 GPT-3는 역사상 가장 뛰어난 언어 인공지능(AI)가 되었을 뿐 아니라, 역사상 가장 유명한 언어 AI가 된 것이다. 이런 현상은 GPT-3가 타 모델과 차원이 다른 언어 생성 성능을 보여주었기 때문이다.

OpenAI의 GPT-3는 대규모 사전 훈련된 언어모델(Pretrained Language Models. 이하, PLM)은 몇 번의 컨텍스트 내 학습을 통해 자연어 생성에서 우수한 성능을 보여주었다. 그러나 대부분의 언어 모델은 영어로만 제공된다.

GPT-3는 인문·사회과학 분야에서 높은 성능을 보인 반면 공학·자연과학 분야에서는 약한 모습을 보였다. GPT-3 학습에 사용된 데이터가 인문·사회과학적인 데이터에 쏠려있어서 사고력보다는 지식의 양에서 강점이 있다고 볼 수 있다.

여기에, 중국 화웨이가 GPT-3를 넘는 최대 2,000억개의 매개변수를 포함하는 750기가바이트(GB)로 대규모 자연어처리(NLP) 모델인 '판구 알파(PanGu Alpha)'를 개발하고 지난달 26일 아카이브를 통해 공개했다.

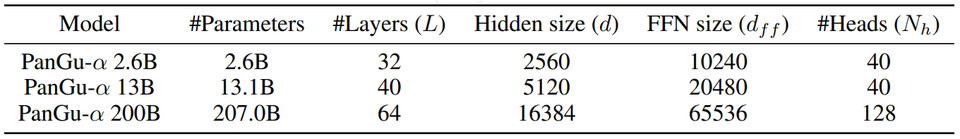

화웨이 연구팀은 이 초거대 언어모델 설계에서 트랜스포머(Transformer) 기반 자기회귀언어(Autoregressive Language) 모델을 기본 아키텍처로 선택했다. 또, 다른 쿼리 레이어가 트랜스포머 레이어 위에 추가되어 모델이 최대 2,000억 개의 매개 변수를 확장할 수 있게 된 것이다.

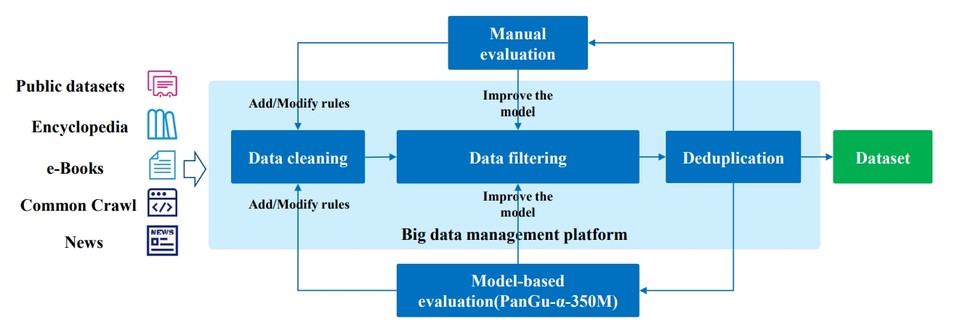

학습을 위해 데이터의 양이 큰 PLM을 공급하기에 충분해야 하며 다른 한편으로는 모델의 일반성을 보장하기 위해 높은 품질과 다양성을 가져야 한다. 화웨이 연구팀은 중국어로 된 전자책, 백과사전, 뉴스, SNS, 웹페이지 등에서 80테라비트(TB)의 원시 데이터를 수집했다.

대규모 말뭉치 전처리를 위한 분산 클러스터를 구축하고 불쾌한 단어, 스팸, 저품질 데이터 정리 및 필터링, 중복 제거, 품질 평가 및 기타 처리 절차를 통해 약 1.1TB의 고품질 중국 말뭉치 데이터 세트를 구축했다.

특히, 2000억개의 파라미터를 가진 판구 알파의 메모리 요구조건은 현대 AI 프로세서의 범위를 넘어선다. 하드웨어 토폴로지를 고려할 때 이 문제는 더욱 어려워진다. 이에 연구팀은 5차원 병렬 기능을 결합해 모델에 적용했으며, CAN4가 구동하는 2048개의 어센드 AI 프로세서 클러스터로 훈련했다.

연구팀은 매개변수 크기의 크기가 증가하는 고품질 중국어 텍스트 말뭉치에 대해 26억, 130억, 2000억의 세 가지 모델을 훈련시켰다. 모델은 언어 모델링 작업에서 처음 평가되었으며, 모델 용량과 데이터 및 계산 양이 증가함에 따라 복잡성이 감소한다는 점에 주목했다.

또한 연구팀은 대화 생성, 요약 및 질문 답변과 같은 다양한 시나리오에서 모델의 텍스트 생성 능력을 조사하였다. 실험 결과는 일반적으로 모델 용량이 증가함에 따라 모델의 성능이 향상된다는 것을 보여주었다.

한편, 화웨이 연구팀이 공개한 이 초거대 언어모델 '판구 알파(PanGu Alpha)'는 현재 오픈 소스(다운)로 공개된 상태이다. 이 모델은 지난달 26일 아카이브에 '판구 알파: 자동 병렬 컴퓨팅 기능을 갖춘 대규모 자기회귀 사전 훈련 된 중국어 모델(PANGU-α: Large-Scale Autoregressive Pretrained Chinese Language Models With Auto-Parallel Computation- 다운)'이란 제목으로 발표됐다.

관련기사

- [AI 리뷰] 오픈AI, 글 쓰는 GPT-3에서 진화... 텍스트 읽고 그림 그리는 AI 모델 'DALL·E' 및 'CLIP' 공개

- GPT-3는 과연 얼마나 똑똑한 것일까?

- 테슬라 일론 머스크, 오픈AI... 마이크로소프트에 GPT-3 독점 라이선스 부여한 것! 공개 비판

- GPT-3, 왜 요금제를 선택했으며... 마이크로소프트에 독점 라이선스를 부여했나?

- OpenAI, GPT-3 언어 모델... 마이크로소프트, 독점 라이선스 확보

- [영상] 초보자도 쉽게 GPT-3를 사용해 혼자서 GPT-3 모델을 구현한다

- GPT-3... 휼륭하지만 '다섯 가지' 한계를 짚어본다

- GPT-3, 인류 역사상 가장 뛰어난 '언어 인공지능'이다

- [이슈] OpenAI, 혁신적인 AI 자연어처리(NLP) 모델 'GPT-3' 공개

- 페이스북 AI, 한국어 포함한 전 세계 101개국 언어... 다대다 데이터 세트 '플로레스-101' 오픈 소스로 공개

- 텍스트 없는 자연어처리?... 음성 인공지능 NLP 시대 열어, 페이스북 AI ‘생성적 화자 언어 모델’ 오픈 소스로 공개

- 현존하는 초거대 언어 인공지능 모델 ‘GPT-3’ 애저에 개방!...마이크로소프트, 애저 오픈AI 서비스 발표