음성 인식은 초경량, 소형 및 세련된 안경에서 장치를 작동할 수 있도록 훨씬 더 효율적이어야 하며, 사람들이 말하는 것처럼 단어들이 모호해도 문맥을 이해할 수 있어야 하고, 많은 어휘들과 흔하지 않고 아주 전문적인 단어들을 다룰 수 있고, 배경 잡음과 여러 사람이 말하는 어려운 환경에서도 잘 작동할 수 있어야

가상현실보다 한 단계 더 나아가 사회·경제적 활동까지 이뤄지는 온라인 공간, 메타버스(Metaverse)의 중요한 부분이 될 것으로 예상되는 새로운 증강현실(AR) 경험을 창출하려면 컴퓨터 비전 이상의 기술적 돌파구는 필수적이다.

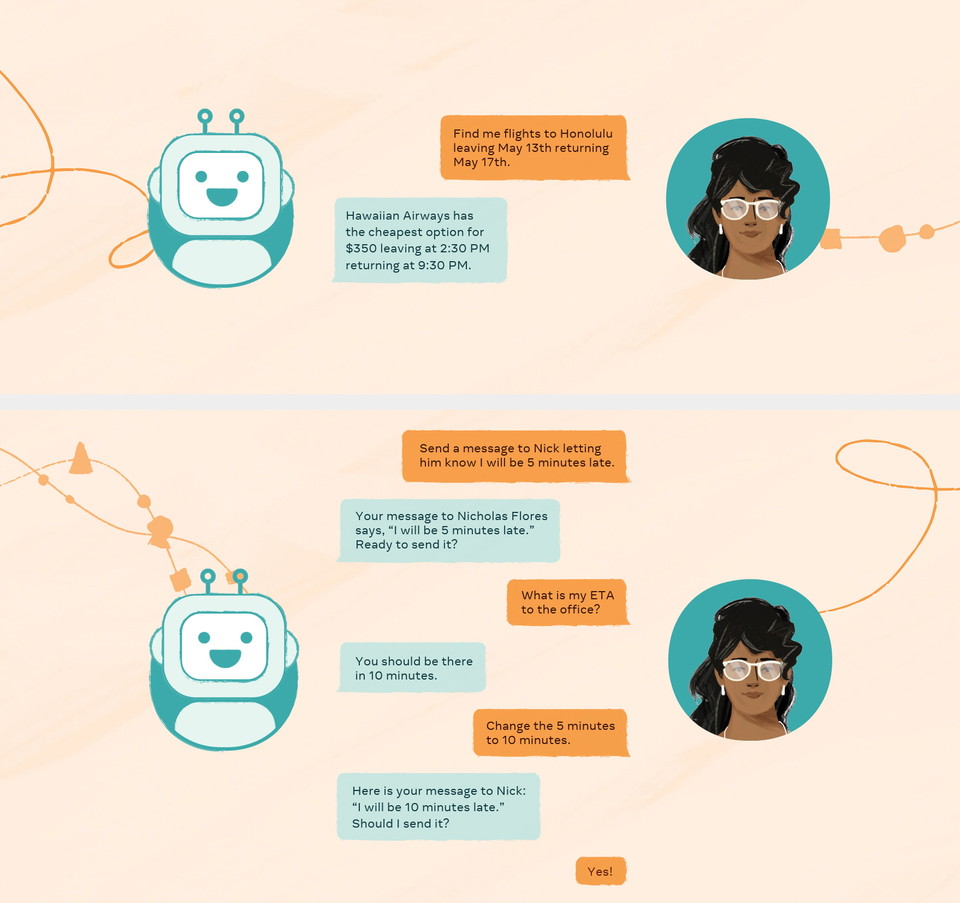

자연스럽고 인간의 미묘한 대화 언어를 이해할 수 있는 인공지능(AI) 어시스턴트는 단순히 핸즈프리 전화를 걸거나 휴대폰에서 앱을 열 수 있도록 도와주는 것 이상의 것을 할 수 있는 차세대 음성 시스템이 필요한 시점이다.

즉, 음성 인식 시스템은 초경량, 소형 및 세련된 안경에서 장치를 작동할 수 있도록 훨씬 더 효율적이어야 하며, 그들은 훨씬 더 정확하고 견고해야 한다. 사람들이 말하는 것처럼 단어들이 모호해도 문맥을 이해할 수 있어야 하고, 많은 어휘들과 흔하지 않고 아주 전문적인 단어들을 다룰 수 있고, 배경 잡음과 여러 사람이 말하는 어려운 환경에서도 잘 작동할 수 있어야 한다.

실제 요구 사항에 대한 음성 인식 개선

여기에, 메타(Meta)의 음성 인식 시스템은 이미 제품과 서비스에서 점점 더 중요한 부분으로 작용하고 있다. 최근, 새로운 음성 기능을 사용하여 많은 앱에서 비디오 캡션 기능 제공하고 청각장애인이거나 난청이 있는 사람들은 여러 제품에서 동영상의 고품질 자막을 읽을 수 있기 때문에 접근성에 있어 훌륭한 결과이다.

또한, 페이스북과 인스타그램 스토리의 캡션은 사람들이 자신을 창의적으로 표현하기 위해 글꼴, 색상, 위치를 조정하면서 이야기의 시각적 표현의 필수적인 부분이 되었다. 메타의 음성 기술은 현재 포털, 퀘스트(Quest), 레이밴(Ray-Ban) 스토리 장치에서도 핸즈프리 음성 인터랙션을 지원하고 있다.

희귀 단어 인식 향상

많은 경우에 단어 오류율이 평균적으로 상당히 낮더라도 특정 중요한 단어를 잘못 인식하면 경험을 망칠 수 있다. 희귀하거나 이전에 볼 수 없었던 단어를 인식하는 것은 널리 사용되는 RNN-T 모델과 같은 최신 "종단 간" 음성 인식 시스템에서 특히 어렵다.

이 문제를 해결하기 위해, 메타는 이전에 트라이 기반 심층 바이어싱 및 신경망 언어 모델의 상황별 음성인식을 통합하고(논문) 지난 5월 22일부터 27일까지 싱가포르에서 온·오프라인 동시 개최된 세계 최고 권위의 '국제 음향 음성 신호처리 학술대회(IEEE International Conference on Acoustics, Speech and Signal Processing, ICASSP 2022)'에서 이 작업을 더욱 개선하는 '신경-FST 클래스 언어모델(Neural-FST Class Language Model. 이하, NFCLM)'을 제시했다.

NFCLM(논문 및 데이터세트 다운)은 통합 수학 프레임워크를 사용하여 엔티티(예: 노래 요청)와 함께 일반적인 배경 텍스트 및 구조화된 쿼리를 모델링한다. 이는 희귀 단어와 더 일반적인 단어 사이의 더 나은 성능 트레이드오프(Trade Off)를 달성하는 동시에 10배 이상 작다는 추가적인 이점을 갖는 모델을 만든다.

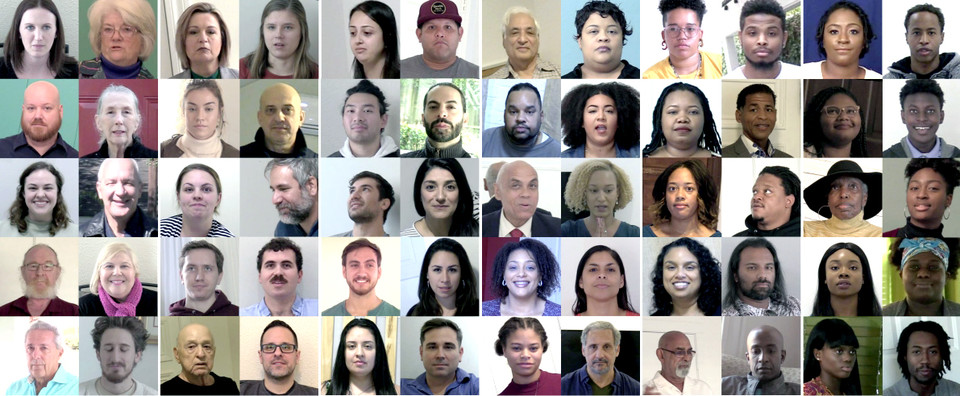

공정성 및 책임있는 AI 음성 인식

메타가 초점을 맞춘 또 다른 영역은 공정성과 책임있는 AI이다. 연구 커뮤니티에서 사용되는 기본 단어 오류율 메트릭은 데이터 세트의 총 오류 수를 나타내는 단일 숫자에 중점을 두지만, 서로 다른 모집단에 걸친 성능 차이를 포착하지는 못한다.

Meta AI는 최근 성별, 나이, 피부 톤의 차원을 따라 컴퓨터 비전 시스템의 공정성을 측정하도록 설계된 비디오 세트인 '일상적인 대화 데이터 세트Casual Conversations Dataset-다운, 논문-다운)'를 출시했다. ICASSP에서, 메타는 성별과 피부 톤에 걸쳐 유의한 변화가 관찰된 동일한 차원을 따라 이 말뭉치의 음성 인식 성능에 대한 최근 분석을 공유(다운)했다.

메타는 다른 연구자들이 이 문제를 연구하고 모든 모집단에 잘 작동하는 음성 시스템을 만들도록 동기를 부여하고자 인반적인 대화 데이터 세트를 공개적으로 사용할 수 있도록 하고 있다. 또한, 관심 하위 그룹 간의 음성 정확도 차이를 보다 정확하게 측정하고 해석하는 방법을 도입(논문)하고 있다.

제로 샷(Zero-Shot) 및 퓨샷 러닝(Few-Shot Learning)

공정성 개선의 과제 중 하나는 대표적인 훈련 데이터에 대한 접근이다. 일치하는 학습 데이터로 모델을 만드는 한 가지 대안적 접근 방식은 특정 작업(또는 사용자 그룹)에 쉽게 미세 조정할 수 있는 보다 보편적인 모델을 만드는 것이다.

메타는 최근 대규모 준지도 학습(Semi-Supervised Training)을 활용하여 450만 시간 이상의 자동 레이블링 데이터를 사용하여 최대 100억 개의 매개 변수를 가진 ASR 모델(논문)을 만들었다.

또한 공개적으로 사용 가능한 단계적 음성 데이터 세트에서 이 모델을 평가했다. 실어증은 뇌의 일부 손상으로 인해 발생하는 언어 장애이며, 가장 일반적으로 뇌졸중으로 인해 발생한다. 이러한 음성은 음성 인식 시스템이 정확하게 전사하는 데 매우 어렵다.

이에 메타는 자사의 보편적 모델에 비교적 적은 양의 단계적 음성으로 퓨샷 학습(Few-Shot Learning)을 적용했다. 이는 단문 음성으로만 훈련된 시스템보다 오류가 60% 이상 적게 발생하여 보편적 모델이 모든 사람에게 고품질 전사를 제공하는 방법임을 입증했다.

음성 인식은 지난 몇 년 동안 놀라운 발전을 이루었지만 모든 사용 사례에서 잘 작동하고 모든 사람에게 잘 작동하는 시스템을 구축하기 위해서는 여전히 큰 과제가 있다. 메타는 이를 위해 지난 1년 동안 상당한 진전을 이루었지만 그 여정은 1% 완료되었을 뿐이라고 밝혔다.

한편, 이번 ICASSP 2022에서 발표된 Meta AI의 음성 인식 기술 향상을 위한 연구 논문은 아래와 같다.

▷종단간 음성인식을 위한 신경-FST급 언어 모델(Neural-FST class language model for end-to-end speech recognition-다운) ▷음성 인식의 공정성 측정을 향하여: 일반적인 대화 데이터 세트 전사(Towards measuring fairness in speech recognition: Casual conversations dataset transcriptions-다운) ▷ASR의 공정성을 측정하기 위한 모델 기반 접근 방식(Model-based approach for measuring the fairness in ASR-다운)

▷슈퍼넷을 통한 온 디바이스 스트리밍 E2E ASR을 위한 빠른 희소성 최적화(Omni-sparsity DNN: Fast sparsity optimization for on-device streaming E2E ASR via supernet-다운) ▷비인과적 컨볼루션을 이용한 스트리밍 트랜스포머 트랜스듀서 기반 음성 인식(Streaming transformer transducer-based speech recognition using non-causal convolution-다운) ▷대규모 다국어 음성 인식을 위한 유사 라벨링(Pseudo-labeling for massively multilingual speech recognition-다운)

▷단어 순서는 음성 인식에 중요하지 않다(Word order does not matter for speech recognition-다운) ▷가중 유한 상태 변환기의 병렬 구성(Parallel composition of weighted finite-state transducers-다운) ▷토치오디오: 오디오 및 음성 처리를 위한 구성 요소(TorchAudio: Building blocks for audio and speech processing-다운).